Aussagen und Ideen, die verschiedene Personen in Manus Zeitforum der Öffentlichkeit zugänglich gemacht haben.

Zusammengestellt durch Gebhard Greiter mit dem Ziel, bestimmte Diskussionsergebnisse einfacher wieder zu finden.

Beitragsnummern tragen einen Link zurück zur Fundstelle

Allgemeine Relativitätstheorie

Astronomisches

|

|

Bedenkenswertes

|

Rein Begriffliches

Berechenbar ist, was eine Turingmaschine berechnen kann

|

|

Auch Beschleunigung krümmt den Raum

|

Was ist Bewusstsein?

Was Bildungspolitiker nicht zur Kenntnis nehmen wollen

Biologisches Leben

Biologische Wesen

|

Biologie aus quantenmechanischer Sicht

Über Biophotonen

|

|

Definitionen physikalischer Begriffe

Dekohärenz und atomare Energieportionen

Techniken des Denkens

Wo auch manche Physiker Falsches erzählen

|

|

Wie deterministisch ist alles Weltgeschehen?

|

|

Verschränkte Quanten und physikalische Messergebnisse

|

Dimensionen der Natur

|

Wie es zu f r u c h t b a r e n Diskussionen kommt

|

|

Dopplereffekt und damit verwechselbare Effekte

|

Dunkle Energie — die Energie des Vakuums?

Wie könnte dunkle Materie beschaffen sein?

Wird eine supersymmetrische Theorie die Eichtheorien ersetzen?

Relativitätstheorie: Einsteins Feldgleichung

|

|

Einsteins Philosophie

|

|

Elektromagnetismus

Elementarteilchen

Wie es zu Emergenz – spontan entstehender Ordnung – kommt

Auch Energie ist relativ

Über Entropie

Geschichte der Erde und des biologischen Lebens

|

Erst mal nur ein Verdacht ...

|

Was uns oft nicht bewusst ist

Über Evolution

Existenz im logischen Sinne

|

Existenz im Sinne der Natur

Physikalische Experimente

|

|

Bemerkenswerte Forschungsergebnisse

|

|

Freier Wille — nur begrenzt?

Freier Wille — auf Quantenebene sicher NICHT zu verstehen (oder doch?)

Understanding GPS

|

|

Zur Physik der Welt aller Gedanken

|

|

Gehirne, Gedanken und wie Gedanken den Körper steuern (könnten)

Was ist Geist?

Geometrie und Kosmos

|

Wissenschaftsgeschichte

|

Meilensteine neuzeitlicher Geschichte

|

Mögliche Geschwindigkeiten

Zur nicht verhinderbaren Wandlung unserer Gesellschaft

Wirtschaft ohne Ethik — Wollen wir das?

Die logisch problemloseste Definition des Gottesbegriffs

Gott und die Physik

Gedanken zu Amtskirche, Bibel, Religiosität, und Gottesbegriff

Gravitationswellen

Gravitation

|

Auf der Suche nach der Weltformel

|

|

Zu Hans-Peter Dürrs Philosophie

Humanoide Roboter

Wo unsere physikalische Welt nur Illusion ist

Nachrichten sind kodierte Information

Ist Information eine Grundgröße der Natur?

Intelligenz – echte und künstliche

Das verwundbare IoT (Internet der Dinge)

|

|

Synchronicity und der Pauli-Effekt

Kann sich auch in KI Bewusstsein herausbilden?

|

Quantenmechanische Grundbegriffe

|

Kernfusionstechnik (Stand 2011)

Klarstellung oft missverstandener physikalischer Aussagen

Über Systemkomplexität

Der Kosmos: Gedanken über das Allumfassende

Warum manche Kritiker der Stringtheorie mir blind erscheinen

Die Grundkräfte der Natur

Landkarte der Physik

|

|

Wo beginnt Leben?

|

Was genau sollten wir unter » Leben « verstehen?

Licht und Zeit

Logik und formale Logik

Was noch nicht ausdiskutiert ist

|

Materie, Antimaterie, virtuelle Materie

Menschheitsgeschichte

|

|

Wie genau Physiker heute messen können

|

Wie genau ist Einsteins Theorie?

Extrapolierende Physik

|

Etwas Metaphysik

|

|

Metaversen (= durch KI konstruierte Realitäten)

|

|

Objekt vs Modell (in der Physik)

Zum Wesen physikalischer Modelle

Die wirklich fundamentalen Naturgesetze

Naturkonstanten

|

Naturwissenschaft

|

|

Netzartige Strukturen auch im Raum?

Über nichts und das absolute Nichts

Wertvolle Philosophie ist mehr als nur Meinung

|

|

Philosophie der Physik

Kommentare zur Philosophie

Zum Begriff physikalischer Objekte

Physikalisches

|

|

Physiker

|

|

Zentrale Erkenntnisse der Physik

Poesie und Philosophie

|

|

Kirche, Politik und ihre Ehrlichkeit

|

|

QuBits und Quanten-Computer

Theorie der Quantengravitation

Quantenkosmologie

|

Quantenphilosophie

|

Quantensysteme

Über Quantenverschränkung (Quantum Entanglement)

Elementarteilen: Quarks

|

Warum die Zeit wahrscheinlich netzartige Struktur hat

Zur Natur der Raumzeit

Warum es leeren Raum nicht geben kann

Wie real ist die Welt um uns herum?

Zum Recht auf Leben

Die großen Religionen dieser Welt

Erste Roboter, die mit Menschen konkurrieren

|

|

Warum Himmelskörper um sich selbst rotieren

|

|

Über Schwarze Löcher

Relativitätstheorie: Wesentliche Unterschiede zwischen SRT und ART

|

Spezielle Relativitätstheorie

Warum der Materialismus ausgedient hat

|

|

Über Schleifen-Quanten-Gravitation

|

|

Wie ganzheitlich ist die Natur?

Wissenswertes zu Software Engineering

Erst angedachte physikalische Modelle

Die Erde als ( nur erste? ) Heimat der Menschen

|

Wissenswertes zum Spin eines Elementarteilchens

|

Rettet die deutsche Sprache

Zum Standardmodell der Elementarteilchenphysik

|

Sterne, Schwarze Löcher, Wurmlöcher

Durch Naturwissenschaft bestätigte Philosophie

|

Kosmische Strahlung

|

|

Wissenswertes zur Stringtheorie

Teleportation — zwei denkbare Realisierungsvarianten

|

Christliche Theologie

Interessantes zum Tunneleffekt

Machen erst Uhren die Zeit?

Universum

Wo die Natur unscharf wird

|

Unser Universum

Unsere Sonne

|

|

Unterschiede zwischen ...

|

|

Zum Urknall

Protyposis — Urstoff des Universums

|

|

Variable Speed of Light (VSL) Theories

Das Vakuum — ein Spannungsfeld

|

|

Well Defined Degrees of Freedom (WDDF) — Sind sie Kern aller Naturgesetze?

|

Wie wirklich ist die Zeit?

Was ist die Wurzel allen Lebens?

|

Wellen und Quantenradierer — eigentlich gar nichts Geheimnisvolles!

Welle-Teilchen-Dualismus

|

Unser Weltbild muss holistisch werden

Ein recht naheliegendes Weltmodell

Unsere Welt besteht aus ...

Zum Wesen der Natur

|

|

Wirkungsquanten

|

Wo auch Wissenschaft Religion ist

|

|

Etwas Wissenschaftstheorie

Zeitreisen in die Vergangenheit

Ist die Zeit tatsächlich, was sie zu sein scheint?

Alte und neue Vorstellungen zum Wesen der Zeit

Zitate die Kosmologie betreffend

|

Wie wahrscheinlich sind uns unbekannte Zivilisationen im Universum?

|

Zufall — Was genau ist das?

Warum Zukunft ungewiss ist

|

Über Existenz und nur teilweise definierte Zustandsinformation

Das Zwillingsparadoxon im Lichte von SRT und ART

Wie angreifbar uns Software macht

|

|

Wie künstliche Intelligenz uns zur Gefahr werden kann

|

|

Quantenzustand mathematisch beschrieben

|

Zur Relativität kosmischer Abstände

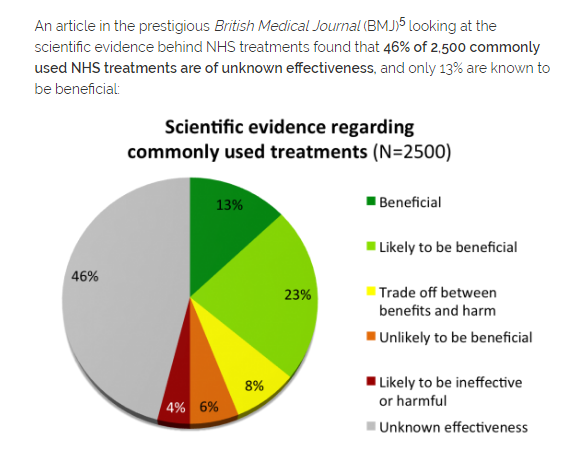

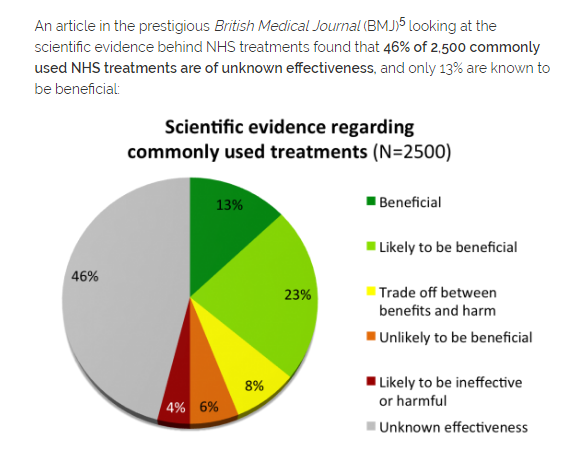

Wie das moderne Gesundheitssystem arbeitet

|

Kreative Computer, z.B. unser Gehirn

|

|

Quanten-Kryptographie

|

|

Zum Realitätsbegriff in der Physik

Zur Relativität von Zeit und Raum

Supersymmetrie

|

Zur wahren Natur aller Quanten

Beitrag 0-546

2022: Die bisher genaueste Messung gravitativer Zeitdilatation

Gravitative Zeitdilatation

und die 2022 präziseste Zeitmessung menschlicher Geschichte

Auch die Stärke von Gravitationspotential hat Einfluss auf den Verlauf der Zeit: In unmittelbarer Nähe eines massereichen Körpers gehen Uhren langsamer als in gewissem Abstand davon. Physiker konnten diese Vorhersage der allgemeinen Relativitätstheorie in den vergangenen Jahrzehnten mehrfach experimentell bestätigen, indem sie Präzisionsuhren mit Flugzeugen oder Raketen auf große Geschwindigkeiten oder Höhen brachten oder ihre Experimente auf Berge oder Türme verlegten.

Nun haben Forscher vom National Institute of Standards and Technology in Boulder (Colorado) den Effekt solch gravitativen Zeitdehnung (Zeitdilatation) dem bislang präzisesten Test unterzogen. Sie haben den Gangunterschied zweier horizontal über einander angeordneter Uhren auf der Millimeterskala verglichen.

Quelle: Einstein hat recht, sogar millimetergenau, FAZ vom 28.2.2022

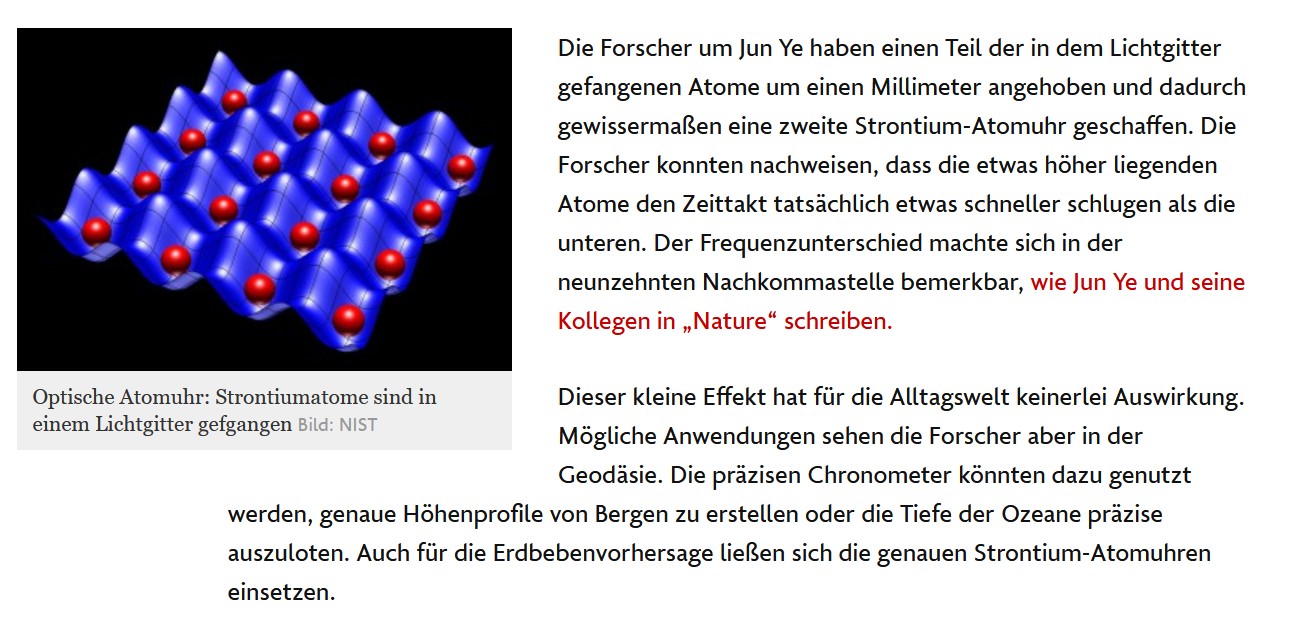

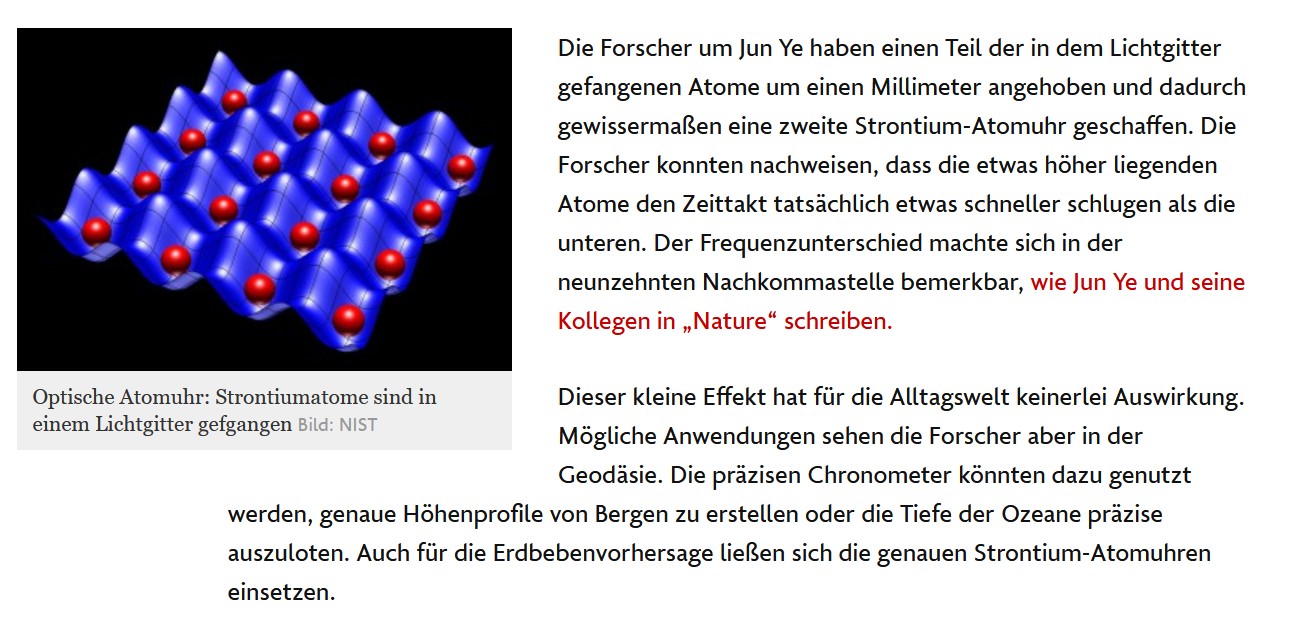

Diese so extrem präzise Messung vorzunehmen verwendeten die Physiker in Boulder für ihre Messungen die derzeit beste optische Atomuhr. Sie geht noch einmal um einen Faktor fünfzig genauer als eine Cäsiumuhr. Rund hunderttausend tiefgekühlte Strontiumatome werden hier mit sich kreuzenden Laserstrahlen in einer optischen Gitterstruktur in der Schwebe gehalten und mit einem extrem stabilen roten Laserstrahl angeregt. Schwingen die Atome und das externe Laserfeld im Takt, wird die Frequenz des von den Atomen ausgesandten Lichts und damit die Taktrate der Strontium-Atomuhr gemessen. Da man viele tausend synchron schlagende Taktgeber vorliegen hat, erreicht man eine deutlich größere Messgenauigkeit, als wenn man mit einem einzelnen Ion arbeiten würde.

Mögliche Anwendungen für derart genaue Messung sehen die Forscher z.B. in der Geodäsie. Die präzisen Chronometer könnten dazu genutzt werden, genaue Höhenprofile von Bergen zu erstellen oder die Tiefe der Ozeane präzise auszuloten. Sogar für die Erdbebenvorhersage ließen sich die genauen Strontium-Atomuhren einsetzen.

|

Diese neue Messung verbessert deutlich den bisherigen Rekord aus 2010, auf den in (2010) hingewiesen wird wie folgt:

"According to general relativity, atomic clocks at different elevations in a gravitational field tick at different rates. The frequency of the atoms' radiation is reducedshifted toward the red end of the electromagnetic spectrumwhen observed in stronger gravity, closer to Earth. That is, a clock ticks more slowly at lower elevations. This effect has been demonstrated repeatedly; for example, NIST physicists measured it in 2010 by comparing two independent atomic clocks, one positioned 33 centimeters (about 1 foot) above the other".

und die 2022 präziseste Zeitmessung menschlicher Geschichte

Auch die Stärke von Gravitationspotential hat Einfluss auf den Verlauf der Zeit: In unmittelbarer Nähe eines massereichen Körpers gehen Uhren langsamer als in gewissem Abstand davon. Physiker konnten diese Vorhersage der allgemeinen Relativitätstheorie in den vergangenen Jahrzehnten mehrfach experimentell bestätigen, indem sie Präzisionsuhren mit Flugzeugen oder Raketen auf große Geschwindigkeiten oder Höhen brachten oder ihre Experimente auf Berge oder Türme verlegten.

Nun haben Forscher vom National Institute of Standards and Technology in Boulder (Colorado) den Effekt solch gravitativen Zeitdehnung (Zeitdilatation) dem bislang präzisesten Test unterzogen. Sie haben den Gangunterschied zweier horizontal über einander angeordneter Uhren auf der Millimeterskala verglichen.

Quelle: Einstein hat recht, sogar millimetergenau, FAZ vom 28.2.2022

Diese so extrem präzise Messung vorzunehmen verwendeten die Physiker in Boulder für ihre Messungen die derzeit beste optische Atomuhr. Sie geht noch einmal um einen Faktor fünfzig genauer als eine Cäsiumuhr. Rund hunderttausend tiefgekühlte Strontiumatome werden hier mit sich kreuzenden Laserstrahlen in einer optischen Gitterstruktur in der Schwebe gehalten und mit einem extrem stabilen roten Laserstrahl angeregt. Schwingen die Atome und das externe Laserfeld im Takt, wird die Frequenz des von den Atomen ausgesandten Lichts und damit die Taktrate der Strontium-Atomuhr gemessen. Da man viele tausend synchron schlagende Taktgeber vorliegen hat, erreicht man eine deutlich größere Messgenauigkeit, als wenn man mit einem einzelnen Ion arbeiten würde.

Mögliche Anwendungen für derart genaue Messung sehen die Forscher z.B. in der Geodäsie. Die präzisen Chronometer könnten dazu genutzt werden, genaue Höhenprofile von Bergen zu erstellen oder die Tiefe der Ozeane präzise auszuloten. Sogar für die Erdbebenvorhersage ließen sich die genauen Strontium-Atomuhren einsetzen.

|

Diese neue Messung verbessert deutlich den bisherigen Rekord aus 2010, auf den in (2010) hingewiesen wird wie folgt:

"According to general relativity, atomic clocks at different elevations in a gravitational field tick at different rates. The frequency of the atoms' radiation is reducedshifted toward the red end of the electromagnetic spectrumwhen observed in stronger gravity, closer to Earth. That is, a clock ticks more slowly at lower elevations. This effect has been demonstrated repeatedly; for example, NIST physicists measured it in 2010 by comparing two independent atomic clocks, one positioned 33 centimeters (about 1 foot) above the other".

Beitrag 0-469

Unter welchen Umständen SRT schon ART ist

Unter welchen Bedingungen ein gegebenes Raumzeit-Szenario S

sich per SRT ebenso genau wie per ART durchrechnen lässt

Das sog. Zwillingsparadoxon ist Spezialfall eines Szenarios S, in dem sich zwei Objekte C und D auf unterschiedlichen Weltlinien durch die Raumzeit bewegen.

Die notwendige und hinreichende Bedingung dafür, dass S selbst schon mit Mitteln der SRT — quantitativ wie qualitativ — beliebig genau behandelbar ist, besteht darin, dass S per SRT modellierbar ist.

Dies lässt sich einsehen wie folgt:

Im Sinne der ART ist die Raumzeit eine differenzierbare Mannigfaltigkeit, d.h. wer darin räumlich weit verteilte Szenarien behandeln will, kann sie nur behandeln mit Hilfe von Störungsrechnung und Argumentation in den Tangentenräumen, d.h. anhand sog. » Karten «, deren jede eine offene Umgebung des Ereignisses E(T) zeigt, in dem der Tangentenraum T — ein 4-dimensionaler Vektorraum mit Minkowsi-Metrik — die Raumzeit der ART berührt.

Brauchbar ist jede dieser Karten aber nur bis hin zum Beobachtungshorizont H(E) des Ereignisses E = E(T) = Ursprung des in T genutzten Koordinatensystems.

Aber auch in der Raumzeit gibt es entsprechend große und kleine Regionen, und so komme ich zur Einsicht:

Das Szenario S ist mit Hilfe der SRT genau dann — und in diesem Fall sogar beliebig genau — durchrechenbar, wenn

Dieses Ergebnis bleibt richtig auch für den Fall, dass zwischen den Weltlinien von C einerseits und D andererseits ein oder mehrere Schwarze Löcher liegen (für deren Inneres Karten, welche beide Weltlinien ganz oder teilweise zeigen, natürlich nichts aussagen würden: Jene Karten wären dort einfach nicht definiert).

sich per SRT ebenso genau wie per ART durchrechnen lässt

Das sog. Zwillingsparadoxon ist Spezialfall eines Szenarios S, in dem sich zwei Objekte C und D auf unterschiedlichen Weltlinien durch die Raumzeit bewegen.

Die notwendige und hinreichende Bedingung dafür, dass S selbst schon mit Mitteln der SRT — quantitativ wie qualitativ — beliebig genau behandelbar ist, besteht darin, dass S per SRT modellierbar ist.

Dies lässt sich einsehen wie folgt:

Im Sinne der ART ist die Raumzeit eine differenzierbare Mannigfaltigkeit, d.h. wer darin räumlich weit verteilte Szenarien behandeln will, kann sie nur behandeln mit Hilfe von Störungsrechnung und Argumentation in den Tangentenräumen, d.h. anhand sog. » Karten «, deren jede eine offene Umgebung des Ereignisses E(T) zeigt, in dem der Tangentenraum T — ein 4-dimensionaler Vektorraum mit Minkowsi-Metrik — die Raumzeit der ART berührt.

Brauchbar ist jede dieser Karten aber nur bis hin zum Beobachtungshorizont H(E) des Ereignisses E = E(T) = Ursprung des in T genutzten Koordinatensystems.

Man kann sich das gut vorstellen, indem man sich ein Wasserfahrzeug W vorstellt, mit dessen Hilfe eine Persion P über den Atlantik von z.B. Amsterdam nach z.B. New York reist:

Über weite Strecken der Reise hinweg wird — der Krümmung der Erdoberfläche wegen — keine Küste sichtbar sein, gegen Ende der Reise aber wird sich das ändern: Der Beobachtungshorizont H(P) von P verschiebt sich mit W, so dass die Karten, die man an Bord von W nutzt — sie entsprechen den eben erwähnten "Karten" im Sinne der Differentialgeometrie — ständig ausgetauscht werden müssen.

Nun gibt es aber auch kleine Gewässer, wie etwa den Chiemsee, den zu überqueren man die zu Beginn der Reise gewählte Karte nie auszutauschen braucht, da jeder Weg, den das Schiff W dort nehmen kann, deutlich kürzer ist als der Radius des Beobachtungshorizonts der Ablegestelle.

Aber auch in der Raumzeit gibt es entsprechend große und kleine Regionen, und so komme ich zur Einsicht:

Das Szenario S ist mit Hilfe der SRT genau dann — und in diesem Fall sogar beliebig genau — durchrechenbar, wenn

- eine Raumzeit-Karte K existiert, welche komplett die beiden Weltlinien von C und D zeigt

- und wenn ferner die Weltlinien von C und D durch kein nennenswertes Gravitationsfeld führen.

Dieses Ergebnis bleibt richtig auch für den Fall, dass zwischen den Weltlinien von C einerseits und D andererseits ein oder mehrere Schwarze Löcher liegen (für deren Inneres Karten, welche beide Weltlinien ganz oder teilweise zeigen, natürlich nichts aussagen würden: Jene Karten wären dort einfach nicht definiert).

Beitrag 0-343

Warum Einstein — aber nicht Newton — Gravitationswellen vorhersagen konnte

Warum Einstein (aber nicht Newton) Gravitationswellen vorhersagen konnte

Der Grund hierfür:

Warum das zur Folge hat, dass es Gravitationswellen geben muss, erklärt sehr schön Claus Kiefer auf Seite 64 seines Buches Der Quantenkosmos:

Quelle: Claus Kiefer: Der Quantenkosmos, Fischer 2008, S. 64.

Seit September 2015 wurden bis Ende 2017 schon insgesamt 5 Gravitationswellen nachgewiesen. Eine kam aus einem Ereignis, das 3 Mrd. Lichtjahre von uns entfernt stattfand.

Der Grund hierfür:

- Nach Newton wirkt die Gravitationskraft instantan über beliebige Entfernungen hinweg.

- Nach Einstein aber kann auch Gravitationswirkung sich höchstens mit Lichtgeschwindigkeit ausbreiten.

Warum das zur Folge hat, dass es Gravitationswellen geben muss, erklärt sehr schön Claus Kiefer auf Seite 64 seines Buches Der Quantenkosmos:

Claus Kiefer:

Betrachten wir zwei Körper — A und B —, die sich wegen gravitativer Anziehung aufeinander zu bewegen. Nehmen wir an (jetzt nur als Gedankenexperiment), dass diese Körper, wenn sie aufeinander prallen, durch einen Mechanismus mit Stahlfedern wieder abgestoßen werden und sich zurückbewegen, bevor sie sich erneut annähern.

Bei der Bewegung nach außen spürt A den Zug von B in einer Stärke, wie sie bestand, als sie sich noch etwas näher waren — schließlich braucht die Gravitationswirkung ja eine endliche Zeit, um von B nach A zu gelangen. Die ziehende Kraft von B ist demnach stärker, als sie es bei instantan eintretender Wirkung wäre.

Umgekehrt süprt auf dem Weg nach innen A die Kraft von B wie sie bestand, als sie noch weiter voneinander entfernt waren — schwächer also, als das bei instantaner Wirkung der Fall wäre.

Deshalb wird auf dem Weg nach außen mehr Arbeit geleistet als auf dem Weg nach innen wieder zurückgewonnen wird. Da die Gesamtenergie erhalten bleibt, muss ein Teil der Energie den lokalen Bereich der Massen verlassen haben: als Gravitationswelle.

Seit September 2015 wurden bis Ende 2017 schon insgesamt 5 Gravitationswellen nachgewiesen. Eine kam aus einem Ereignis, das 3 Mrd. Lichtjahre von uns entfernt stattfand.

Beitrag 0-20

Wo die ART allzu ungenau wird

Wo die ART zu ungenaue Aussagen macht

Einsteins Allgemeine Relativitätstheorie (ART) ist eine Theorie, die davon ausgeht, dass alle Kräfte, die wirken — und so zur Krümmung des Raumes beitragen —, sich exakt so verhalten, wie die Gravitationskraft.

Somit kann die ART natürlich auch nur dort brauchbar sein, wo die Gravitationskraft die vorherrschende Kraft ist.

Da sie nun aber die schwächste aller Grundkräfte ist, wird das sicherlich nicht dort der Fall sein, wo aufgrund kurzer oder sehr kurze Abstände kaum Masse vorhanden sein kann: dort also, wo z.B. die starke Kernkraft den überwiegenden Anteil am Kraftpotential ausmacht — allgemeiner: wo die Summe aller wirkenden Kräfte fast ausschließlich durch Kräfte zustandekommt, die auf dort vorhandene Objekte völlig a n d e r s als die Gravitationskraft einwirken.

Objekte in diesem Sinne sind E n e r g i e t r ä g e r (also keineswegs nur aus Masse bestehende Objekte).

Was bislang fehlt, ist eine Gleichung, die das Wirken aller 4 Grundkräfte auf Energieportionen welcher Art auch immer gleichermaßen gut beschreibt.

Gutes Beispiel einer Kraft, die anders wirkt als die Gravitationskraft, ist die elektromagnetische Kraft:

Sie nämlich wirkt nur auf Objekte, die Ladung tragen.

Einsteins Allgemeine Relativitätstheorie (ART) ist eine Theorie, die davon ausgeht, dass alle Kräfte, die wirken — und so zur Krümmung des Raumes beitragen —, sich exakt so verhalten, wie die Gravitationskraft.

Da sie nun aber die schwächste aller Grundkräfte ist, wird das sicherlich nicht dort der Fall sein, wo aufgrund kurzer oder sehr kurze Abstände kaum Masse vorhanden sein kann: dort also, wo z.B. die starke Kernkraft den überwiegenden Anteil am Kraftpotential ausmacht — allgemeiner: wo die Summe aller wirkenden Kräfte fast ausschließlich durch Kräfte zustandekommt, die auf dort vorhandene Objekte völlig a n d e r s als die Gravitationskraft einwirken.

Objekte in diesem Sinne sind E n e r g i e t r ä g e r (also keineswegs nur aus Masse bestehende Objekte).

Was bislang fehlt, ist eine Gleichung, die das Wirken aller 4 Grundkräfte auf Energieportionen welcher Art auch immer gleichermaßen gut beschreibt.

Sie nämlich wirkt nur auf Objekte, die Ladung tragen.

Beitrag 0-115

Wie Einsteins Feldgleichung zu lesen ist

Was die Feldgleichung der Allgemeinen Relativitätstheorie uns sagt

Die Minkoski-Metrik der ART ist gegeben durch die Gleichung

s2 = gtt (ct)2 – gtx t x – gxx x2

Da nun aber stets gtt ≤ 1 ≤ gxx ist und die Gleichheitszeichen nur im gravitationsfreien Raum gelten, erkennt man:

Die Größe gtt sagt uns, wie die lokale Krümmung der Raumzeit den Lauf einer Uhr verlangsamt,

gxx aber legt fest, wie die lokale Krümmung der Raumzeit räumliche Abstände streckt.

Genauer: Die Größe t entspricht Zeitintervallen, wie eine im gravitationsfreien Raum befindliche Uhr sie misst,

τ = gtt1/2 t aber nennt die Eigenzeit auch beschleunigter Uhren.

Bezeichnen wir die Stärke der Raumkrümmung mit R und die Energie (bzw. Masse) mit E, so haben Einsteins Gleichungen die einfache Form

R = κ E

Hier ist κ = 8πG/c4 die sog. Einsteinsche Gravitationskonstante (proportional zur Newtonschen Gravitationskonstanten G).

Würden wir in einer Welt leben, in der G = 0 ist, gäbe es keinerlei Krümmung des Raumes.

In einer Welt, in der die Lichtgeschwindigkeit größer ist als in unserem Universum, würde die Raumkrümmung deutlich schwächer ausfallen als bei uns.

Quelle: Dieter Lüst: Quantenfische, DTV 2014, S. 174-176

Die Minkoski-Metrik der ART ist gegeben durch die Gleichung

Da nun aber stets gtt ≤ 1 ≤ gxx ist und die Gleichheitszeichen nur im gravitationsfreien Raum gelten, erkennt man:

gxx aber legt fest, wie die lokale Krümmung der Raumzeit räumliche Abstände streckt.

Genauer: Die Größe t entspricht Zeitintervallen, wie eine im gravitationsfreien Raum befindliche Uhr sie misst,

τ = gtt1/2 t aber nennt die Eigenzeit auch beschleunigter Uhren.

Bezeichnen wir die Stärke der Raumkrümmung mit R und die Energie (bzw. Masse) mit E, so haben Einsteins Gleichungen die einfache Form

Hier ist κ = 8πG/c4 die sog. Einsteinsche Gravitationskonstante (proportional zur Newtonschen Gravitationskonstanten G).

Würden wir in einer Welt leben, in der G = 0 ist, gäbe es keinerlei Krümmung des Raumes.

In einer Welt, in der die Lichtgeschwindigkeit größer ist als in unserem Universum, würde die Raumkrümmung deutlich schwächer ausfallen als bei uns.

Quelle: Dieter Lüst: Quantenfische, DTV 2014, S. 174-176

Beitrag 0-453

Wie extrem genau Uhren die Relativität der Zeit bestätigen

Wie extrem genaue Atomuhren

die durch SRT und ART vorausgesagte Zeitdilatation bestätigen

In einem der Bücher des theoretischen Physikers Jörg Resag liest man:

Quelle: Jörg Resag: Die Entdeckung des Unteilbaren, Kap 7

die durch SRT und ART vorausgesagte Zeitdilatation bestätigen

In einem der Bücher des theoretischen Physikers Jörg Resag liest man:

Jörg Resag (2012):

Eine sich bewegende Uhr läuft für einen ruhenden Beobachter langsamer als eine ruhende Uhr (spezielle Relativitätstheorie). Ebenso laufen ruhende Uhren in einem statischen Gravitationsfeld umso langsamer, je weiter unten sie sich befinden (allgemeine Relativitätstheorie).

Mittlerweile gibt es Uhren, die so präzise sind, dass sich diese Effekte auch bei alltäglichen Geschwindigkeiten und Gravitationsfeldern messen lassen.

So haben James Chin-Wen Chou, Dave Wineland und Kollegen am National Institute of Standards and Technology (NIST) in Boulder (Colorado) Uhren verwendet, die auf nur einem einzigen Aluminium-Ion in einer sogenannten Paul-Falle basieren und die in 3,7 Milliarden Jahren nur eine Sekunde falsch gehen.Einfach unglaublich, dass man heute schon Materie derart präzise kontrollieren und manipulieren kann!

Das Aluminium-Ion wird dabei in einem elektromagnetischen Feld festgehalten und mit Lasern gekühlt. Ein anderer Laser feuert nun auf das Ion,

wobei seine Frequenz sehr präzise auf eine Absorptionsfrequenz des Ions abgestimmt wird. Diese Frequenz ist nun der Taktgeber der Uhr. Bei dieser Frequenzabstimmung spielt ein weiteres Ion (ein Magnesium- oder Beryllium-Ion) eine Rolle, dessen Quantenzustand mit dem des Aluminium-Ions verschränkt ist (ähnlich wie die beiden Spin-1/2-Teilchen im Einstein-Podolsky-Rosen-Experiment miteinander verschränkt sind, siehe Kapitel 2.8).

Lässt man nun das Ion bei einer Durchschnittsgeschwindigkeit von nur 10 m/s (= 35 km/h) hin- und heroszillieren, so beobachtet man eine Verlangsamung der darauf basierenden Uhr um etwa den Faktor 10-16.

Auch bei anderen Geschwindigkeiten entspricht die Zeitdilatation genau dem Wert, wie ihn die spezielle Relativitätstheorie vorhersagt.

Ebenso gelingt es, den Zeitunterschied zweier solcher Uhren im Gravitationsfeld der Erde nachzuweisen, die nur etwa 17 cm Höhenunterschied aufweisen. Die untere Uhr läuft dabei um etwa den Faktor 4 × 10-17 langsamer als die obere — das entspricht grob einer zehnmillionstel Sekunde in 80 Jahren.

Mehr dazu in: Relativity with a human touch sowie Handwerkszeug Relativität, Physik Journal 9 (2010) Nr. 11, S. 16.

Beitrag 0-280

Über die Singularitäten der Raumzeit der Allgemeinen Relativitätstheorie

Zu den Singularitäten der Lösungen der ART

Lösungen von Einsteins Feldgleichung der Allgemeinen Relativitätstheorie zu finden, ist i.A. schwierig. Zu lösen ist stets ein Anfangswertproblem.

Um überhaupt eine Lösung finden zu können, geht man meist von Anfangswertproblemen aus, die sich auf recht symmetrische Ausgangssituationen beziehen.

Störend sind natürlich in der Lösung dann gefundene Singularitäten. Sie — so dachte man früher — könnten sich vor allem wegen einer allzu hohen Symmetrie der Ausgangssituation ergeben.

In den Jahren 1965 bis 1970 aber konnten Steven Hawking, Roger Penrose und Brendan Carter zeigen,

Quelle: Gerhard Börner:

Schöpfung ohne Schöpfer? (2006), S. 91

Lösungen von Einsteins Feldgleichung der Allgemeinen Relativitätstheorie zu finden, ist i.A. schwierig. Zu lösen ist stets ein Anfangswertproblem.

Um überhaupt eine Lösung finden zu können, geht man meist von Anfangswertproblemen aus, die sich auf recht symmetrische Ausgangssituationen beziehen.

Störend sind natürlich in der Lösung dann gefundene Singularitäten. Sie — so dachte man früher — könnten sich vor allem wegen einer allzu hohen Symmetrie der Ausgangssituation ergeben.

In den Jahren 1965 bis 1970 aber konnten Steven Hawking, Roger Penrose und Brendan Carter zeigen,

- dass Singularitäten der Raumzeit der ART auch im allgemeinen, nicht-symmetrischen Fall auftreten

- und sich i.W. als stabil gegenüber kleinen Störungen erweisen.

Beitrag 2053-67

Beschleunigung und Raumkrümmung sind dasselbe !!!

Hallo Hans-m,

aus meiner Sicht habt ihr beide recht. Ihr argumentiert lediglich in unterschiedlichen Bezugssystemen:

In Wikipedia liest man:

Mit anderen Worten: Beschleunigung ist eine Art Illusion, die uns in die Wirklichkeit zurückholt, wo wir nichts von Raumkrümmung wissen (bzw. wissen wollen).

Neutraler ausgedrückt: Beschleunigung und Raumkrümmung sind unterschiedliche gedankliche Präsentationen ein und desselben Konzepts der Natur.

Gruß, grtgrt

Hans-m in 2053-65:

Okotombrok in 2053-54:

Die Erde befindet sich im käftefreien Zustand. Man kann sagen, sie fällt um die Sonne herum und der freie Fall ist keine Beschleunigung.

Die Erde bewegt sich nicht im Kreis sondern auf einer Geodäte und das ist niemals eine Beschleunigung.

Das hatten wir doch schon alles!?

Sorry, wenn ich hier widerspreche

Die Erde befindet sich in permanenter Beschleunigung

Auf die Erde wirkt eine Anziehungskraft, von ca 3,572*1022 N, die von der Sonne ausgeht.

Hallo Hans-m,

aus meiner Sicht habt ihr beide recht. Ihr argumentiert lediglich in unterschiedlichen Bezugssystemen:

- Deine Argumentation ist richtig, wenn als Bezugssystem ein 3-dimensionales kartesisches Koordinatensystem zugrundegelegt wird (der Raum also keinerlei Krümmung hat).

- Okotombrok aber argumentiert im gekrümmten Raum der ART. Zu dem ist Einstein aber gerade dadurch gelangt, dass er Beschleunigung als Raumkrümmung interpretiert hat.

In Wikipedia liest man:

Zitat:

Die ART geht davon aus, dass ein Körper, auf den keine weiteren Kräfte wirken, sich in der gekrümmten Raumzeit auf einer Geodätischen Linie bewegt.

In einer nicht gekrümmten Raumzeit würde dies der Trägheitsbewegung eines freien Körpers entsprechen, d. h. geradlinig und mit konstanter Geschwindigkeit.

Aufgrund der Krümmung der Raumzeit erscheint [uns� diese Bewegung aber räumlich gekrümmt und beschleunigt.

Mit anderen Worten: Beschleunigung ist eine Art Illusion, die uns in die Wirklichkeit zurückholt, wo wir nichts von Raumkrümmung wissen (bzw. wissen wollen).

Neutraler ausgedrückt: Beschleunigung und Raumkrümmung sind unterschiedliche gedankliche Präsentationen ein und desselben Konzepts der Natur.

Gruß, grtgrt

Beitrag 0-40

Korrektes Argumentieren mit Einsteins (starkem) Äquivalenzprinzip

Uhren, Maßstäbe und Bewegung im Gravitationsfeld

In der Allgemeinen Relativitätstheorie ist von besonderer Bedeutung Einsteins Äquivalenzprinzip, demzufolge eine Gravitationsfeld lokal einem geeignet gewählten beschleunigten Bezugssystem gleichwertig ist. Ein solches zu finden ist stets möglich. Mit anderen Worten: Wirkungen eines Gravitationsfeldes können durch Analyse des Sachverhalts im lokal äquivalenten beschleunigten Bezugssystem im feldfreien Raum ermittelt werden (nicht ganz genau, aber doch beliebig genau, wenn man nur die Situation entsprechend lokal betrachtet).

Zwei Beispiele verdeutlichen das:

Maßstabslänge im Gravitationsfeld

Beim Ausmessen der Länge zeitlicher und räumlicher Abstände kann nicht unberücksichtigt bleiben, in welchem Bezugssystem der Beobachter sitzt:

Einsteins Einschluss der Gravitation in die Struktur der Raumzeit zeigt, dass er ihren Einfluss nicht als korrekturbedürftig betrachten wollte.

Auf Seite 147-148 seine Buches Raum-Zeit erklärt Martin Carrier weiter:

In der Allgemeinen Relativitätstheorie ist von besonderer Bedeutung Einsteins Äquivalenzprinzip, demzufolge eine Gravitationsfeld lokal einem geeignet gewählten beschleunigten Bezugssystem gleichwertig ist. Ein solches zu finden ist stets möglich. Mit anderen Worten: Wirkungen eines Gravitationsfeldes können durch Analyse des Sachverhalts im lokal äquivalenten beschleunigten Bezugssystem im feldfreien Raum ermittelt werden (nicht ganz genau, aber doch beliebig genau, wenn man nur die Situation entsprechend lokal betrachtet).

Zwei Beispiele verdeutlichen das:

Martin Carrier (S. 144-145)

- Man betrachte etwa einen Lichtstrahl, der seitlich in einen beschleunigten Kasten einfällt und diesen durchquert. Im beschleunigten Bezugssystem des Kastens durchläuft der Lichtstrahl eine gekrümmte, gegen den Boden des Kastens gerichtete Bahn. Nach dem Äquivalenzprinzip ergibt sich die gleiche Bahn aber auch im Gravitationsfeld, so dass Licht im Gravitationsfeld in Richtung des Bereiches höherer Feldstärke abgelenkt wird.

- Eine ähnliche Überlegung zeigt, dass ein Gravitationsfeld den Gang von Uhren verlangsamt: Vom hinteren Ende eines beschleunigten Kastens werde Licht ausgesandt. Wenn es das vordere Ende des Kastens erreicht, bewegt sich dieser schon mit etwas größerer Geschwindigkeit. Bei deiner Relativbewegung zwischen Sender und Empfänger tritt aber stets eine Doppler-Verschiebung auf. Hier im Beispiel ist das eine Rot-Verschiebung, da der Empfänger sich vom der Lichtquelle entfernt.

Bei Rückübertragung auf das Gravitationsfeld bedeutet das, dass eine gegen die Richtung der Schwerebeschleunigung (also gleichsam aufwärts) bewegter Lichtstrahl ebenfalls eine Rotversschiebung erfährt.

Fasst man jeden Wellenberg der Lichtwelle als Zeitsignal auf, so werden — wegen dieser Dopplerabsenkung der Frequenz — bei einem Betrachter am vorderen Ende des Kastens die Wellenberge mit vergrößertem Zeitabstand ankommen. Wenn also eine Uhr am hinteren Ende des Kastens Zeitsignale aussendet, so haben diese beim Empfang am vorderen Ende einen größeren Zeitabstand als die einer am vorderen Ende montierten baugleichen Uhr. Aus Sicht eines am vorderen Ende platzierten Beobachters geht deswegen die Uhr am hinteren Ende langsamer als seine eigene.

In der Rückübertragung bedeutet dies, dass jede Uhr im stärkeren Gravitationsfeld gegenüber einer gleich gebauten im schwächeren Gravitationsfeld zurückbleibt.

Martin Carrier (S. 145-146)

Um das Verhalten von Maßstäben im Gravitationsfeld zu ermitteln geht man wieder in das lokal äquivalente beschleunigte Bezugssystem, etwa eine rotierende Scheibe: Vom Standpunkt eines nicht mitrotierenden Beobachters aus erfahren Maßstäbe entlang der Peripherie eine Lorentz-Kontraktion, während dies bei radial orientierten Maßstäben nicht der Fall ist.

Konsequenz daraus: Das von Umfang und Durchmesser eines Kreises auf der Scheibe gemessene Verhältnis wird nicht mehr π sein, was eine Abweichung von euklidischer Geometrie anzeigt.

Diesem Befund kann auf zweierlei Weise Rechnung getragen werden:

- Man kann die tangential ausgerichteten Maßstäbe als kontrahiert betrachten, ihre Länge durch die Lorentz-Transformation korrigiert und so dem Raum Euklidische Geometrie geben.

- Nimmt man aber an, dass alle Maßstäbe ihre Länge unabhängig von ihrer Orientierung beibehalten, so ist keine Korrektur erforderlich, aber das gemessene Verhältnis von Umfang und Durchmesser muss dann als Anzeichen für das Vorliegen einer nicht-Euklidischen Geometrie gedeutet werden.

Die Verallgemeinerung dieser Behandlung führt auf folgenden Schluss:

Wenn man die Invarianz von Maßstäben bei Transport voraussetzt,

ergibt sich in beschleunigten Bezugssystemen eine nicht-Euklidische Geometrie.

Voraussetzung aber ist, dass man auf die Korrektur der erhaltenen Längenverhältnisse verzichtet.

Dieser Verzicht macht Sinn, denn die Gravitation ist eine nicht vom Material der Maßstäbe abhängige universelle Kraft. Der Verzicht auf Korrektur läuft darauf hinaus, ihren Einfluss nicht als Störung (Verzerrung) der Maßstäbe zu betrachten.

Auf Seite 147-148 seine Buches Raum-Zeit erklärt Martin Carrier weiter:

- Sie beinhalten die lokale Energie- und Impulserhaltung sowie die Bewegungsgleichung (in Newtons Theorie müssen das Gravitationsgesetz

und die Gleichung zur Beschreibung von Bewegungen im Gravitationsfeld separat angegeben werden).

- Sie haben zur Folge, dass "Testteilchen" (hypothetische Masseteilchen, die weder rotieren noch Ausdehnung haben) im Gravitationsfeld zeitartigen Geodäten folgen.

- Ebenso ergeben sich aus den Feldgleichungen alle auf der Grundlage des Äquivalenzprinzips ableitbaren Effekte wie Ablenkung von Lichtstrahlen oder die Verlangsamung des Uhrengangs im Gravitationsfeld.

Einsteins Geometrisierung der Gravitation hat auch zur Folge, dass weder Raum noch Zeit ein festgefügtes Behältnis für die wechselnden Ereignisse unserer Erscheinungs- welt bilden, sondern — wie die Gravitation — dem Einfluß von Energie, speziell Materie, unterworfen sind:

In Abhängigkeit von der Verteilung von Massen und Feldern ändert sich die Raumzeitmetrik und die Geodätenstruktur (als Geodäte bezeichnet man jeden Weg durch die Raumzeit, der zwischen je zwei auf ihm liegenden Ereignissen den kürzesten Weg darstellt).

Dieser Einfluss von Energieverteilung auf die Struktur der Raumzeit wird durch Einsteins Feldgleichungen der Gravitation beschrieben. Sie machen die Verteilung von Materie und Energie zudem noch zur Q u e l l e des Gravitationsfeldes: Sie verknüpfen den sog. Energie-Impuls-Tensor, der alle Quellen des Gravitationsfeldes mit Ausnahme des Gravitationsfeldes selbst enthält, mit Metrik und Krümmung der Raumzeit.

Die Feldgleichungen sind Einsteins Gegenstück zu Newtons Gravitationsgesetz. Physikalisch neu ist, dass das Gravitationsfeld so zu seiner eigenen Quelle wird.

Im Gegensatz zur Newtonschen Gravitationskraft ist Einsteins geometrisierte Gravitationskraft selbst schwer. Diese Eigentümlichkeit führt zur Nicht-Linearität der Feldgleichungen und findet ihren empirischen Ausdruck u.A. in sog. Gravitationswellen und dem im Vergleich zur Newtonschen Theorie schnelleren Voranschreitens des Merkurperihels.

Durch die Gravitation entsteht in der ART eine Abweichung von der sog. Minkowski-Raumzeit der SRT: In jener werden — da der Minkowski-Raum flach ist — Abstände über die Minkowski-Metrik quantifiziert, wohingegen in der Raumzeit der ART örtlich und zeitlich variable, kompliziertere Metriken anzwenden sind.

Einsteins Feldgleichungen übertreffen ihr Newtonsches Gegenstück beträchtlich an logischer Kraft.

Beitrag 0-41

Die durch Thirring und Deser vorgeschlagene Normierung unserer Raumzeit-Realität

Die Thirring-Deser-Normierung der ART

Wie in Beitrag 0-40 erklärt, hat Einstein seine Formulierung der ART so gewählt, dass Längeneinheiten für alle Beobachter gleich definiert sind (was dann zu nicht-Euklidischer Geometrie des Raumes führt). Diese Konvention aber ist keineswegs zwingend.

Und tatsächlich: Es gibt eine von Walter Thirring in den 1950er Jahren erarbeitete und etwa 20 Jahre später von Stanley Deser wesentlich verbesserte Fassung der Einsteinschen Feldgleichungen,

die mit dem Anspruch verbunden ist, dass die Raumzeit Euklidische Geometrie habe (mit überall gleicher Metrik).

Man sieht sich hier einmal mehr an Niels Bohr erinnert, der betont hat:

Die Physik kann nicht ergründen, wie die Natur funktioniert [ Wirklichkeit ].

Sie kann nur darüber sprechen, wie sie sich dem Beobachter darstellt [ Realität ].

Die unterschiedliche Formalisierung der ART durch Einstein einerseits und Thirring/Deser andererseits zeigt zudem, dass, was wir als Realität betrachten, zudem noch von durch uns selbst gewählten K o n v e n t i o n e n abhängig sein kann.

Bemerkenswert an der durch Thirring/Deser gefundene Normierung der Raumzeit ist vor allem, dass sie die Sonderstellung der Gravitation — die ihr durch Einsteins Geometrisierung zuwuchs — aufhebt.

Sie aufzuheben könnte notwendig sein, um zu einer Theorie zu kommen, die ART und Quantenmechanik zusammenführt: Diese künftige Theorie (Quantengravitation), die zu entwickeln nun schon ein halbes Jahrhundert auf der wissenschaftlichen Tagesordnung steht, wird ja aller Erwartung nach die Gravitation nach dem Muster der übrigen physikalischen Wechselwirkungen behandeln müssen: als eine Kraft, die q u a n t i s i e r t ist.

Wie in Beitrag 0-40 erklärt, hat Einstein seine Formulierung der ART so gewählt, dass Längeneinheiten für alle Beobachter gleich definiert sind (was dann zu nicht-Euklidischer Geometrie des Raumes führt). Diese Konvention aber ist keineswegs zwingend.

Und tatsächlich: Es gibt eine von Walter Thirring in den 1950er Jahren erarbeitete und etwa 20 Jahre später von Stanley Deser wesentlich verbesserte Fassung der Einsteinschen Feldgleichungen,

Martin Carrier (S. 166-167 seines Buches Raumzeit, de Gruyter, 2009)

Die Thirring-Deser-Fassung der Einsteinschen Feldgleichungen stellt die Gravitation als universelles Kraftfeld in einem f l a c h e n Raum dar, der mit einer überall gleichen Minkowski-Metrik ausgestattet ist.

In Umkehrung der Einsteinschen Vorgehensweise gibt man die Raumzeit-Struktur vor und passt das Verhalten von Maßstäben und Uhren sowie die Bewegung freier [hypothetisch ausdehnungsloser Test-] Teilchen an sie an durch die Einführung universeller Kräfte.

Die Gravitation verzerrt dann die M a ß s t ä b e , beinflusst aber n i c h t die Geometrie.

Die Thirring-Deser-Fassung enthält entsprechend eine de-geometrisierte Version der Einsteinschen Feldgleichungen unter Bewahrung der Kausalität.

Beide Ansätze sind empirisch äquivalent, wenn auch nicht in jeder Hinsicht gleichwertig: In empirischer Hinsicht ergeben sich Abweichungen die Topologie des Raumes betreffend, da man mit einer flachen Hintergrundgeometrie kein geschlossenes Universum wiedergeben kann.

Damit ist die These von der Konventionalität der physikalischen Geometrie der Raumzeit — auch unter Bewahrung der kausalen Erklärbarkeit — nicht ohne Stütze. ...

Die adaptierte These belegt die generelle Ansicht von der Unterbestimmtheit von Theorien durch die Erfahrung, mit der Folge, dass Raum-Zeit-Theorien keine spezifische Form von Konventionalität enthalten.

Man sieht sich hier einmal mehr an Niels Bohr erinnert, der betont hat:

Sie kann nur darüber sprechen, wie sie sich dem Beobachter darstellt [ Realität ].

Die unterschiedliche Formalisierung der ART durch Einstein einerseits und Thirring/Deser andererseits zeigt zudem, dass, was wir als Realität betrachten, zudem noch von durch uns selbst gewählten K o n v e n t i o n e n abhängig sein kann.

Bemerkenswert an der durch Thirring/Deser gefundene Normierung der Raumzeit ist vor allem, dass sie die Sonderstellung der Gravitation — die ihr durch Einsteins Geometrisierung zuwuchs — aufhebt.

Sie aufzuheben könnte notwendig sein, um zu einer Theorie zu kommen, die ART und Quantenmechanik zusammenführt: Diese künftige Theorie (Quantengravitation), die zu entwickeln nun schon ein halbes Jahrhundert auf der wissenschaftlichen Tagesordnung steht, wird ja aller Erwartung nach die Gravitation nach dem Muster der übrigen physikalischen Wechselwirkungen behandeln müssen: als eine Kraft, die q u a n t i s i e r t ist.

Beitrag 0-43

Was Einstein zu seiner Gravitationstheorie führte (1): Das Machsche Prinzip

Ausgangspunkt von Einsteins Entwicklung der Allgemeinen Relativitätstheorie waren 3 Prinzipien. Hier als erstes

Das Machsche Prinzip

Was Einstein das Machsche Prinzip nannte, bringt zum Ausdruck, dass Einstein — wie vor ihm schon Leibniz und Mach — nicht an die Existenz eines "absoluten" Raumes glaubte, der auch als leerer Raum noch existieren würde, als Behälter also, der durch Objekte bewohnt oder auch nicht bewohnt sein könnte.

Newton — der in diesem Punkt ganz anderer Ansicht war als sein Zeitgenosse Leibniz — hatte argumentiert, dass das Auftreten von Trägheitskräften nichts mit Beziehungen zwischen den betroffenen Körpern und anderer Körper zu tun habe, sondern stattdessen die "wahre Bewegung" des Körpers, d.h seine Bewegung relativ zum absoluten Raum widerspiegle.

Obgleich das Machsche Prinzip Einsteins Weg zur ART bahnte, ist es in der voll entwickelten Theorie tatsächlich n i c h t erfüllt

( wie Carrier in den Abschnitten 4.1.4 und 4.2.2 seines Buches erklärt ):

Für jede Theorie muß grundsätzlich unterschieden werden

Es gibt demzufolge zwei unterschiedliche philosophische Haltungen:

Für eine umfassende Beschreibung kosmischer Strukturen aber reicht Friedmans Lösung n i c h t aus: Lokalen Abweichungen von der Homogenität — etwa bei Planetensystemen oder Schwarzen Löchern — muss durch Größen Rechnung getragen werden, die absolut sind, bei denen also nicht alle geometrischen Strukturen einfach nur auf die relative Lage der Körper zueinander zurückführbar sind.

Noch 1917 hat Willem de Sitter Einstein darauf aufmerksam gemacht, dass seine Feldgleichungen auch absolut leere, unendlich weite Raumzeiten zulassen (und die noch nicht mal statisch sein müssen). Wegen der hier angenommenen kosmologischen Konstanten zieht sich die Raumzeit zunächst zusammen, expandiert dann aber wieder (was aber beides erst später klar wurde). Diese Beispiele zeigen, dass die Metrik doch nicht — wie Einstein dachte — allein durch den Energie-Impuls-Tensor bestimmt ist.

Ausgehend hiervon sah Einstein schließlich auch ein, dass seine Theorie gar nicht auf der Relativität der trägen Masse aufbaut oder sie erfordert, sondern lediglich auf der Relativität der Bezugssysteme. In einem Brief aus 1954 schrieb er dann schließlich, dass man vom Mach'schen Prinzip überhaupt nicht mehr sprechen sollte.

Damit ist nun aber erneut die Frage berechtigt, ob die Natur nicht vielleicht doch auch absolut leere Raumzeit kennt.

Das Machsche Prinzip

Was Einstein das Machsche Prinzip nannte, bringt zum Ausdruck, dass Einstein — wie vor ihm schon Leibniz und Mach — nicht an die Existenz eines "absoluten" Raumes glaubte, der auch als leerer Raum noch existieren würde, als Behälter also, der durch Objekte bewohnt oder auch nicht bewohnt sein könnte.

Newton — der in diesem Punkt ganz anderer Ansicht war als sein Zeitgenosse Leibniz — hatte argumentiert, dass das Auftreten von Trägheitskräften nichts mit Beziehungen zwischen den betroffenen Körpern und anderer Körper zu tun habe, sondern stattdessen die "wahre Bewegung" des Körpers, d.h seine Bewegung relativ zum absoluten Raum widerspiegle.

Martin Carrier (in seinem Buch Raum-Zeit, de Gruyter 2009, S. 138-139)

Einstein hielt nichts von diesem Gedanken. Sein zentrales Motiv war die bei Newton angenommene Einseitigkeit der Kausalwirkung, nach der der absolute Raum Trägheitskräfte entstehen lässt ohne dass es Rückwirkung der Körper auf ihn gibt.

Einen solch einseitigen Kausaleinfluss hielt Einstein für widersinnig und wollte ihn durch die Vorstellung ersetzen, dass die Trägheitseigenschaften bewegter Körper generell durch ein physikalisches Feld bestimmt sind, ähnlich dem elektromagnetischen Feld.

In diesem Denkansatz kann der Raum zwar weiterhin physikalische Wirkung entfalten, jedoch müssen umgekehrt die Körper auch auf ihn Einfluss nehmen können. Für Einstein bedeutet das: Die metrischen und geodätischen Eigenschaften der Raumzeit sollten zur Gänze durch die relativen Lagen und Bewegungen von Körpern (oder anderen Energieformen) festgelegt sein.

Er nannte dieses Prinzip das Machsche Prinzip .

Es impliziert, dass das Auftreten von Trägheitskräften zur Gänze durch Relativbewegungen festgelegt ist, nicht aber durch Bewegungen der Körper gegen den Raum.

Obgleich das Machsche Prinzip Einsteins Weg zur ART bahnte, ist es in der voll entwickelten Theorie tatsächlich n i c h t erfüllt

( wie Carrier in den Abschnitten 4.1.4 und 4.2.2 seines Buches erklärt ):

Für jede Theorie muß grundsätzlich unterschieden werden

- zwischen der Theorie einerseits und

- den zu ihr konformen Modellen andererseits (die sich ja in durch die Theorie nicht voll bestimmten Eigenschaften durchaus unterscheiden können).

Es gibt demzufolge zwei unterschiedliche philosophische Haltungen:

- Als Relationalismus bezeichnet man einen Standpunkt, der zwar anerkennt, dass die ART Lösungen kennt, die das Machsche Prinzip nicht automatisch erfüllen, der diese Lösungen aber als

philosophisch belanglos einstuft, da sie nicht mit den Erfahrungsbedingungen unserer Welt übereinstimmen.

- Der absolute Ansatz dagegen kennt keine Konzentration auf die faktisch realisierten Lösungen. Seine Anhänger stehen auf dem Standpunkt, dass die ART keinen Rückgriff auf Bezugskörper verlange und keine Rückführung von Trägheitskräften auf Relativbewegungen erzwinge. Die nicht-Machschen Lösungen seien ebenfalls relevant, da sie zur Beschreibung kleinräumiger kosmischer Strukturen (mit ihren lokalen Abweichungen von Homogenität und Isotropie) gebraucht werden.

Für eine umfassende Beschreibung kosmischer Strukturen aber reicht Friedmans Lösung n i c h t aus: Lokalen Abweichungen von der Homogenität — etwa bei Planetensystemen oder Schwarzen Löchern — muss durch Größen Rechnung getragen werden, die absolut sind, bei denen also nicht alle geometrischen Strukturen einfach nur auf die relative Lage der Körper zueinander zurückführbar sind.

Rüdiger Vaas (in seinem Buch Jenseits von Einsteins Universum, 2016, S. 220-222):

Den Begriff das Mach'sche Prinzip hat Einstein 1918 zu Ehren des 1916 verstorbenen Ernst Mach eingeführt. Er steht für Machs Aussage, dass die Trägheit eines Körpers bestimmt sei durch den Einfluss, den alle sonst noch im All vorhandenen Körper auf ihn haben.

In Einsteins Theorie ausgedrückt:

Der durch den Metriktensor gμν beschriebene » Raumzustand «

— auch das Gravitationsfeld, welches durch den Energie-Impuls-Tensor Tμν bedingt wird —

sei r e s t l o s durch die Massen der Körper bestimmt.

Einstein bedauerte, dieses Prinzip zunächst nicht klar genug vom Relativitätsprinzip unterschieden zu haben, das er nun so definierte:

» Die Naturgesetze sind nur Aussagen über zeiträumliche Koinzidenzen.

Sie finden d e s h a l b ihren einzig natürlichen Ausdruck in allgemein kovarianten Gleichungen. «

Einstein räumte ein, das Mach'sche Prinzip würde » keineswegs von allen Fachgenossen geteilt «, er selbst aber empfinde » seine Erfüllung als unbedingt notwendig «.

Ob Einstein berechtigt war, sich auf Mach zu beziehen, erscheint fraglich (und wird von Wissenschaftsphilosophen wie etwa John Norton mit guten Gründen bezweifelt): Mach selbst hatte wohl keine klare Konzeption von dem, was Einstein nach seinem Tode das Mach'sche Prinzip nannte.

Mittlerweile gibt es mindestens 20 Formulierungen, keine deckungsgleich mit einer anderen, und manche sind ziemlich sicher falsch ...

Klaus Kiefer (auf S. 60 in Quantenkosmos):

Einstein verstand das Machsche Prinzip ursprünglich so, dass die Geometrie der Raumzeit — ihre Metrik — durch die Materieverteilung eindeutig bestimmt sein sollte. Wie Einstein selbst aber nachträglich feststellen musste, ist das in der ART nun aber doch nicht der Fall: Die Metrik geht in alle bekannten Materiegleichungen ein und kann daher nicht durch die Materie bestimmt sein.

Zudem sind es ja gerade die lokalen Gravitationsfelder, welche für das lokale Trägheitsverhalten am dominantesten bestimmen (und nicht — wie noch Mach meinte — die fernen Fixsterne bzw. alle Körper im Raum gleichermaßen).

Noch 1917 hat Willem de Sitter Einstein darauf aufmerksam gemacht, dass seine Feldgleichungen auch absolut leere, unendlich weite Raumzeiten zulassen (und die noch nicht mal statisch sein müssen). Wegen der hier angenommenen kosmologischen Konstanten zieht sich die Raumzeit zunächst zusammen, expandiert dann aber wieder (was aber beides erst später klar wurde). Diese Beispiele zeigen, dass die Metrik doch nicht — wie Einstein dachte — allein durch den Energie-Impuls-Tensor bestimmt ist.

Ausgehend hiervon sah Einstein schließlich auch ein, dass seine Theorie gar nicht auf der Relativität der trägen Masse aufbaut oder sie erfordert, sondern lediglich auf der Relativität der Bezugssysteme. In einem Brief aus 1954 schrieb er dann schließlich, dass man vom Mach'schen Prinzip überhaupt nicht mehr sprechen sollte.

Damit ist nun aber erneut die Frage berechtigt, ob die Natur nicht vielleicht doch auch absolut leere Raumzeit kennt.

Beitrag 0-44

Was Einstein zu seiner Gravitationstheorie führte (2): Das Äquivalenzprinzip

Ausgangspunkt von Einsteins Entwicklung der Allgemeinen Relativitätstheorie waren 3 Prinzipien. Hier als zweites

Das schwache und das starke Äquivalenzprinzip

Unter dem s c h w a c h e n Äquivalenprinzip versteht man die Gleichheit von schwerer und träger Masse:

Danach stellen schwere und träge Masse lediglich unterschiedliche Manifestationen einer einzigen Grundgröße dar.

Nach dem schwachen Äquivalenzprinzip lässt sich gleichförmige Beschleunigung im feldfreien Raum nicht von geradlinig-gleichförmiger Bewegung im einem gleichförmigen Gravitationsfeld unterscheiden.

Verknüpft mit Machschen Prinzip führt das starke Äquivalenzprinzip auf ein Charakteristikum der ART, welches darin besteht, den absoluten Raum zu vermeiden.

WICHTIG aber:

Bisher konnten Experimente das Äquivalenzprinzip bis zu einer Genauigkeit von 10-13 bestätigen. Dennoch ruht man nicht:

Folgen des Äquivalenzprinzips

Nach dem Äquivalenzprinzip ist es physikalisch nicht unterscheidbar, ob eine in einem System auftretende Kraft sich als Folge von Beschleunigung ergibt oder durch Gravitationsquellen hervorgerufen ist.

Mit anderen Worten: Schwerkraft und Trägheitskräfte (wie etwa die Fliehkraft) sind aufsummierbar und können sich daher — als gerichtete Kräfte — auch gegenseitig aufheben.

Die Erde umkreisende Raumfahrer etwa machen sich das zunutze: In der typischen Flughöhe von IIS und Mir ist die Schwerkraft nur etwa 15% geringer als auf der Erdoberfläche. Schwerelos sind die Raumfahrer darin nur deswegen, weil

Historische Notiz:

Für Newton war Trägheit durch den Raum hervorgerufen, Gravitation aber durch die sich anziehenden Objekte im Raum.

Erst Einstein sah beide als Erscheinungsformen ein und derselben Sache: der Geometrie der Raumzeit.

Daher ist selbst noch die Fliehkraft, der wir während einer Karusselfahrt ausgesetzt sind, ein Aspekt der Gravitation.

Das schwache und das starke Äquivalenzprinzip

Unter dem s c h w a c h e n Äquivalenprinzip versteht man die Gleichheit von schwerer und träger Masse:

Einstein (1922)

Die bisherige Mechanik hat diesen wichtigen Sachverhalt zwar registriert, aber nicht interpretiert.

Eine befriedigende Interpretation kann nur so zustandekommen, dass man einsieht: Dieselbe Qualität des Körpers äußerst sich je nach Umständen als Trägheit oder als Schwere.

Nach dem schwachen Äquivalenzprinzip lässt sich gleichförmige Beschleunigung im feldfreien Raum nicht von geradlinig-gleichförmiger Bewegung im einem gleichförmigen Gravitationsfeld unterscheiden.

Der Schluss ist, dass gleichförmige Beschleunigungen und homogene Gravitationsfelder für alle mechanischen Prozesse empirisch äquivalent sind.

Die Annahme, dass dies nicht allein für mechanische Prozesse, sondern sogar für s ä m t l i c h e physikalischen Vorgänge gelte, wird als s t a r k e s Äquivalenzprinzip bezeichnet. Erst Einstein sprach davon.

Verknüpft mit Machschen Prinzip führt das starke Äquivalenzprinzip auf ein Charakteristikum der ART, welches darin besteht, den absoluten Raum zu vermeiden.

WICHTIG aber:

-

Das Äquivalenzprinzip lässt sich nur auf h o m o g e n e Gravitationsfelder anwenden. Seine Erweiterung auf inhomogene Felder — solche mit räumlich

oder zeitlich wechselnder Feldintensität — verlangt eine bloß lokale Anwendung

auf räumlich und zeitlich benachbarte Ereignisse.

-

Gutes Beispiel eines inhomogenen Gravitationsfeldes ist das kugelsymmetrische Feld der Erde.

In ihm ist die Schwerebeschleunigung auf den Erdmittelpunkt gerichtet und weist daher an unterschiedlichen Orten in meist unterschiedliche Richtung.

Folglich ist das Schwerefeld der Erde n i c h t durch Übergang in ein einziges beschleunigtes Bezugssystem im feldfreien Raum nachzubilden.

Nur wer sich auf einen hinreichend kleinen Bereich des irdischen Schwerefeldes beschränkt, kann für ihn ein Bezugssystem derart wählen, dass

das Schwerefeld verschwindet (niemals ganz genau, wohl aber ausreichend genau unter praktischen Gesichtspunkten).

Auch die Tatsache, dass ein in einem beliebigen Gravitationsfeld frei fallender Beobachter die Existenz des Feldes grundsätzlich überhaupt nicht nachweisen könne, gilt nur in sehr kleinen Bereichen: Darüber hinaus nämlich wäre — genügend genaues Messgerät vorausgesetzt — die Auswirkungen der Raum-Zeit-Krümmung anhand sog. Gezeitenkräfte erkennbar, d.h. anhand der Deformationen, die sämtliche Körper im inhomogenen Gravitationsfeld erfahren. Wenn z.B. eine verformbare Kugel der Erde entgegen fällt, wirkt die Gravitationskraft am unteren Ende der Kugel stärker als am oberen (da sie ja der Erde schon näher ist), so dass die Kugel sich in Fallrichtung verlängert ind insgesamt elliptische Form annimmt.

Dass man diese Kraftdifferenz als Gezeitenkraft bezeichnet, liegt daran, dass die irdischen Wassermassen auf der dem Mond zugewandten Seite von ihm stärker angezogen werden als auf der ihm abgewandten Seite. Deshalb ist das Wasser an beiden Seiten relativ zum Erdzentrum in Richtung des Mondes beschleunigt, was — da der Mond die Erde umkreist — ständigen Wechsel zwischen Ebbe und Flut zur Folge hat.

Wirklich exakt also gilt das Äquivalenzprinzip nur in einer ausdehnungslosen Umgebung des Beobachters, die — da ausdehnungslos — nur den Punkt enthält, in dem der Beobachter ruht. Mit zunehmendem Abstand von ihm werden z.B. Gezeitenkräfte immer deutlicher hervortreten. Wirklich zu Null wird das Gravitationsfeld nur im Beobachter selbst: Das s t a r k e Äquivalenzprinzip hat nur l o k a l e Gültigkeit.

Bisher konnten Experimente das Äquivalenzprinzip bis zu einer Genauigkeit von 10-13 bestätigen. Dennoch ruht man nicht:

- Das Äquivalenzprinzip mit noch höherer Genauigkeit nachzuprüfen ist Aufgabe des von der ESA verantworteten Projekts

Weltraummission MICROSCOPE.

- Um die Jahreswende 2013/2014 wurde ein exotisches 3-Sterne-System entdeckt, mit dessen Hilfe sich die uneingeschränkte Gültigkeit des starken Äquivalenzprinzips mit um einige Größenordnungen höherer Genauigkeit als bisher wird nachprüfen lassen. Siehe Relativitätstheorie im Präzisionstest (Jan 2014).

Nach dem Äquivalenzprinzip ist es physikalisch nicht unterscheidbar, ob eine in einem System auftretende Kraft sich als Folge von Beschleunigung ergibt oder durch Gravitationsquellen hervorgerufen ist.

Mit anderen Worten: Schwerkraft und Trägheitskräfte (wie etwa die Fliehkraft) sind aufsummierbar und können sich daher — als gerichtete Kräfte — auch gegenseitig aufheben.

Die Erde umkreisende Raumfahrer etwa machen sich das zunutze: In der typischen Flughöhe von IIS und Mir ist die Schwerkraft nur etwa 15% geringer als auf der Erdoberfläche. Schwerelos sind die Raumfahrer darin nur deswegen, weil

- auf sie — da sie sich ja kreisförmig um die Erde bewegen — auch Fliehkraft wirkt

- und die Flughöhe ihrer Umlaufbahn so gewählt wurde, dass Fliehkraft und Schwerkraft sich zu Null aufaddieren.

- Möglich ist das nur, weil nach dem Äquivalenzprinzip beide Kräfte gleicher Natur sind.

Für Newton war Trägheit durch den Raum hervorgerufen, Gravitation aber durch die sich anziehenden Objekte im Raum.

Erst Einstein sah beide als Erscheinungsformen ein und derselben Sache: der Geometrie der Raumzeit.

Daher ist selbst noch die Fliehkraft, der wir während einer Karusselfahrt ausgesetzt sind, ein Aspekt der Gravitation.

Beitrag 0-45

Was Einstein zu seiner Gravitationstheorie führte (3): Das Prinzip allgemeiner Kovarianz

Ausgangspunkt von Einsteins Entwicklung der Allgemeinen Relativitätstheorie waren 3 Prinzipien. Hier als drittes

Das Prinzip allgemeiner Kovarianz

Einsteins Ziel war, seine Theorie so zu formulieren, dass ihre Ausdrücke in allen Bezugssystemen anwendbar sind — nicht allein in Inertialsystemen.

Zulässige Transformationen zwischen Bezugssystemen sollten nur eingeschränkt sein durch die Bedingungen

Wie bedeutsam das ist, wird klar, wenn man sich vor Augen führt, dass die Gesetze der Newtonschen Mechanik (wie auch der SRT) zunächst nur in Inertialsystemen gültig sind und an nicht-inertiale Bezugssysteme nur durch Einführung zusätzlicher Größen — Zentrifugalkräfte oder Crioliskräfte — anpassbar sind.

Solche Sonderstellung einer besonderen Klasse von Bezugssystemen wollte Einstein in der ART vermeiden:

Sein Ziel war, die Theorie so zu formulieren, dass ihre Gesetze in unveränderter Form in allen denkbaren Bezugssystemen gültig bleiben.

Allgemeine Kovarianz erreicht genau das. Zulässig sind danach nur Größen, die ein ganz bestimmtes Transformationsverhalten aufweisen.Man nennt sie kovariante Größen. Kovarianz ist ein der Differentialgeometrie entstammender, rein mathematischer Begriff. Einstein gelang es, ihm mit physikalischer Relevanz zu versehen. Einstein glaubte 1916, dass das Prinzip allgemeiner Kovarianz als Ausdruck und Konkretisierung eines "allgemeinen Relativitätsgesetzes" gelten könne, demzufolge sämtliche Bewegungsformen physikalisch gleichwertig sind:

Die Formulierung eines physikalischen Gesetzes heißt k o v a r i a n t , wenn sie koordinatensystem-unabhängig ist.

Das Prinzip allgemeiner Kovarianz

Einsteins Ziel war, seine Theorie so zu formulieren, dass ihre Ausdrücke in allen Bezugssystemen anwendbar sind — nicht allein in Inertialsystemen.

Zulässige Transformationen zwischen Bezugssystemen sollten nur eingeschränkt sein durch die Bedingungen

- umkehrbar eindeutig,

- stetig,

- und auch differenzierbar.

Wie bedeutsam das ist, wird klar, wenn man sich vor Augen führt, dass die Gesetze der Newtonschen Mechanik (wie auch der SRT) zunächst nur in Inertialsystemen gültig sind und an nicht-inertiale Bezugssysteme nur durch Einführung zusätzlicher Größen — Zentrifugalkräfte oder Crioliskräfte — anpassbar sind.

Solche Sonderstellung einer besonderen Klasse von Bezugssystemen wollte Einstein in der ART vermeiden:

Sein Ziel war, die Theorie so zu formulieren, dass ihre Gesetze in unveränderter Form in allen denkbaren Bezugssystemen gültig bleiben.

Allgemeine Kovarianz erreicht genau das. Zulässig sind danach nur Größen, die ein ganz bestimmtes Transformationsverhalten aufweisen.Man nennt sie kovariante Größen. Kovarianz ist ein der Differentialgeometrie entstammender, rein mathematischer Begriff. Einstein gelang es, ihm mit physikalischer Relevanz zu versehen. Einstein glaubte 1916, dass das Prinzip allgemeiner Kovarianz als Ausdruck und Konkretisierung eines "allgemeinen Relativitätsgesetzes" gelten könne, demzufolge sämtliche Bewegungsformen physikalisch gleichwertig sind:

Einstein (1922)

Wir werden dem Relativitätsprinzip im weitesten Sinne dadurch gerecht, dass wir den Gesetzen eine solche Form geben, daß sie bezüglich jedes derartigen (4-dimensionalen) Koordinatensystems gelten, d.h. daß die sie ausdrückenden Gleichungen bezüglich beliebiger Transformation kovariant sind.

Martin Carrier (in seinem Buch Raum-Zeit, de Gruyter 2009, S. 143-144)

Allerdings hat das Prinzip allgemeiner Kovarianz nichts mit der Relativität der Bewegung zu tun. Wie Erich Kretschmann 1917 zeigen konnte, beinhaltet die mathematische Tatsache der unveränderten Form der Gleichungen in beliebigen Koordinatensystemen keineswegs auch die physikalische Äquivalenz aller Bezugssysteme.Allgemeine Kovarianz bingt zum Ausdruck, dass sich die Größen der Theorie und ihre Beziehungen untereinander in koordinaten-unabhängiger Form darstellen lassen, schließt aber n i c h t aus, dass bei der Umsetzung der übergreifenden Darstellung in konkrete Bezugssysteme doch wieder spezifische Merkmale besonderer Bewegungsformen in Erscheinung treten.

Um es nochmals zu sagen:

Tatsächlich lässt sich beinahe jede Bewegungstheorie allgemein kovariant formulieren (SRT und Newtonsche Mechanik auf jeden Fall).

Dabei konkretisiert sich dann die die einheitliche Formulierung in verschiedenen Bezugssystemen auf unterschiedliche Weise.

Insbesondere treten in Nicht-Inertialsystemen unverändert Trägheitskräfte in Erscheinung, so dass sich an der Sonderstellung der Initialsysteme nichts geändert hat.Allgemeine Kovarianz ist eine mathematische Eigenschaft der F o r m u l i e r u n g einer Theorie.

Physikalische Äquivalenz von Bezugssystemen aber garantiert sie keineswegs.Neu in der ART ist allein, dass ein allgemein kovariante Formulierung dort unvermeidlich ist, da die von Punkt zu Punkt unterschiedliche Krümmung der Raumzeit keine globalen Inertialsysteme mehr zulässt (Friedmann 1983, 54-56, 207-209, 212-213).

Quelle:

- Friedmann, Michael (1983): Foundations of Space-Time Theories, Relativistic Physics and Philosphy of Science, Princeton University Press

Beitrag 0-48

Warum das Standardmodell der Elementarteilchen und Einsteins Gravitationstheorie einander widersprechen

Zum Konflikt zwischen ART und Quantentheorie

Beide Theorien unterscheiden sich grundlegend schon von ihrem begrifflichen Ansatz her:

Quellen:

Beide Theorien unterscheiden sich grundlegend schon von ihrem begrifflichen Ansatz her:

- In der Quantentheorie — und dem Standardmodell der Elementarteilchenphysik — werden physikalische Wechselwirkungen durch quantisierte Felder beschrieben,

so dass sich dort jede Wirkung von Kraft darstellt als Austausch von Überträgerteilchen (Bosonen):

- Photonen vermitteln die elektromagnetische Kraft,

- Eichbosonen die schwache Wechselwirkung

- und insgesamt 8 Gluonen die starke Kernkraft (die vor allem zwischen Quarks wirkt).

- Dass auch gravitative Wechselwirkung quantisiert sei — hypothetisch durch sog. Gravitonen (Gravitationswellen) — ist bislang nur Vermutung.

- Ganz anders Einsteins Gravitationstheorie:

Sie geht davon aus, dass Gravitationskräfte Ausdruck der Krümmung des Raumes (d.h. der Raumzeit) sind. Da die sich stetig ändert, kann Gravitation — der ART entsprechend — nicht quantisiert sein.

Martin Carrier (S. 224 in seinem Buch Raum-Zeit, de Gruyter 2009) kommt zum Schluss:

Eine der beiden Denkschulen wird weichen müssen. Vieles spricht dafür, dass es die Geometrisierung der Gravitation ist, die aufzugeben sein wird.

Nach früh gescheiterten Versuchen, auch Materie und (Energie-) Felder als besondere Raum-Zeit-Strukturen zu verstehen (Esfeld 2002, 42-43), zielen heute sämtliche Ansätze einer einheitlichen Theorie aller physikalischen Wechselwirkungen auf eine Quantentheorie der Gravitation. Bislang ist unklar, wie eine solche Theorie aussehen könnte. Dennoch ist damit zu rechnen, dass die Frage nach der Natur von Raum und Zeit vor dem Hintergrund einer künftigen Quantentheorie der Gravitation anders zu beantworten sein wird als heute.

Quellen:

- Esfeld, Michael (2002): Einführung in die Naturphilosophie, Darmstadt, Wissenschaftliche Buchgesellschaft (erschien 2011 in gründlicher Neubearbeitung)

Beitrag 0-46

Wie sich Newton einerseits und Leibniz andererseits Raum und Zeit vorgestellt hatten

Wie Newton und sein Widerpart Leibniz Raum und Zeit sahen

Newton sah den Raum als einen Behälter, in dem Objekte wohnen, die sich zeitabhängig verschieden schnell durch ihn bewegen.

Völlig anders Leibniz: Für ihn gab es diesen Behälter nicht. Er hielt den Raum ebenso wie die Zeit für etwas rein Relationales:

Die Ursprünge solch einer relationalen Theorie von Raum und Zeit gehen auf Decartes (1596-1650) zurück. In seinen Prinzipien der Philosophie vertrat er die Ansicht, dass Ausdehnung das kennzeichnende Merkmal von Materie und Raum gleichermaßen bilde und sich die beiden daher nicht wesentlich unterscheiden. Der Raum, so Descartes, sei die Gesamtheit der Erstreckungen und Positionen der Körper relativ zueinander dar, und Bewegung gebe es nur als Veränderung der Abstände und Anordnung der Körper untereinander. Einen wahrhaft unbewegten Ort dagegen gebe es nicht.

Leibniz hat diesen Gedanken aufgenommen und zu einer systematischen Theorie des Raumes ausgebaut. Auch seine kausale Theorie der Zeitfolge ist tatsächlich Teil dieses umfassenden relationalen Ansatzes.

Für Descartes und Leibniz war der Raum die Gesamtheit aller möglichen Anordnungen von Dingen, die gleichzeitig existieren.

Völlig anders Leibniz: Für ihn gab es diesen Behälter nicht. Er hielt den Raum ebenso wie die Zeit für etwas rein Relationales:

- Raum sei einfach nur eine Ordnung des Neben-einander-Bestehens von Objekten: die Gesamtheit der relativen Anordnungen der Körper,

- wohingegen Zeit nur als ein Auf-einander-Folgen von Ereignissen existiere.

Die Ursprünge solch einer relationalen Theorie von Raum und Zeit gehen auf Decartes (1596-1650) zurück. In seinen Prinzipien der Philosophie vertrat er die Ansicht, dass Ausdehnung das kennzeichnende Merkmal von Materie und Raum gleichermaßen bilde und sich die beiden daher nicht wesentlich unterscheiden. Der Raum, so Descartes, sei die Gesamtheit der Erstreckungen und Positionen der Körper relativ zueinander dar, und Bewegung gebe es nur als Veränderung der Abstände und Anordnung der Körper untereinander. Einen wahrhaft unbewegten Ort dagegen gebe es nicht.

Leibniz hat diesen Gedanken aufgenommen und zu einer systematischen Theorie des Raumes ausgebaut. Auch seine kausale Theorie der Zeitfolge ist tatsächlich Teil dieses umfassenden relationalen Ansatzes.

Beitrag 0-440

ART und Quantenphysik sind hintergrundunabhäbgige Weltmodelle

Zur Hintergrundunabhängigkeit von ART und Quantenphysik

Die wichtigste begriffliche Eigenschaft der allgemeinen Relativitätstheorie (ART) besteht in der sogenannten Hintergrundunabhängigkeit.

Man versteht darunter die Tatsache, dass in der ART den Raum-Zeit-Koordinaten überhaupt keine physikalische Bedeutung mehr zukommt, sondern nur noch den Beziehungen zwischen den Feldern auf der Raum-Zeit, zu denen auch das metrische Feld gehört, welches das Gravitationsfeld darstellt.

Dies hat damit zu tun, dass es in der allgemeinen Relativitätstheorie überhaupt keine absoluten Größen mehr gibt, da auch die Metrik — im Gegensatz zur speziellen Relativitätstheorie (SRT) — in der ART zu einer dymamischen Größe wird.

Das aber bedeutet, dass die Raumzeit ohne die in ihr enthaltenen dynamischen Objekte gar nicht existiert.

Dennoch kennt die ART — in einem relationalen Sinne — räumlich-kausale Strukturen, da in ihr ja — als zentrale, dynamische Größen — Felder auf der Raum-Zeit beschrieben werden.

Die Quantentheorie — in ihrer der abstrakten Hilbertraum-Formulierung — geht noch weiter: Sie verzichtet auf Begriffe wie Raum, Körper, Feld, Teilchen, Bewegung, Wechselwirkung, Masse oder Ladung. Nur die Zeit muss beibehalten werden.

Und so kommt dem Raum in der Quantentheorie noch weniger Bedeutung zu als in der ART.

Quelle: Martin Immanuel Kober (2018) in Fortführung des Ansatzes der Ur-Alternativen von Carl Friedrich v. Weizsäcker

Die wichtigste begriffliche Eigenschaft der allgemeinen Relativitätstheorie (ART) besteht in der sogenannten Hintergrundunabhängigkeit.

Man versteht darunter die Tatsache, dass in der ART den Raum-Zeit-Koordinaten überhaupt keine physikalische Bedeutung mehr zukommt, sondern nur noch den Beziehungen zwischen den Feldern auf der Raum-Zeit, zu denen auch das metrische Feld gehört, welches das Gravitationsfeld darstellt.

Dies hat damit zu tun, dass es in der allgemeinen Relativitätstheorie überhaupt keine absoluten Größen mehr gibt, da auch die Metrik — im Gegensatz zur speziellen Relativitätstheorie (SRT) — in der ART zu einer dymamischen Größe wird.

Dennoch kennt die ART — in einem relationalen Sinne — räumlich-kausale Strukturen, da in ihr ja — als zentrale, dynamische Größen — Felder auf der Raum-Zeit beschrieben werden.

Die Quantentheorie — in ihrer der abstrakten Hilbertraum-Formulierung — geht noch weiter: Sie verzichtet auf Begriffe wie Raum, Körper, Feld, Teilchen, Bewegung, Wechselwirkung, Masse oder Ladung. Nur die Zeit muss beibehalten werden.

Und so kommt dem Raum in der Quantentheorie noch weniger Bedeutung zu als in der ART.

Quelle: Martin Immanuel Kober (2018) in Fortführung des Ansatzes der Ur-Alternativen von Carl Friedrich v. Weizsäcker

Beitrag 0-49

Was sich heute zur Natur der Raumzeit sagen — aber auch f r a g e n — lässt

Warum man die Natur der Raumzeit heute noch als unentschieden sehen muss

Die relationale — der Ansicht von Decartes, Leibniz, Mach und Einstein entsprechenden — Rückführung der Raumzeitpunkte auf die Anordnung materieller Objekte untereinander hat zur Folge, dass es unbesetzte Raumzeitpunkte, leeren Raum also, nicht geben kann.

Die substanzialistische Ansicht aber, dass der Raum eigenständig existiere, setzt die Annahme der Existenz solche unbesetzter Raumzeitpunkte geradezu voraus.

Aus meiner [ Gebhard Greiters ] Sicht heraus, scheint mir diese Argumentation nicht so ganz überzeugend, denn wo es wellenartig sich auf- und abbauendes Kraftpotential gibt, muss es doch eigentlich auch als Anwesenheit von Energie gedeutet werden. Wie also unterscheidet die sich von der durch den Energie-Impuls-Tensor beschriebenen?

Die relationale — der Ansicht von Decartes, Leibniz, Mach und Einstein entsprechenden — Rückführung der Raumzeitpunkte auf die Anordnung materieller Objekte untereinander hat zur Folge, dass es unbesetzte Raumzeitpunkte, leeren Raum also, nicht geben kann.

Die substanzialistische Ansicht aber, dass der Raum eigenständig existiere, setzt die Annahme der Existenz solche unbesetzter Raumzeitpunkte geradezu voraus.

Martin Carrier (S. 205-206 seines Buches Raum-Zeit, de Gruyter 2009) schreibt:

Vor dem Hintergrund der ART lautet die wesentliche Frage, ob Raumzeitmetrik gik und Geodätenstruktur zur Raumzeit oder zur Materie zu zählen sind.

Die Feldgleichungen verknüpfen den Energie-Impuls-Tensor Tik mit einem Ausdruck, der die über Metrik und Geodäten gegebene physikalische Geometrie repräsentiert. So gesehen ist die Metrik Teil der Raumzeit, nicht aber der Materie.

Gegen den Relationalismus aber spricht, dass die Feldgleichungen physikalisch signifikante Vakuumlösungen enthalten (denn auch bei verschwindender Materie und Energie ergeben sich definitive metrische Felder und Geodätenstrukturen als Lösungen). Es handelt sich dabei insbesondere um Gravitationswellen, also um sich fortplanzende Schwingungen des metrischen Feldes.

Danach kann auch dort Raumzeit, nämlich ein nicht verschwindendes metrisches Feld gik vorliegen, wo keine Materie ist, genauer: wo der Energie-Impuls-Tensor verschwindet.

So führt z.B. der Kollaps eines Sternes zur Emission von Gravitationswellen, Sie entfernen sich vom Ort des Geschehens wie Wasserwellen von einem ins Wasser geworfenen Stein. Weit ab vom Ereignis mag keinerlei materieller Rest des Zusammenbruchs mehr vorhanden sein; in den Gravitationswellen aber manifestiert sich gleichwohl eine definitive Metrik.

Somit realisieren Gravitationswellen leere Raumzeit-Punkte, und d i e s e r Befund stützt die Vorstellung einer substanzialstischen Raumzeit.

Aus meiner [ Gebhard Greiters ] Sicht heraus, scheint mir diese Argumentation nicht so ganz überzeugend, denn wo es wellenartig sich auf- und abbauendes Kraftpotential gibt, muss es doch eigentlich auch als Anwesenheit von Energie gedeutet werden. Wie also unterscheidet die sich von der durch den Energie-Impuls-Tensor beschriebenen?

Beitrag 0-47

Wie sich der Geometrie-Begriff entwickelt hat: Von Euklid bis hin zu Riemann und Einstein

Wie sich der Geometrie-Begriff entwickelt hat (bis hin zu dem der ART)

Über fast zwei Jahrtausende hinweg war die Euklidische Geometrie die einzig bekannte. Nach anderen Geometrien zu suchen kam lange Zeit niemand in den Sinn, denn einerseits entspricht sie gut unserer Erfahrungswelt und noch Euklid (ca. 365-300 v.Chr) hatte sie von Anfang an fest verankert in 5 Postulaten, auf die er all seine Lehrsätze stützte (und die suggerierten, dass Geometrie stets nur im Kontext einer flachen Ebene Sinn machen).

Hierzu zählten Forderungen so einfacher Art, dass zwischen je zwei Punkten eine Gerade gezogen werden kann und jede Strecke zu einer Geraden verlängert werden kann. Nur Euklids fünftes, letztes Postulat — in dem er verlangt, dass es durch einen Punkt P der nicht auf einer gegebenen Geraden G liegt stets eine andere Gerade gebe, die parallel zu G ist — hat den Mathematikern zunehmend Kopfzerbrechen bereitet: Sie vermuteten, dass dieses so vergleichsweise komplizierte Postulat schon Folge der anderen sein könnte.

Dies zu beweisen allerdings gelang niemand. Kein Wunder, denn Bolyai (1802-1860) und unabhängig von ihm auch Lobaschewski (1792-1856) und schließlich Gauss (1777-1855) fanden schließlich, dass auch andere Fassungen des Parallelenaxioms denkbar und ebenfalls mit den übrigen 4 Axiomen verträglich sind: Statt die Existenz genau einer Parallele zu G durch P kann man auch die Existenz gar keiner oder die Existenz von mindestens zwei fordern.

Diese Einsicht markierte die Entdeckung zweier Familien Nicht-Euklidischer Geometrie. Man nennt sie Geometrien elliptischer bzw. hyperbolischer Art je nachdem ob sie gar keine oder mehrere Parallen zu G durch P gestatten.

Bernhard Riemann — ein Schüler von Gauss — konnte schließlich beweisen, dass sie und auch die Geometrie Euklidischer Art sämtlich Spezialfälle einer noch allgemeineren geometrischen Theorie sind: einer, die man heute die Riemannsche Geometrie nennt (noch etwas allgemeinere entstanden ab 1920).