Zum Wesen physikalischer Modelle

Erst angedachte physikalische Modelle

Zum Standardmodell der Elementarteilchenphysik

|

Ein recht naheliegendes Weltmodell

Beitrag 0-531

Was die Physik unser Ich nennen könnte

Was die Physik unser Ich nennen könnte

Was man aus Sicht der Naturwissenschaft als unser Ich sehen könnte, ist der Teil unseres Bewusstsein, der vor allem nicht-algorithmisch denkt und insbesondere auch über sich selbst nachdenken kann.

Damit ist klar: Jeder geistig gesunde Mensch hat ein solches Ich.

Wer sich als Naturwissenschaftler solche (von der Quantenphysik ja durchaus nahegelegte) Gedanken macht, sollte aber nicht verschweigen, dass dieser Sachverhalt noch keineswegs klärt, ob es auch ein Ich im religiösen Sinne gibt: ein Ich, das nicht an physikalisch Existierendes gebunden ist und das Christen etwa als ihre Seele bezeichnen.

Es ist wichtig, sich den Unterschied zwischen den Begriffen Geist, Psyche und Seele (in diesem Sinne) klar zu machen:

Jeder Mensch besteht aus Körper und Geist. Letzterer gedeiht oder verkümmert in dem Teil des Menschen, den wir als seine Seele bzw. seine Psyche bezeichnen. Wie Körper und Psyche funktionieren und zusammenwirken, ist Gegenstand von Neurologie, Psychologie und Medizin, nur ansatzweise auch Biologie.

Religionen gehen davon aus, dass jeder Mensch über seine Psyche hinaus auch noch eine Seele (nun aber im religiösen Sinne) hat und die besonders wichtig sei, da sie sein eigentliches, über den Tod hinaus existierendes Ich darstellt.

Fazit also:

Was man aus Sicht der Naturwissenschaft als unser Ich sehen könnte, ist der Teil unseres Bewusstsein, der vor allem nicht-algorithmisch denkt und insbesondere auch über sich selbst nachdenken kann.

Damit ist klar: Jeder geistig gesunde Mensch hat ein solches Ich.

- Die interessante Frage, die sich stellt, ist nun aber die Frage, ob diese Art von Seele (unser Ich also) den Tod unseres Gehirn überlebt —

und wenn ja, für wie lange. Es gibt nur wenige Wissenschaftler, die sich ernsthaft auf die Suche nach einer Antwort gemacht haben.

Viele von ihnen kommen zur These: Ja, das könnte durchaus der Fall sein.

Die Beobachtungen allerdings, die ihnen diese Meinung nahelegen, deuten — soweit mir bekannt — alle darauf hin, dass unser Ich — wenn es denn wirklich den Tod unseres Körpers überleben kann – sich über die Zeit hinweg verflüchtigt wie Gasgeruch in ansonsten reiner Luft.

Aus physikalischer Sicht heraus könnte es sich dabei wohl am ehesten um in unserem Gehirn erzeugte, langwellige elektromagnetische Wellen handeln, deren jede sich über unsere Schädeldecke hinaus als Kugeloberfläche ins All hinaus ausbreitet, um sich dort dann einzeln und weitgehend unabhängig von einander irgendwann mit anderen Quanten zu vereinen — die eine oder andere davon vielleicht erst in Milliarden von Jahren.

Wer sich als Naturwissenschaftler solche (von der Quantenphysik ja durchaus nahegelegte) Gedanken macht, sollte aber nicht verschweigen, dass dieser Sachverhalt noch keineswegs klärt, ob es auch ein Ich im religiösen Sinne gibt: ein Ich, das nicht an physikalisch Existierendes gebunden ist und das Christen etwa als ihre Seele bezeichnen.

Es ist wichtig, sich den Unterschied zwischen den Begriffen Geist, Psyche und Seele (in diesem Sinne) klar zu machen:

Jeder Mensch besteht aus Körper und Geist. Letzterer gedeiht oder verkümmert in dem Teil des Menschen, den wir als seine Seele bzw. seine Psyche bezeichnen. Wie Körper und Psyche funktionieren und zusammenwirken, ist Gegenstand von Neurologie, Psychologie und Medizin, nur ansatzweise auch Biologie.

Religionen gehen davon aus, dass jeder Mensch über seine Psyche hinaus auch noch eine Seele (nun aber im religiösen Sinne) hat und die besonders wichtig sei, da sie sein eigentliches, über den Tod hinaus existierendes Ich darstellt.

Fazit also:

- Das Psychische ist sozusagen der Teil allen Seelischen, für dessen Existenz wir Beweise haben und der deswegen wissenschaftlicher Untersuchung gerade noch zugänglich ist.

Wie weit über ihn hinaus Seelisches auch als etwas sogar noch physikalisch Existentes über unseren körperlichen Tod hinaus existiert — bzw. existieren kann —, ist nicht erforschbar.

Das oben vorgebrachte physikalische Argument scheint Beweis dafür zu sein, dass der Tod unseres Gehirns Anfang unseres entgültigen Sterbens ist im selben Sinne, wie das Abschneiden einer Blume, um sie dann in eine Vase zu stellen, der Beginn ihres unwiderruflichen Absterbens ist.

Beitrag 0-337

Positivismus und Realismus — Wie sie sich unterscheiden

Positivisten und Realisten (in der Physik)

Wie Positivismus in der Physik zu verstehen sei, hat Max Planck 1930 einmal so zusammengefasst:

Für Positivisten » ist die Aufgabe der physikalischen Wissenschaft erschöpfend gekennzeichnet, wenn man sagt, dass sie darin bestünde, im die Summe vorliegender Naturbeobachtungen einen möglichst genauen und einfachen gesetzlichen Zusammenhang zu bringen «.

Jede Frage, so Planck, die der Positivist überhaupt als sinnvoll zulässt, muss durch Beobachtung beantwortbar sein.

Seinen deutlichsten Ausdruck hat der Positivismus in der Denkökonomie des Ernst Mach gefunden, in der es bei der Naturbeschreibung nur daraum geht, die Erscheinungen möglichst ökonomisch zu beschreiben: Positivisten sind keine Entdecker, sondern Erfinder ökonomischer Beschreibung.

Planck war sich mit Physikern wie Einstein, Schrödinger und Pauli darin einig, dass die große Gefahr des Positivismus seine Unfruchtbarkeit sei.

Einstein, der Mach verehrt hat, hat das sehr genau erkannt. Er schrieb 1917 an Besso: » Über das Machsche Rösslein schimpfe ich nicht ... Aber es könnte nichts Lebendiges gebären, sondern nur schädliches Gewürm ausrotten. «

Über Quantengravitation und Quantenkosmologie würde ein Positivist heute gar nicht nachdenlen. Er versagt sich dadurch aber von vornherein die Möglichkeit, in Neuland vorzustoßen.

Deswegen kam es schnell zur Gegenposition des Realismus :

Planck bezeichnete ihn als die Hypothese, dass

unsere Erlebnisse nicht selbst die physikalische Welt ausmachen, sondern nur Kunde geben von der wirklichen Welt.

Natürlich fordert auch der Realist, dass all seine Aussagen in Einklang mit Experimenten und tatsächlich gemachten Beobachtungen stehen. Hierin also stimmt er mit dem Positivisten überein. Darüber hinaus aber gibt es für ihn die Möglichkeit, freier Setzung und freier Spekulation:

Erst der Grad der Sicherheit, mit der diese intuitive Verknüpfung vorgenommen werden kann, unterscheide — so Einstein in Autobiographisches — leeres Spekulieren von wissenschaftlicher Wahrheit.

Fassen wir zusammen:

Positivisten verstehen sich als Beschreiber der Naturgesetze,

Realisten aber wollen auch Entdecker sein.

Wie Positivismus in der Physik zu verstehen sei, hat Max Planck 1930 einmal so zusammengefasst:

Für Positivisten » ist die Aufgabe der physikalischen Wissenschaft erschöpfend gekennzeichnet, wenn man sagt, dass sie darin bestünde, im die Summe vorliegender Naturbeobachtungen einen möglichst genauen und einfachen gesetzlichen Zusammenhang zu bringen «.

Seinen deutlichsten Ausdruck hat der Positivismus in der Denkökonomie des Ernst Mach gefunden, in der es bei der Naturbeschreibung nur daraum geht, die Erscheinungen möglichst ökonomisch zu beschreiben: Positivisten sind keine Entdecker, sondern Erfinder ökonomischer Beschreibung.

Planck war sich mit Physikern wie Einstein, Schrödinger und Pauli darin einig, dass die große Gefahr des Positivismus seine Unfruchtbarkeit sei.

Einstein, der Mach verehrt hat, hat das sehr genau erkannt. Er schrieb 1917 an Besso: » Über das Machsche Rösslein schimpfe ich nicht ... Aber es könnte nichts Lebendiges gebären, sondern nur schädliches Gewürm ausrotten. «

Über Quantengravitation und Quantenkosmologie würde ein Positivist heute gar nicht nachdenlen. Er versagt sich dadurch aber von vornherein die Möglichkeit, in Neuland vorzustoßen.

Deswegen kam es schnell zur Gegenposition des Realismus :

Planck bezeichnete ihn als die Hypothese, dass

Natürlich fordert auch der Realist, dass all seine Aussagen in Einklang mit Experimenten und tatsächlich gemachten Beobachtungen stehen. Hierin also stimmt er mit dem Positivisten überein. Darüber hinaus aber gibt es für ihn die Möglichkeit, freier Setzung und freier Spekulation:

Albert Einstein und Leopold Infeld in Die Evolution der Physik :

Physikalische Begriffe sind freie Schöpfungen des Geistes und ergeben sich nicht etwa – wie man recht leicht zu glauben geneigt ist – zwangsläufig aus den Verhältnissen der Außenwelt.

Erst der Grad der Sicherheit, mit der diese intuitive Verknüpfung vorgenommen werden kann, unterscheide — so Einstein in Autobiographisches — leeres Spekulieren von wissenschaftlicher Wahrheit.

Fassen wir zusammen:

Realisten aber wollen auch Entdecker sein.

Beitrag 0-392

Warum Quantenphysik weit genauer als klassische Physik ist

Das besonders genaue Modell der Quantenphysik

(1) Quantenphysik verfeinert den Zustandsbegriff

Die klassische Physik versucht eine Welt W zu verstehen, indem sie sich W als Summe disjunkter Teilwelten W(j) auffasst und dann davon ausgeht, dass man W kennt, sobald man alle W(j) kennt. Mit anderen Worten:

Klassische Physik geht davon aus, dass der Zustandsraum von W die direkte Summe der Zustandsräume aller W(j) sei und jedes W(j) sich autonom verhalte.

Ein Nachteil dieses Vorgehens wird sofort klar: Jede so erhaltene Beschreibung von W wird ums ungenauer sein, in je weniger kleine Teilwelten W(j) man sich W partitioniert denkt.

Quantenphysik dagegen ist genauer: Sie ist holistisch in dem Sinne, dass sie neben sämtlichen Teilwelten auch noch die Beziehungen zwischen ihnen betrachtet und sie als ebenfalls wesentliche Bestandteile von W anerkennt. Dies zu erreichen, geht Quantenphysik davon aus, dass der Zustandsraum von W das direkte Produkt der Zustandsräume all seiner kleinstmöglichen, nicht mehr teilbaren Teilwelten w(j) sein müsse.

(2) Nur Quantenphysik kennt komplementäre Größen

Als komplementär bezeichnete Niels Bohr zwei Größen, deren begrifflicher Gebrauch für das volle Verständnis einer Sache unverzichtbar ist, obgleich sie einander ausschließen.

Er hat das erklärt am Beispiel von Liebe und Gerechtigkeit: Um zu überleben benötigen Menschen beides. Und doch ist — im strengen Sinne ihrer Bedeutung — die gleichzeitige Anwendung beider nicht möglich. Sie sind komplementär.

Beispiel für Komplementarität in der Quantenphysik sind das Wellen- und das Teilchenmodell: Jede Welle ist ausgebreitet über den ganzen Raum, ein Teilchen aber wird als punktförmig und zu jeder Zeit als an einem ganz bestimmten Ort lokalisiert gedacht.

Heisenbergs Matrizenmechanik lieferte die mathematische Struktur, die zur Darstellung des Zustandsraumes, aber auch der Komplementarität in der Quantenphysik nötig war. Da sich jede quantenphysikalische Messung als linearer Operator auf dem Zustandsraum darstellt, spiegelt sich die Komplementarität in der Tatsache, dass das Produkt zweier Operatoren von der Reihenfolge ihrer Anwendung abhängt.

Die klassische Physik versucht eine Welt W zu verstehen, indem sie sich W als Summe disjunkter Teilwelten W(j) auffasst und dann davon ausgeht, dass man W kennt, sobald man alle W(j) kennt. Mit anderen Worten:

Klassische Physik geht davon aus, dass der Zustandsraum von W die direkte Summe der Zustandsräume aller W(j) sei und jedes W(j) sich autonom verhalte.

Ein Nachteil dieses Vorgehens wird sofort klar: Jede so erhaltene Beschreibung von W wird ums ungenauer sein, in je weniger kleine Teilwelten W(j) man sich W partitioniert denkt.

Quantenphysik dagegen ist genauer: Sie ist holistisch in dem Sinne, dass sie neben sämtlichen Teilwelten auch noch die Beziehungen zwischen ihnen betrachtet und sie als ebenfalls wesentliche Bestandteile von W anerkennt. Dies zu erreichen, geht Quantenphysik davon aus, dass der Zustandsraum von W das direkte Produkt der Zustandsräume all seiner kleinstmöglichen, nicht mehr teilbaren Teilwelten w(j) sein müsse.

Als komplementär bezeichnete Niels Bohr zwei Größen, deren begrifflicher Gebrauch für das volle Verständnis einer Sache unverzichtbar ist, obgleich sie einander ausschließen.

Er hat das erklärt am Beispiel von Liebe und Gerechtigkeit: Um zu überleben benötigen Menschen beides. Und doch ist — im strengen Sinne ihrer Bedeutung — die gleichzeitige Anwendung beider nicht möglich. Sie sind komplementär.

Beispiel für Komplementarität in der Quantenphysik sind das Wellen- und das Teilchenmodell: Jede Welle ist ausgebreitet über den ganzen Raum, ein Teilchen aber wird als punktförmig und zu jeder Zeit als an einem ganz bestimmten Ort lokalisiert gedacht.

Heisenbergs Matrizenmechanik lieferte die mathematische Struktur, die zur Darstellung des Zustandsraumes, aber auch der Komplementarität in der Quantenphysik nötig war. Da sich jede quantenphysikalische Messung als linearer Operator auf dem Zustandsraum darstellt, spiegelt sich die Komplementarität in der Tatsache, dass das Produkt zweier Operatoren von der Reihenfolge ihrer Anwendung abhängt.

Beitrag 0-218

Was Quantenphysik von klassischer Physik unterscheidet

Unterschiede zwischen

Quantenphysik und klassischer Physik

Unterschied 1: Die Rolle des Zufalls

Unterschied 2: Der Stellenwert von Reduktionismus

Die klassischen ebenso wie die quantischen Objekte bilden ein dynamisches Gewebe, in dem es ständig durch Wechselwirkung zu Emergenz, aber auch zu ständig neuer Trennung und Differenzierung kommt.

Unterschied 3: Beschreibungsgegenstand

Klassische Physik beschreibt F a k t e n ,

d.h. Ergebnisse quantenphysikalischer "Messung" (bzw. quantenphysikalischer Ereignisse).

Quantenphysik zeigt zudem alle durch das Eintreten solcher Fakten neu entstandenen M ö g l i c h k e i t e n .

Wichtige Konsequenz dieses Unterschiedes ist, dass — wo man ein Objekt als aus Teilen zusammengesetzt sieht —

Wie Thomas Görnitz auf den Seiten 379-381 des Buches Thomas & Brigitte Görnitz: Der kreative Kosmos (2002) über einen Beweis des No-Cloning-Theorems zeigt, sind nur die Zustände kopierbar (nachbildbar), die einen v o l l s t ä n d i g definierten quantenphysikalischen Zustand darstellen.

Sie und n u r sie sind Zustände im Sinne der klassischen Physik. Jede Messfrage, die einer quantenphysikalischen Messung zugrunde liegt, wählt einen möglichen klassischen Zustand und frägt dann, ob das Quantensystem sich in ihm befindet. Daher kann die Antwort auf die Messfrage stets nur ein JA oder ein NEIN sein.

Der gegebenen Antwort entsprechend wird die Messung den Zustand des Quantensystems

Note: Jeder vollständig bestimmte Zustand entspricht einer Richtung im Zustandsraum (d.h. einer Geraden durch dessen Ursprung). Messung verändert diese Richtung.

Statt klassischer Zustände die deutlich mehr Information tragenden quantenphysikalischen zu betrachten bedeutet nichts anders als an jeden klassischen Zustand angehängt auch die Wellenfunktion zu sehen, nach der sich das Gesamtsystem (genauer: seine Wirkwahrscheinlichkeit) ausgehend von diesem Zustand — falls er mal eingetreten sein sollte — so lange durch Zeit und Raum fortentwickelt, bis eine erneute "Messung" des Quantensystems (ein sog. Kollaps der Wellenfunktion) sie durch eine neue Version ihrer selbst ersetzt.

Wirkwahrscheinlichkeit in diesem Sinne ist das Quadrat der zeit- und ortsabhängigen Amplitude der normierten Wellenfunktion.

Man kann sie verstehen als die Nachdrücklichkeit n(x,t), mit der das Quantensystem an Stellen (x,t) der Raumzeit versucht, Quantenereignisse auszulösen.

Quantenphysik und klassischer Physik

Unterschied 1: Die Rolle des Zufalls

- Im alltäglichen Sprachgebrauch bezeichnen wir als zufällig, was durch uns nicht vorhersehbar ist.

- Nach klassischer Physik ist der Zufall eine rein subjektive Erscheinung, die überall dort auftritt, wo ein Geschehen

nicht durchschaut und vorausberechnet werden kann. Es gilt dennoch als vollkommen determiniert.

- Ganz anders in der Quantentheorie: Dort sind die Möglichkeiten eines Systems durch vollkommen festgelegt, aber nicht, aus welchen davon Fakten werden:

Die Wahrscheinlichkeiten, mit der Möglichkeiten realisierbar sind, ist genau bestimmt und berechenbar.

Die sich im Einzelfall ergebenden Fakten allerdings sind objektiv zufällig. Die Annahme, sie seinen an sich wohlbestimmt aber unbekannt,

gilt als experimentell widerlegt (Stichwort:

Bellsche Messung).

Da sich Fakten aber stets nur im Rahmen naturgesetzlich genau festgelegter Möglichkeiten ergeben können, unterscheidet sich der quantenphysikalische Zufall ganz erheblich von einer rein strukturlosen Willkür, unter deren Regie sich gleichsam alles ergeben könnte.

Unterschied 2: Der Stellenwert von Reduktionismus

Die klassischen ebenso wie die quantischen Objekte bilden ein dynamisches Gewebe, in dem es ständig durch Wechselwirkung zu Emergenz, aber auch zu ständig neuer Trennung und Differenzierung kommt.

- Eine Besonderheit der Quantenphysik besteht nun aber darin, dass solche Trennungen keineswegs räumlich erfolgen müssen: Bosonen können sich räumlich durchdringen

und dennoch als Objekte klar voneinander getrennt sein (elektromagnetische Wellen sind das wohl bekannteste Beispiel hierfür: sie ignorieren einander).

- Dennoch ist ein Tisch — ja sogar der gesamte Inhalt des Weltalls — aus Sicht der Quantenphysik ein einziges Ganzes (also nicht wie aus Sicht der klassischen Physik eine Menge kleinster, strukturloser Teile, in die sich das Ganze so zerlegen ließe, dass jeder dieser kleinsten Teile unverändert bliebe).

Unterschied 3: Beschreibungsgegenstand

Klassische Physik beschreibt F a k t e n ,

d.h. Ergebnisse quantenphysikalischer "Messung" (bzw. quantenphysikalischer Ereignisse).

Quantenphysik zeigt zudem alle durch das Eintreten solcher Fakten neu entstandenen M ö g l i c h k e i t e n .

Wichtige Konsequenz dieses Unterschiedes ist, dass — wo man ein Objekt als aus Teilen zusammengesetzt sieht —

- der Zustandsraum des Objekts in der klassischen Physik die direkte S u m m e der Zustandsräume dieser Teile ist,

- wohingegen er sich in der Quantenphysik als ihr direktes P r o d u k t ( Tensorprodukt ) darstellt.

Wie Thomas Görnitz auf den Seiten 379-381 des Buches Thomas & Brigitte Görnitz: Der kreative Kosmos (2002) über einen Beweis des No-Cloning-Theorems zeigt, sind nur die Zustände kopierbar (nachbildbar), die einen v o l l s t ä n d i g definierten quantenphysikalischen Zustand darstellen.

Sie und n u r sie sind Zustände im Sinne der klassischen Physik. Jede Messfrage, die einer quantenphysikalischen Messung zugrunde liegt, wählt einen möglichen klassischen Zustand und frägt dann, ob das Quantensystem sich in ihm befindet. Daher kann die Antwort auf die Messfrage stets nur ein JA oder ein NEIN sein.

Der gegebenen Antwort entsprechend wird die Messung den Zustand des Quantensystems

- bei Antwort JA in den Zustandsteilraum versetzt haben, der die abgefragten Eigenschaften garantiert,

- bei Antwort NEIN aber in einen zu ihm orthogonalen.

Note: Jeder vollständig bestimmte Zustand entspricht einer Richtung im Zustandsraum (d.h. einer Geraden durch dessen Ursprung). Messung verändert diese Richtung.

Statt klassischer Zustände die deutlich mehr Information tragenden quantenphysikalischen zu betrachten bedeutet nichts anders als an jeden klassischen Zustand angehängt auch die Wellenfunktion zu sehen, nach der sich das Gesamtsystem (genauer: seine Wirkwahrscheinlichkeit) ausgehend von diesem Zustand — falls er mal eingetreten sein sollte — so lange durch Zeit und Raum fortentwickelt, bis eine erneute "Messung" des Quantensystems (ein sog. Kollaps der Wellenfunktion) sie durch eine neue Version ihrer selbst ersetzt.

Wirkwahrscheinlichkeit in diesem Sinne ist das Quadrat der zeit- und ortsabhängigen Amplitude der normierten Wellenfunktion.

Man kann sie verstehen als die Nachdrücklichkeit n(x,t), mit der das Quantensystem an Stellen (x,t) der Raumzeit versucht, Quantenereignisse auszulösen.

Beitrag 0-506

Demokrit, Heisenberg und die Quantenfeld-Theorie

Demokrits Atommodell

präzisiert durch Heisenberg und die Quantenfeld-Theorie

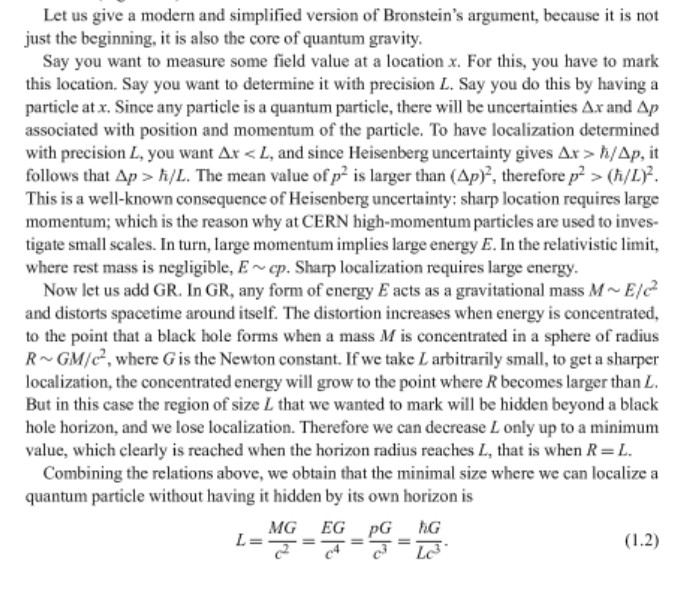

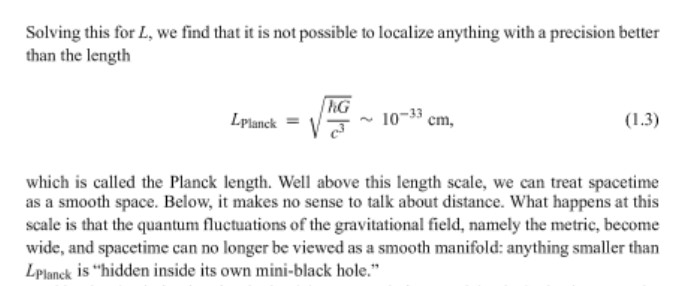

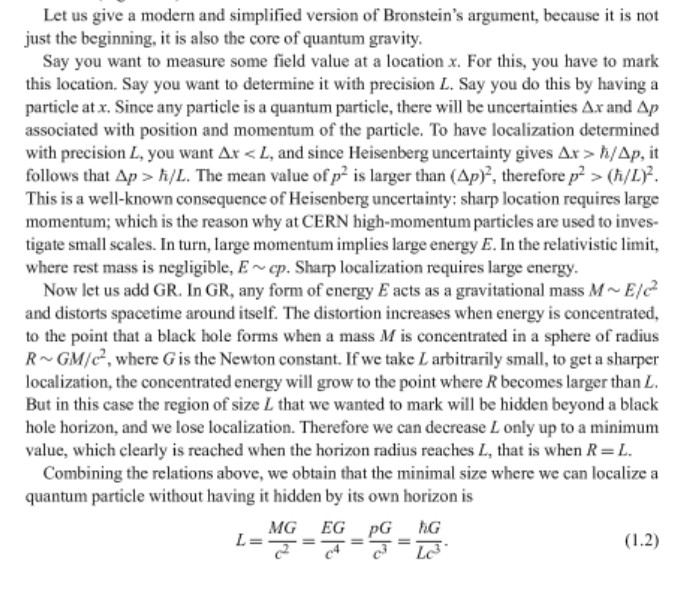

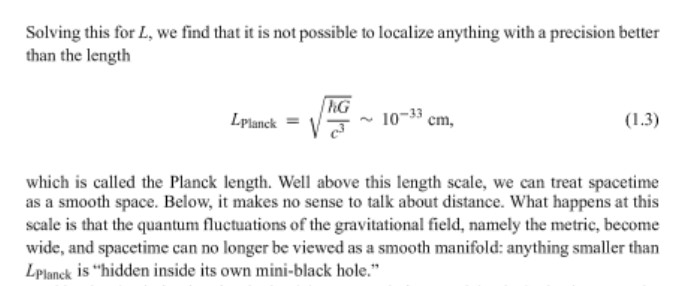

Quelle: Carlo Rovelli, Francesca Vidotto: Covariant Loop Quantum Gravity: An Elementary Introduction to Quantum Gravity and Spinfoam Theory (2014), p. 7-8

präzisiert durch Heisenberg und die Quantenfeld-Theorie

Physiker wissen (2020):

Unter einem Quant (oder Quantensystem) versteht man einen aus Strahlung und/oder Materie bestehenden Teil der Natur, der sich mit Hilfe der Quantenfeld-Theorie nicht nur prinzipiell, sondern zudem noch in praktikabler Weise deutlich zutreffender beschreiben lässt als mit den Mitteln der klassischen Physik.

Man könnte nun meinen, die Tatsache, dass jedes Quant auch System von Quanten ist, widerspreche Demokrits Atommodell. Dem aber ist nicht so, wie man einsehen kann wie folgt:

Heisenbergs Unschärfe-Relation impliziert Quantenfluktuation

und zudem noch:

- Wirklich jedes Teilchen ist ein sich durch Quantenfluktuation ständig mehr oder weniger selbst modifizierendes System harmonischer Wellen im Feld der physikalischen Grundkräfte.

Diese Wellen (sog. QuBits) stellen die unteilbaren Portionen von Energie dar, aus denen jedes in der Natur anzutreffende Boson oder Fermion besteht.

- Auf hinreichend kleiner Skala — unterhalb der Planckskala, wie Bronstein erkannt hat, — sind sie durch keinerlei Messverfahren mehr auseinanderzuhalten.

Mit anderen Worten:

Die Struktur der Wellenpakete im Feld der physikalischen Grundkräfte ist unterhalb der Planckskala ganz prinzipiell unbeobachtbar

und muss daher im Rahmen der Physik als unbestimmt angenommen werden.

Einzeln können QuBits beliebig kurz existieren, werden dann aber entsprechend energiereich sein.

Quelle: Carlo Rovelli, Francesca Vidotto: Covariant Loop Quantum Gravity: An Elementary Introduction to Quantum Gravity and Spinfoam Theory (2014), p. 7-8

Beitrag 0-462

Quanten sind als Welle oder Teilchen gedeutete Portionen von Energie

Die Wellen und Teilchen der Quantenphysik beschreiben

Energieportionen und ihr Verhalten

Wie das Fourier-Theorem zeigt, ist alles, was man Welle nennt, genau genommen Summe harmonischer (d.h. sinusförmiger) Wellen. Erst sie stellen je eine unteilbare Portion von Energie dar, und so ist letztlich nur jede solche Portion das, was man » ein unteilbares Teilchen « nennt (informationstheoretisch gesehen: » ein QuBit «).

Vieles, was im Standardmodell der Elementarteilchenphysik als Elementarteilchen gilt, ist tatsächlich ein ganzes Wellenpaket, also Summe harmonischer, sich im Raum ausbreitender Kugelwellen. Wie Heisenbergs Unschärferelation (angewandt auf das Paar Energie und Lebensdauer einer harmonischen Welle) zeigt, ist dieses Wellenpaket sogar in ständiger Abänderung seiner selbst begriffen.

Energieportionen und ihr Verhalten

Wie das Fourier-Theorem zeigt, ist alles, was man Welle nennt, genau genommen Summe harmonischer (d.h. sinusförmiger) Wellen. Erst sie stellen je eine unteilbare Portion von Energie dar, und so ist letztlich nur jede solche Portion das, was man » ein unteilbares Teilchen « nennt (informationstheoretisch gesehen: » ein QuBit «).

-

Ein besonders häufig diskutiertes Beispiel harmonischer Wellen sind Photonen:

Jedes Photon breitet sich um den Ort seines Entstehens herum aus als Oberfläche einer Kugelwelle, deren Radius sich mit Lichtgeschwindigkeit vergrößert. Da diese Welle nun aber um Hindernisse herum gebeugt wird, nimmt sie sehr schnell mehr oder weniger stark "verbeulte" Form an. Das geht so weit, dass wenn sie auf ein Gitter trifft, sie zwischen den Stäben des Gitters durchquillt und ihre so entstehenden Lappen sich hinter dem Gitter dann sogar überlagern (weswegen dann z.B. im Doppelspalt-Experiment auf einem Schirm hinter den beiden Spalten, durch die Licht kommt, Inteferenz zu sehen ist). Genauer:

Was sich auf dem Schirm hinter den Spalten zeigt, sind Punkte, deren jeder eine Stelle ist, an der ein durch den Doppelspalt gekommenes Photon seine Energie an ein Atom des Schirms abgegeben hat:

Da das Atom jene Energie aufnimmt, dann aber sofort wieder abgibt, so dass sich der Schirm, wenn er aus lichtempfindlichen Materiel besteht, dort verändert, sehen wir jenen Punkt.

Da die Wahrscheinlichkeit, dass sich das Photon an einer bestimmten Stelle des Schirms mit dem Schirm vereinigt — dort also seine gesamte Energie schlagartig abgibt und aufhört zu existieren — an den Stellen am größten ist, an denen die Amplitude der harmonischen Welle am größten ist, gruppieren sich solche Stellen dann zu einem Interferenzmuster, das wir als Interferenz von Wahrscheinlichkeitwellen deuten können.

Bei Materiewellen ist es im Prinzip ebenso, nur dass man sie gleich von vorn herein als Wahrscheinlichkeitswellen deutet. Letzten Endes aber existiert auch jede Materiewelle nur als Summe harmonischer Wellen, deren jede Auf- und Abbau von Kraft darstellt, d.h. wellenförmig schwankendes Potential, Wirkung hervorzurufen.

Vieles, was im Standardmodell der Elementarteilchenphysik als Elementarteilchen gilt, ist tatsächlich ein ganzes Wellenpaket, also Summe harmonischer, sich im Raum ausbreitender Kugelwellen. Wie Heisenbergs Unschärferelation (angewandt auf das Paar Energie und Lebensdauer einer harmonischen Welle) zeigt, ist dieses Wellenpaket sogar in ständiger Abänderung seiner selbst begriffen.

Beitrag 0-449

Quantenphysikalische Observable als Operatoren

Quantenphysikalische Observable als Operatoren

In der Quantenmechanik werden die grundlegenden Größen der klassischen Mechanik — die Ortskoordinate q etwa, der Impuls p oder die Hamilton-Funktion H(p,q) als Operatoren auf einem Hilbertraum dargestellt.

Quelle: Ilya Prigogine, Isabelle Stengers: Dialog mit der Natur —

Neue Wege naturwissenschaftlichen Denkens, Serie Piper, S. 232-233

oder das Vorlesungsskript physik.hu-berlin.de/~sokolov/QM1

In der Quantenmechanik werden die grundlegenden Größen der klassischen Mechanik — die Ortskoordinate q etwa, der Impuls p oder die Hamilton-Funktion H(p,q) als Operatoren auf einem Hilbertraum dargestellt.

Ilya Prigogine:

Wir müssen zwischen dem Operator — einer mathematischen Operation — und dem Objekt, auf das er wirkt — einer Funktion — unterscheiden:

Nehmen wir als Operator z.B. die durch d/dx dargestellte Ableitung nach x und wenden ihn an auf die Funktion f(x) = x2, so erhält man als Ergebnis die Funktion df/dx = 2x.

Bestimmte Funktion aber verhalten sich so, dass ihre Ableitung Vielfaches der Funktion selbst ist ( z.B. ist 3e3x die Ableitung von e3x ).

Jede Funktion, die man durch Anwendung eines Operators erneut erhält, nennt man Eigenfunktion des Operators, und die Zahl, mit der sie nach Anwendung des Operators multipliziert ist, nennt man einen Eigenwert des Operators.

Auf diese Weise ist jedem Operator ein Vorrat von Zahlen zugeordnet, den man sein Eigenwertspektrum nennt. Es kann diskret oder kontinuierlich sein (also z.B. aus allen ganzen Zahlen bestehen oder aus allen reellen Zahlen zwischen z.B. 0 und 1).

Sämtlichen physikalischen Größen der klassischen Mechanik entspricht in der Quantenmechanik ein Operator. Seine Eigenwerte stellen die Menge der möglichen Messwerte dar.

So wird z.B. die Energie durch den Hamilton-Operator H(p,q) dargestellt und beobachtete Energiewerte (Energieniveaus) durch dessen Eigenwerte.

oder das Vorlesungsskript physik.hu-berlin.de/~sokolov/QM1

Beitrag 0-58

Zum Begriff physikalischer Theorien und Objekte

Zum Begriff physikalischer Objekte

Die Wurzeln der Disziplin Theoretische Physik reichen zurück bis in die Zeit der Vorsokratiker (etwa 500 v.Chr.). Spätestens seit Isaac Newton bedient sich die Theoretische Physik zum Aufschreiben ihrer Ergebnisse zwingend der Mathematik. Der mathematische Zweig der Differentialrechnung etwa wurde durch Newton (und parallel dazu durch Leibniz) zu eigens diesem Zweck erfunden und entwickelt.

Dennoch sehen gerade die Vertreter der Theoretischen Physik sich häufig — und weit mehr als andere Wissenschaftler — dem Vorwurf ausgesetzt, was sie da vorbrächten sei einfach nur eine mehr oder weniger haltlose Vermutung und allzu weit hergeholt. Dem ist entgegenzuhalten, dass solche Vermutungen vor allem dem Zweck dienen, keinen Lösungsansatz zu übersehen, nur weil er so gar nicht naheliegt oder so gar nicht dem entspricht, was unsere Erfahrung uns nahelegt. Dass die meisten ihrer Denkansätze die Natur missverstehen, ist den theoretischen Physikern bewusst. Jede Idee dennoch zu prüfen und nach Argumenten zu suchen, sie zu widerlegen, ist dennoch ihre Pflicht, denn schon allzu oft hat ganz extrem Unwahrscheinliches sich später doch als wahr erwiesen.

Heute also gilt: Theoretische Physik ist kreative Anwendung hoch komplizierter mathematischer Konstrukte mit dem Hintergedanken, dass die Mathematik uns hilft, die Welt in der wir leben, zu entdecken, zu verstehen und ihrem Verhalten uns gegenüber vorhersagbar zu machen.

Aus mathematischer Sicht ist jedes physikalische Objekt ein

Gegenstand ( Eigenschaften, Theorie )

wobei

Streng genommen also ist jede Lösung der Theorie — jedes konkrete physikalische Objekt —

eine Abbildung der Menge aller Eigenschaften in die Menge aller reellen Zahlen.

Da nun aber Objekte im Sinne der Physik so gut wie immer zeitabhängig betrachtet werden — und sich ihre Eigenschaftswerte mit der Zeit ändern — werden Physiker sehr oft erst dann von einer Lösung der Theorie sprechen, wenn sie eine ganze Schar mathematischer Lösungen meinen, deren Scharparameter der Zeitwert ist.

Noch allgemeiner: Wo z.B. die Stringtheoretiker behaupten, ihre Theorie hätte so etwa 10500 Lösungen (deren jede ein konkrete Instanz des Gegenstandes "Raumzeit mit allen über die gesamte Zeit hinweg darin existierenden Dingen" beschreibt), ist damit eine Schar von Lösungen gemeint, die mindesten zwei Scharparameter hat: die Zeit einerseits und die sog. Kopplungskonstante andererseits.

Wer sich nun aber vor Augen führt, dass jedes Gleichungssystem mit mehr als zwei Unbekannten — nennen wir sie Z und K in Anlehnung ans eben gegebene Beispiel — sehr viele Lösungen haben kann, die aber alle in Z und K denselben Wert haben, so wird klar, dass jede Schar von Lösungen der Theorie selbst wieder Vereinigung kleinerer, aber immer noch beliebig großer Scharen sein kann.

Wir sehen: Die Aussage der Stringtheoretiker, ihre Theorie hätte wohl so etwa 10500 Lösungen, sagt rein gar nichts. Das einzige, was wir mit Sicherheit wissen, ist, dass die Stringtheorie — sollte ihr Gleichungssystem denn jemals endgültig formuliert sein — sicher noch weit mehr Lösungen haben wird als Einstein Feldgleichungen (d.h. die Allgemeine Relativitätstheorie). Schon die aber hat unendlich viele g e s c h l o s s e n e Lösungen — z.B. die, welche man das Gödel-Universum nennt.

Hinzu kommt: Die meisten Lösungen der Allgemeinen Relativitätstheorie sind überhaupt nicht in geschlossener Form angebbar (als Formel also), sondern nur mit Hilfe komplizierter Rechnung als Menge der sie darstellenden Eigenschaftswerte schrittweise (und stets nur näherungsweise) konstruierbar.

Nun ist allerdings zu beachten, dass Lösungen, die der Physiker sucht, fast immer Lösungen eines bestimmten Anfangswertproblems sein sollen.

Was das bedeutet, beschreibt Martin Bojowald wie folgt (unter der Voraussetzung, dass der betrachtete Gegenstand ein Modell unseres Universums sei):

Festzuhalten bleibt:

Wer von der Lösung einer Theorie spricht, meint damit i.d.R.

eine Lösung, die gewisse Randbedingungen respektiert,

die aber keineswegs aus der Theorie selbst kommen.

Lösungen solcher Art beschreiben das betrachtete physikalische Objekt dann meist auch nur lokal.

Schönes Beispiel hierfür ist die Schwarzschild-Metrik (als die Lösung von Einsteins Feldgleichungen, die 1916 als erste gefunden wurde): Karl Schwarzschild betrachtete den Außenraum einer kugelsymmetrischen Massenverteilung. Hier verschwindet der Energie-Impuls-Tensor und die Metrik hängt nur von einer radialen Koordinate ab. Die resultierende Raum-Zeit-Struktur nennt man heute ein » Schwarzes Loch «. Sie ist durch einen sog. Ereignishorizont gekennzeichnet, der die zentrale Singularität abschirmt.

Noch weit exotischer ist eine von Kurt Gödel gefundene Schar von Lösungen: der sog. » Gödelsche Kosmos «. Er lässt geschlossene Zeitlinien zu und wurde von Einstein als eher nicht die wirkliche Welt beschreibend eingestuft (genauer müsste man eigentlich sagen "keine wirklich existierende R e g i o n unserer Welt").

Die Wurzeln der Disziplin Theoretische Physik reichen zurück bis in die Zeit der Vorsokratiker (etwa 500 v.Chr.). Spätestens seit Isaac Newton bedient sich die Theoretische Physik zum Aufschreiben ihrer Ergebnisse zwingend der Mathematik. Der mathematische Zweig der Differentialrechnung etwa wurde durch Newton (und parallel dazu durch Leibniz) zu eigens diesem Zweck erfunden und entwickelt.

Dennoch sehen gerade die Vertreter der Theoretischen Physik sich häufig — und weit mehr als andere Wissenschaftler — dem Vorwurf ausgesetzt, was sie da vorbrächten sei einfach nur eine mehr oder weniger haltlose Vermutung und allzu weit hergeholt. Dem ist entgegenzuhalten, dass solche Vermutungen vor allem dem Zweck dienen, keinen Lösungsansatz zu übersehen, nur weil er so gar nicht naheliegt oder so gar nicht dem entspricht, was unsere Erfahrung uns nahelegt. Dass die meisten ihrer Denkansätze die Natur missverstehen, ist den theoretischen Physikern bewusst. Jede Idee dennoch zu prüfen und nach Argumenten zu suchen, sie zu widerlegen, ist dennoch ihre Pflicht, denn schon allzu oft hat ganz extrem Unwahrscheinliches sich später doch als wahr erwiesen.

Heute also gilt: Theoretische Physik ist kreative Anwendung hoch komplizierter mathematischer Konstrukte mit dem Hintergedanken, dass die Mathematik uns hilft, die Welt in der wir leben, zu entdecken, zu verstehen und ihrem Verhalten uns gegenüber vorhersagbar zu machen.

Aus mathematischer Sicht ist jedes physikalische Objekt ein

wobei

- sich der Gegenstand — als gedankliches Bild einer Kategorie physikalischer Objekte gleicher Art — über die genannte Menge von Eigenschaften definiert,

- jede dieser Eigenschaften durch eine Zahl quantifizierbar ist

- und die so erhaltenen Zahlen (Eigenschaftswerte) der genannten Theorie gehorchen.

- Die Theorie wiederum ist nichts anderes als ein Gleichungssystem, welches beschreibt, in welcher Abhängigkeit mögliche Werte der einzelnen Eigenschaften zueinander stehen: Jede Lösung des Gleichungssystems beschreibt — als Menge von Eigenschaftswerten — genau eine Objektinstanz.

eine Abbildung der Menge aller Eigenschaften in die Menge aller reellen Zahlen.

Da nun aber Objekte im Sinne der Physik so gut wie immer zeitabhängig betrachtet werden — und sich ihre Eigenschaftswerte mit der Zeit ändern — werden Physiker sehr oft erst dann von einer Lösung der Theorie sprechen, wenn sie eine ganze Schar mathematischer Lösungen meinen, deren Scharparameter der Zeitwert ist.

Noch allgemeiner: Wo z.B. die Stringtheoretiker behaupten, ihre Theorie hätte so etwa 10500 Lösungen (deren jede ein konkrete Instanz des Gegenstandes "Raumzeit mit allen über die gesamte Zeit hinweg darin existierenden Dingen" beschreibt), ist damit eine Schar von Lösungen gemeint, die mindesten zwei Scharparameter hat: die Zeit einerseits und die sog. Kopplungskonstante andererseits.

Wer sich nun aber vor Augen führt, dass jedes Gleichungssystem mit mehr als zwei Unbekannten — nennen wir sie Z und K in Anlehnung ans eben gegebene Beispiel — sehr viele Lösungen haben kann, die aber alle in Z und K denselben Wert haben, so wird klar, dass jede Schar von Lösungen der Theorie selbst wieder Vereinigung kleinerer, aber immer noch beliebig großer Scharen sein kann.

- Diese Tatsache übringens führt nicht selten zur Entdeckung neuer, bis dahin völlig unbekannter Phänomene. Beispiel für ein auf diesem Wege entdecktes Phönomen ist Antimaterie. Paul Dirac konnte 1928

die Existenz eines » positiv geladenen Elektrons « (man nennt es heute das Proton) vorhersagen, da sie ihm auffiel, dass eine von ihm betrachtet quadratische Gleichung statt nur einer

Lösung — die die Ladung des Elektrons beschrieb — gleich deren zwei hatte, die sich nur im Vorzeichen unterschieden.

Wir sehen: Die Aussage der Stringtheoretiker, ihre Theorie hätte wohl so etwa 10500 Lösungen, sagt rein gar nichts. Das einzige, was wir mit Sicherheit wissen, ist, dass die Stringtheorie — sollte ihr Gleichungssystem denn jemals endgültig formuliert sein — sicher noch weit mehr Lösungen haben wird als Einstein Feldgleichungen (d.h. die Allgemeine Relativitätstheorie). Schon die aber hat unendlich viele g e s c h l o s s e n e Lösungen — z.B. die, welche man das Gödel-Universum nennt.

Hinzu kommt: Die meisten Lösungen der Allgemeinen Relativitätstheorie sind überhaupt nicht in geschlossener Form angebbar (als Formel also), sondern nur mit Hilfe komplizierter Rechnung als Menge der sie darstellenden Eigenschaftswerte schrittweise (und stets nur näherungsweise) konstruierbar.

Nun ist allerdings zu beachten, dass Lösungen, die der Physiker sucht, fast immer Lösungen eines bestimmten Anfangswertproblems sein sollen.

Was das bedeutet, beschreibt Martin Bojowald wie folgt (unter der Voraussetzung, dass der betrachtete Gegenstand ein Modell unseres Universums sei):

Bojowald ( S. 309-311 seines Buches Zurück vor den Urknall ):

In der Kosmologie spielt die Eindeutigkeit der Lösung einer Theorie der Raumzeit eine wichtige Rolle — denn schließlich können wir ja nur ein einziges Universum beobachten: da, in dem wir leben. Leider erhält man Eindeutigkeit nie umsonst, sondern stets nur über zusätzliche (die Theorie einschränkenden) Annahmen, die mehr oder weniger natürlich erscheinen mögen. Sie treten in zwei prinzipiell unterschiedlichen Rollen auf:

- als Annahmen, die zum Aufstellen einer Theorie nötig sind,

- aber auch als Annahmen zur Auswahl von Lösungen der dann schließlich gegebenen Theorie.

Zu Annahmen der zweiten Art kommt man über eine standardisierte Operation, die eng mit der mathematischen Art der Gleichungen zusammenhängt, die in in physikalischen Gesetzen Verwendung finden: Es sind dies (meist partielle) Differential-, hin und wieder aber auch Differenzengleichungen, die zu bestimmen haben, wie sich eine Größe ändert, wenn man sich in Raum oder Zeit — oder im Sinne eines anderen abstrakten Parameters — bewegt.

Um die Lösung eindeutig zu machen, reicht es nun aber nicht, lediglich zu wissen, wie sich sich ändert, wenn man sich bewegt: Man benötigt zusätzlich einen Standpunkt, von dem aus solche Änderungen ausgehen. Er kann seinAnfangs- und Randbedingung können als das theoretische Äquivalent der Entscheidung eines Experimentators zu Aufbau und Durchführung seines Experiments angesehen werden. Die Theorie selbst aber soll, mindestens näherungsweise, dem Verhalten der Natur entsprechen — so wie uns auferlegte Naturgesetze es erwarten lassen.

- eine Anfangsbedingung (d.h. man legt fest, welchen Wert die untersuchte Größe zu dem Z e i t p u n k t hat, von dem man ausgeht)

- oder eine Randbedingung (was bedeutet, dass man festlegt, von welchem Wert der Größe man am Rande des jeweils untersuchten R a u m g e b i e t e s ausgeht)

Ein Experiment ist dann immer eine spezielle Situation in der Natur, die durch den Experimentaufbau (z.B. ein Pendel) und die gewählte Ausgangsposition (z.B. die Position, von der aus man das Pendel frei schwingen lässt) spezifiziert ist.

Also: Die Theorie wird durch die Wahl eines bestimmten natürlichen Phänomens fixiert, aber erst seine spezifische Realisierung liefert die Randbedingungen, von denen ausgehend man unter Berücksichtigung seiner allgemeinen Möglichkeiten eine Lösung sucht.

Festzuhalten bleibt:

eine Lösung, die gewisse Randbedingungen respektiert,

die aber keineswegs aus der Theorie selbst kommen.

Lösungen solcher Art beschreiben das betrachtete physikalische Objekt dann meist auch nur lokal.

Schönes Beispiel hierfür ist die Schwarzschild-Metrik (als die Lösung von Einsteins Feldgleichungen, die 1916 als erste gefunden wurde): Karl Schwarzschild betrachtete den Außenraum einer kugelsymmetrischen Massenverteilung. Hier verschwindet der Energie-Impuls-Tensor und die Metrik hängt nur von einer radialen Koordinate ab. Die resultierende Raum-Zeit-Struktur nennt man heute ein » Schwarzes Loch «. Sie ist durch einen sog. Ereignishorizont gekennzeichnet, der die zentrale Singularität abschirmt.

Noch weit exotischer ist eine von Kurt Gödel gefundene Schar von Lösungen: der sog. » Gödelsche Kosmos «. Er lässt geschlossene Zeitlinien zu und wurde von Einstein als eher nicht die wirkliche Welt beschreibend eingestuft (genauer müsste man eigentlich sagen "keine wirklich existierende R e g i o n unserer Welt").

Beitrag 0-136

Jedes physikalische Modell hat zwei Ebenen unterschiedlicher Verbindlichkeit: Begriffe und Relationen

Die beiden Ebenen physikalischer Modelle

Nach Josef Honerkamp — er war 30 Jahre lang Professor für Theoretische Physik — gibt es in jedem physikalischen Modell zwei Ebenen, die keineswegs gleich verbindlich sind:

Die Ebene der Begriffe ergibt sich aus unseren Denkgewohnheiten: Noch Unverstandenes versuchen wir zu begreifen, indem wir es mit Dingen vergleichen, die wir schon gut verstanden zu haben glauben.

Im Nachhinein, so schreibt Honerkamp, erscheinen uns überwundene Vorstellungen von einem Begriff wie Vorurteile, und so könne die Wissenschaft insgesamt als ein nie endendes Menschheitsprojekt zur Überwindung von Vorurteilen gesehen werden.

Quelle: Josef Honerkamp:

Wissenschaft und Weltbilder, Springer 2015, S. 144-171

Nach Josef Honerkamp — er war 30 Jahre lang Professor für Theoretische Physik — gibt es in jedem physikalischen Modell zwei Ebenen, die keineswegs gleich verbindlich sind:

- die Ebene der Begriffe

- und die Ebene der Relationen zwischen diesen Begriffen.

Die Ebene der Begriffe ergibt sich aus unseren Denkgewohnheiten: Noch Unverstandenes versuchen wir zu begreifen, indem wir es mit Dingen vergleichen, die wir schon gut verstanden zu haben glauben.

Im Nachhinein, so schreibt Honerkamp, erscheinen uns überwundene Vorstellungen von einem Begriff wie Vorurteile, und so könne die Wissenschaft insgesamt als ein nie endendes Menschheitsprojekt zur Überwindung von Vorurteilen gesehen werden.

- Besonders klar wird das, wenn man sich vor Augen führt, wie der Begriff » Materie « sich im Laufe der Zeit gewandelt hat:

Noch Ende des 19. Jahrhunderts sahen die Physiker Materie als Menge von Atomen, deren jedes man sich zunächst als kleines Körnchen vorgestellt hat.

1911 hat Rutherford den Begriff des Körnchens ersetzt durch sein Planetenmodell, und schon 2 Jahre später sprach Bohr von einem Schalenmodell.

Der damaligen Denkgewohnheit entsprechend hat man sich mechanische Modelle gewünscht (wie es diese 3 Vorstellungen ja auch waren). Der britische Physiker Lord Kelvin etwa soll offen bekannt haben, dass er die Maxwellschen Gleichungen nicht verstehen könne, da ihm ein mechanisches Modell dazu fehle.

Erst langsam akzeptierten die Physiker, dass die Welt nicht nur aus Teilchen, sondern auch aus Feldern bestehend gedacht werden kann.

Heute — etwa 100 Jahre später — beginnt man, den Teilchenbegriff im atomaren und subatomaren Bereich ganz fallen zu lassen und voll auf den Feldbegriff zu setzen: Jede Art von Elementarteilchen wird als wellenförmige Anregung eines dieser Art zugeordneten Feldes gesehen.

Ein Wasserstoffatom etwa würden wir heute gar nicht mehr als "real" existierend ansehen, wenn mit "real" gemeint sin soll, dass es all seinen Eigenschaften nach stets wohlbestimmt und vor allem auch irgendwo lokalisierbar ist. Wir sehen ein, dass es Realität solcher Art ganz offensichtlich erst beginnend mit der Skala mittler Dimensionen gibt (der mesoskopischen).

Honerkamp drückt es so aus:

Heute müssen wir konstatieren, dass die Quantenmechanik eine in allen Experimenten erfolgreich geprüfte Theorie ist, die uns zeigt, dass die Natur auf der atomaren Ebene durch ganz andere Gesetze [durch nicht-mechanische] beschrieben werden muss und dass die Objekte auf dieser Größenskala von ganz neuer Art sind — neu im Hinblick auf alles, was wir in unserer Welt der mittleren Diemensionen kennen.

Zwar kommen wir manchmal mit der Vorstellung, dass diese Objekte Teilchen wären, noch ganz gut zurecht. Aber das hat Grenzen.

Wir nennen diese Objekte jetzt Quanten und sehen, dass sie mit nichts vergleichbar sind, was wir sonst im Laufe der Evolution erfahren und kennen gelernt haben.

Beitrag 0-155

Steven Hawking: Zum Wesen physikalischer Modelle

Steven Hawkings Standpunkt

Über die Grenzen physikalischer Modelle

Quelle: Hawking und Penrose: Raum und Zeit, Rowohlt 1998, Seite 10

Titel der Originalausgabe: The Nature of Space and Time, Princeton University Press (1996)

Note: Wissenschaftstheoretiker verstehen unter dem positivistischen Standpunkt die Überzeugung, dass man sich zum Gewinnen von Erkenntnissen nur auf positive Befunde im Sinne der Naturwissenschaften zu stützen und transzendentale Begründungen zu verwerfen habe.

Über die Grenzen physikalischer Modelle

Hawking 1996:

Ich nehme den positivistischen Standpunkt ein, dass jede physikalische Theorie nur ein mathematisches Modell darstellt und dass es nicht sinnvoll ist, zu fragen, ob es der Wirklichkeit entspricht:

Man kann nur fragen, ob seine V o r h e r s a g e n mit den Beobachtungen in Einklang stehen.

Titel der Originalausgabe: The Nature of Space and Time, Princeton University Press (1996)

Note: Wissenschaftstheoretiker verstehen unter dem positivistischen Standpunkt die Überzeugung, dass man sich zum Gewinnen von Erkenntnissen nur auf positive Befunde im Sinne der Naturwissenschaften zu stützen und transzendentale Begründungen zu verwerfen habe.

Beitrag 0-157

Genauigkeit und Grenzen der derzeit aktuellen physikalischen Modelle

Genauigkeit der aktuellen physikalischen Theorien

Die derzeit aktuellen, durch viele Experimente gut bestätigten physikalischen Theoren des 20. Jahrhunderts sind

Quelle: Hawking und Penrose: Raum und Zeit, Rowohlt 1998,

Seite 87-89

Titel der Originalausgabe: The Nature of Space and Time, Princeton University Press (1996)

Die derzeit aktuellen, durch viele Experimente gut bestätigten physikalischen Theoren des 20. Jahrhunderts sind

- Quantentheorie (QT),

- Spezielle Relativitätstheorie (SRT)

- Allgemeine Relativitätstheorie (ART) und

- Quantenfeldtheorie (QFT), welche QT und SRT zusammenführt zum Standardmodell der Elementarteilchen.

- Gravitationswellen abhören und verstehen, was sie uns sagen

Roger Penrose schreibt ( 1996 ):

Manche behaupten, die QFT sei mit ihrer Genauigkeit von etwa 1 : 1011 die bisher genaueste physikalische Theorie.

Ich jedoch möchte darauf hinweisen, dass sich die ART inzwischen in einem wohldefinierten Sinne mit einer Genauigleit von sogar 1 : 1014 als korrekt erwiesen hat und dass die i.W. nur die entsprechend beschränkte Präzision der Uhren auf der Erde zu dieser Grenze führt.

Ich rede da vom Binärpulsar PSR 1913 + 16, d.h. von zwei sich umkreisender Neutronensterne, von denen einer ein Pulsar ist.

Der ART nach sollte die Umlaufbahn allmählich enger (und die Periode entsprechend kürzer) werden, da wegen der Aussendung von Gravitationswellen Energie verloren geht.

Und genau das hat man beobachtet; die gesamte Beschreibung der Bewegung, welche von den Newtonschen Bahnen an einem Ende der ART-Korrekturen in der Mitte bis hin zu der Beschleunigung der Bahnbewegung durch Gravitationswellen am anderen Ende führt, stimmt mit der Vorhersage der ART (in welche ich Newtons Theorie mit einbeziehe) überein — und zwar mit der eben erwähnten Genauigkeit.

Dies hat sich aus Beobachtungen über einen Zeitraum von 20 Jahren hinweg ergeben.

Den Entdeckern dieses Systems wurde völlig zu Recht der Nobelpreis verliehen.

Quantentheoretiker haben immer wieder verlangt, man solle wegen der Genauigkeit ihrer Theorie die ART ändern, um sie in den Rahmen der QT einzufassen. Ich aber glaube, dass es jetzt an der QFT ist, ein wenig auzuholen.

Obgleich diese Theorien ganz bemerkenswert erfolgreich sind, haben sie doch auch Probleme:

- Das der QFT besteht darin, dass man bei der Berchnung der Amplitude eines mehrfach zusammenhängenden Feynman-Diagramms zunächst stets eine nach unendlich divergierende Antwort bekommt. Diese Unendlichkeiten müssen als Teil des Renormierungsprozesses der Theorie subtrahiert und wegskaliert werden (ein mathematisch fragwürdiges Vorgehen).

- Die ART sagt die Existenz raumzeitlicher Singularitäten voraus.

- In der QT schließlich gibt es das » sog. Messproblem «.

Vielleicht liegt die Lösung dieser Probleme in der Beseitigung möglicher Ungenauigkeiten dieser Theorien.

- Viele gehen z.B. davon aus, dass die QFT die Singularitäten der ART irgendwie » ausschmieren « könnte.

- Die Divergenzprobleme der QFT könnten — tweilweise wenigstens — durch ein ultraviolettes Cutoff aus der ART gelöst werden.

- Das Messproblem der QT, so denke ich, wird letztlich dadurch gelöst werden, dass man ART und QT sinnvoll zu einer neuen Theorie vereinigt.

Titel der Originalausgabe: The Nature of Space and Time, Princeton University Press (1996)

Beitrag 0-165

Feldtheorien und Elementarteilchen-Modelle darf man nicht allzu wörtlich nehmen

Alle heute bekannten Elementarteilchen-Modelle

sind nur effektive Theorien

Eine Theorie wird effektiv genannt, wenn sie eine (meist noch unbekannte) tiefere Theorie vereinfachend oder zusammenfassend darstellt

mit dem Ziel, praktikabel zu werden.

Quelle: Rüdiger Vaas: Vom Gottesteilchen zur Weltformel, Kosmos-Verlag 2013, S. 62-65

sind nur effektive Theorien

mit dem Ziel, praktikabel zu werden.

Rüdiger Vaas (2003):

Obgleich ein operationaler Teilchenbegriff in der Experimentalphysik unverzichtbar bleibt — die Partikel werden dort als mikroskopische Ursache lokaler Wirkungen gesehen (als Klicks im Zählrohr-Detektor, als Lichtblitze oder als Spur in einer Nebelkammer) — bedeutet das noch lange nicht, dass Teilchen mikroskopische Bestandteile makroskopischer Dinge sind:

Sehr wahrscheinlich geben selbst die besten gegenwärtigen Theorien der Elementarteilchenphysik trotz aller Erfolge keine fundamentale, sondern nur eine effektive Beschreibung.

Es ist nicht einmal klar, von welchen Entitäten die Quantenfeldtheorien denn eigentlich handeln bzw. welche Teile der Formalismen überhaupt etwas physikalisch Reales repräsentieren:

- Beschreiben sie wirklich Felder, wie es den Anschein hat und meistens angenommen wird?

- Und was sind Felder genau?

- Kann man sich Feldquanten oder Wellenpakete auch ohne sie vorstellen?

- Oder sind ganz andere Kategorien des Seins anzunehmen, Eigenschaftsbündel etwa?

- Oder handelt es sich um abstrakte Beziehungen oder Strukturen?

All diese Alternativen werfen schwierige Probleme auf. Im sog. Strukturenrealismus beispielsweise wird neuerdings der relationale Charakter der Entitäten betont. Demnach wäre das, was Materie » ist «, gar nicht so wichtig, wäre vielleicht sogar unerkennbar, im Vergleich zur Deutlichkeit, mit der sich die abstrakten Beziehungen zeigen.

Ein solcher Strukturen-Realismus spiegelt sich auch in der Klassifikation der verschiedenen Quanten oder Quantenfelder wider, wie sie durch abstrakte Symmetrien — durch Gruppen im Sinne der Gruppentheorie — erfasst werden.

Solche Relationen gelten

- in den Varianten des ontischen Struktur-Realismus als real und eventuell sogar fundamental,

- in den epidemistischen Varianten aber nur als Beschreibungswerkzeuge, so dass sich dann die Frage stellt, was diese Strukturen gewissermaßen aufspannt.

Will man keinen antinaturalistischen Platonismus vertreten — d.h. behaupten, dass nur » reine Ideen « real sind « sondern stattdessen einen wissenschaftlichen Realismus, so müsste geklärt werden, zwischen was die strukturellen Beziehungen denn eigentlich bestehen.

Die alten Fragen der vorsokratischen Philosophen sind also nach wie vor ungelöst, aber aktueller und diffiziler denn je.

Auf jeden Fall gilt:

Den modernen Quantenfeldtheorien zufolge gibt es

weder klassische Teilchen noch räumlich lokalisierbare Trajektorien (Bahnen).

Die von Heisenberg nachgewiesene Unschärfe von Ort, Impuls, Energie und Zeitpunkt

- setzt nicht nur Grenzen für Messung,

- sondern unterminiert darüber hinaus auch das Konzept klassischer Eigenschaften.

Innere Freiheitsgrade und Eigenschaften von "Teilchen" sind extrem unanschaulich (Spin) und z.T. sogar ständig wechselnd (etwa bei Neutrino-Oszillation).

Ferner sind Teilchen gleichen Typs ununterscheidbar — man kann sie also nicht mal in Gedanken nummerieren oder unterschiedlich einfärben.

Seltsam ist auch ihre quantenmechanische Nicht-Lokalität (wie Verschränkung sie zeigt).

Trotzdem sind "Teilchen" experimentell lokalisierbar.

Noch kurioser: Die Zahl solcher "Teilchen" kann je nach Bezugssystem unterschiedlich sein (Unruh-Effekt), ist also beobachterabhängig.

Zudem kommt es laufend zu Erzeugung, Vernichtung und Transformation von "Teilchen" bis hin zu beliebig virtuellen, die sich nicht wirklich aus dem Vakuum isolieren lassen, aber dennoch messbare Effekte haben (Lamb-Shift, Casimir-Effekt).

Und selbst der Raum scheint den spekulativen Ansätzen der Quantengravitationstheorie zufolge emergent zu sein, d.h. aus fundamentaleren Entitäten aufgebaut. Es deutet sich an, dass er möglicherweise noch nicht mal irreduzibel 3-dimensional ist.

Nach diesen atemberaubenden Entwicklungen der Teilchenphysik, die aber noch keineswegs abgeschlossen sind, muss man sich fragen, was letztlich vom klassischem Atomismus noch übrig bleibt: und das, obgleich er doch bis Ende des 19. Jahrhunderts nur Spekulation, dann aber so glänzend bestätigt schien.

Beitrag 0-308

Wie sich moderne Physik ein Quant vorstellt

Wie man sich Quanten vorzustellen hat

Die moderne Physik modelliert jedes unteilbare Q u a n t als eine sich wellenförmig ausbreitende Feldanregung in einem der 4 Felder physikalischer Grundkräfte:

Da der Raum 3 Dimensionen hat, handelt es sich dabei um Kugelwellen.

Jede von ihnen breitet sich aus analog zur Anregung einer ruhenden Wasseroberfläche, die zustande kommt, wenn man einen Stein ins Wasser wirft: Man kann beobachten, dass die Welle sich kreisringartig ausbreitet, an Hindernissen gebeugt wird und dass solche Wellen miteinander interferieren. Die Front der Welle ist der äußere Rand des Kreisringes, ihr Ende sein innerer Rand, und der Beugung an einem Hindernes wegen, muss dieser Rand seine kreisförmige Form nicht behalten. Hinter Hindernissen, um die herum er gedrückt wird, kann er sogar mit sich selbst interferieren [ Stichwort: Doppelspaltexperiment ].

Mit Anregungen 3-dimensionaler Felder ist es nicht anders: Jede von ihnen breitet sich aus wie die Haut eines Ballons, der aufgeplasen wird. Präsent — in dem Sinne, dass sie dort Kraft darstellt und somit Wirkung hervorrufen kann — ist die 3-dimensionale Welle überall dort, wo sich die Haut des Ballons gerade befindet.

Jede Feldanregung trägt eine unteilbare Portion von Energie — Energie also, die nur auf einen Schlag verbraucht werden kann in dem Sinne, dass sie sich mit einem anderen Quant vereinigt und diese Vereinigung — als neues Quant, das nicht selten sofort wieder zerfällt — neue Feldanregungen zur Folge hat: Die Summe sie darstellender Portionen von Energie ist immer gleich der Summe der beiden Portionen von Energie, deren Kollision das Quantenereignis ausgelöst hat.

Über solche Ereignisse hinaus wird natürlich auch jede Quantenfluktuation Feldanregungen erzeugen.

Jede dieser Kugelwellen — jedes Quant — existiert, bis es sich als unteilbare Portion von Energie schlagartig

mit einem anderen vereinigt

und die Stelle, an der das geschieht, zum Ausgangspunkt neuer Feldanregungen wird.

Note: Der Welle-Teilchen-Dualismus gilt heute als überholt, da wir jetzt wissen, dass das "Teilchen" als Kugelwelle weit ausgebreitet sein kann und die Region, in der es existiert, nicht verwechselt werden darf mit dem Punkt darin, an dem es "beobachtet" wird, an der es also aufhört zu existieren. Was wir von dort empfangen und als das beobachtete "Teilchen" interpretieren, sind schon die neu entstandenen Feldanregungen.

VORSICHT aber:

Dieses Quantenmodell stellt Realität dar — nicht notwendig die uns unbekannte Wirklichkeit.

Eben das sagt uns in etwas anderen Worten auch Hawking als Kosmologe:

Natürlich sind diese beiden Vertreter der Theoretischen Physik nicht die einzigen, die das so sehen. Vor ihnen haben schon Niels Bohr, Immanuel Kant und sogar der Vorsokratiker Parmenides (etwa 500 v. Chr.) darauf hingewiesen.

Die moderne Physik modelliert jedes unteilbare Q u a n t als eine sich wellenförmig ausbreitende Feldanregung in einem der 4 Felder physikalischer Grundkräfte:

- dem elektromagnetischen Feld,

- dem Feld der schwachen Wechselwirkung,

- dem Feld der starken Wechselwirkung und — nicht zuletzt —

- dem Gravitationsfeld.

Da der Raum 3 Dimensionen hat, handelt es sich dabei um Kugelwellen.

Jede von ihnen breitet sich aus analog zur Anregung einer ruhenden Wasseroberfläche, die zustande kommt, wenn man einen Stein ins Wasser wirft: Man kann beobachten, dass die Welle sich kreisringartig ausbreitet, an Hindernissen gebeugt wird und dass solche Wellen miteinander interferieren. Die Front der Welle ist der äußere Rand des Kreisringes, ihr Ende sein innerer Rand, und der Beugung an einem Hindernes wegen, muss dieser Rand seine kreisförmige Form nicht behalten. Hinter Hindernissen, um die herum er gedrückt wird, kann er sogar mit sich selbst interferieren [ Stichwort: Doppelspaltexperiment ].

Mit Anregungen 3-dimensionaler Felder ist es nicht anders: Jede von ihnen breitet sich aus wie die Haut eines Ballons, der aufgeplasen wird. Präsent — in dem Sinne, dass sie dort Kraft darstellt und somit Wirkung hervorrufen kann — ist die 3-dimensionale Welle überall dort, wo sich die Haut des Ballons gerade befindet.

Jede Feldanregung trägt eine unteilbare Portion von Energie — Energie also, die nur auf einen Schlag verbraucht werden kann in dem Sinne, dass sie sich mit einem anderen Quant vereinigt und diese Vereinigung — als neues Quant, das nicht selten sofort wieder zerfällt — neue Feldanregungen zur Folge hat: Die Summe sie darstellender Portionen von Energie ist immer gleich der Summe der beiden Portionen von Energie, deren Kollision das Quantenereignis ausgelöst hat.

Über solche Ereignisse hinaus wird natürlich auch jede Quantenfluktuation Feldanregungen erzeugen.

und die Stelle, an der das geschieht, zum Ausgangspunkt neuer Feldanregungen wird.

Note: Der Welle-Teilchen-Dualismus gilt heute als überholt, da wir jetzt wissen, dass das "Teilchen" als Kugelwelle weit ausgebreitet sein kann und die Region, in der es existiert, nicht verwechselt werden darf mit dem Punkt darin, an dem es "beobachtet" wird, an der es also aufhört zu existieren. Was wir von dort empfangen und als das beobachtete "Teilchen" interpretieren, sind schon die neu entstandenen Feldanregungen.

VORSICHT aber:

Dieses Quantenmodell stellt Realität dar — nicht notwendig die uns unbekannte Wirklichkeit.

Josef Hohnerkamp ( 2015 auf S. 244 seines Buches Wissenschaft und Weltbilder ):

Wir können einzelne Quanten manupulieren und genau berechnen, wie sie sich in jeder experimentellen Situation verhalten,

aber wir werden nie sagen können, was ein Quant denn in Wirklichkeit ist.

Eben das sagt uns in etwas anderen Worten auch Hawking als Kosmologe:

Steven Hawking ( 1993 ):

Es hat keinen Zweck, sich auf die Wirklichkeit zu berufen, da wir kein modellunabhängiges Konzept der Wirklichkeit besitzen.

Nach meiner Meinung ist der unausgesprochene Glaube an eine modellunabhängige Wirklichkeit der tiefere Grund für die Schwierigkeiten, die Wissenschaftsphilosophen mit der Quantenmechanik und dem Unbestimmtheitsprinzip haben.

Quelle: Mein Standpunkt

Natürlich sind diese beiden Vertreter der Theoretischen Physik nicht die einzigen, die das so sehen. Vor ihnen haben schon Niels Bohr, Immanuel Kant und sogar der Vorsokratiker Parmenides (etwa 500 v. Chr.) darauf hingewiesen.

Beitrag 0-239

Die beiden notwendigen — sich gut ergänzenden — physikalischen Weltmodelle

Klassische und quantenphysikalische Weltbeschreibung

Die Weltbeschreibung der klassischen Physik zerlegt die Welt in Objekte, die einzeln erkannt und untersucht werden können. und unter Wechselwirkung ihre Identität und Eigenexistenz behalten. Es wird damit möglich, zu betrachten, wie sich ihr Zustand über die Zeit inweg entwickelt.

Anders die Weltbeschreibung der Quantenphysik: Sie erkennt, dass Wechselwirkung den quantenphysikalischen Objekten — die man dort ja sämtlich als Pakete von Feldanregungen sieht — ihre Identität nimmt und sie in etwas aufgehen lässt, in dem sie so verschmelzen sind, dass sie danach nicht mehr als einzeln existent — als sich selbst bestimmte Form gebend — aufgefasst werden können.

Da der rein quantenphysikalische Zustand der Welt — als Wellenfunktion des Universums — keine durch ständige Veränderung uns nahe gelegte Zeit kennt, sind Vergangenheit, Gegenwart und Zukunft in ihr nicht wirklich vorhanden. Sie ist zeitlos, denn der Zeitparameter der Wellenfunktion ist dort nur eine Dimension im mathematischen Sinne.

Die Zeitlosigkeit des quantenphysikalischen Weltmodells führt zum seltsamen Phänomen von "delayed choice", der verzögerten Wahl, bei der jeder Kollaps der Wellenfunktion neu entscheidet, was als zuvor gewesen gilt, so dass ein Unterschied zwischen früher und später jeden Sinn verliert.

Das Verbleiben des Quantischen im Bereich der Möglichkeiten hat zur Folge, dass das Mitteilen und Erklären auch quantischer Zusammenhänge nur im Rahmen klassischer Physik möglich ist. Andererseits ist das Quantische Grundlage auch jeder quantischen Weltbeschreibung. Mit anderen Worten:

Für eine vollständige Erfassung des Weltgeschehens sind b e i d e Beschreibungen unverzichtbar.

Görnitz bezeichnet dies als die dynamische Schichtenstruktur unserer Welt und schreibt:

Quelle: Thomas &

Brigitte Görnitz: Der kreative Kosmos, Spektrum-Verlag (2002), S. 327-328

Da ständiger Kollaps der Wellenfunktion die quantenphysikalische Beschreibung unserer Welt laufend durch eine leicht abgeänderte Version ihrer selbst ersetzt, lässt sich das quantenphysikalische Weltbild mit einem Film vergleichen, dessen schnell aufeinander folgende Bilder (Frames, wie der Fachman sagt) die durch jeweils einen Kollaps der Wellenfunktion geschaffenen Fakten zeigen.

Die Weltbeschreibung der klassischen Physik entspricht dem, was der Betrachter dieses Filmes sieht und was er gerade noch registrieren kann.

Mathematisch gedacht könnte man jeden Frame F des Films — der einen faktisch gewordenen Zustand X zeigt — vergleichen mit dem Tangentenraum an eine differenzierbare Mannigfaltigkeit W, welche unsere Welt nicht nur als Ergebnis von Ereignis X, sondern über die gesamte Raumzeit hinweg modelliert.

Die Weltbeschreibung der klassischen Physik zerlegt die Welt in Objekte, die einzeln erkannt und untersucht werden können. und unter Wechselwirkung ihre Identität und Eigenexistenz behalten. Es wird damit möglich, zu betrachten, wie sich ihr Zustand über die Zeit inweg entwickelt.

Anders die Weltbeschreibung der Quantenphysik: Sie erkennt, dass Wechselwirkung den quantenphysikalischen Objekten — die man dort ja sämtlich als Pakete von Feldanregungen sieht — ihre Identität nimmt und sie in etwas aufgehen lässt, in dem sie so verschmelzen sind, dass sie danach nicht mehr als einzeln existent — als sich selbst bestimmte Form gebend — aufgefasst werden können.

Da der rein quantenphysikalische Zustand der Welt — als Wellenfunktion des Universums — keine durch ständige Veränderung uns nahe gelegte Zeit kennt, sind Vergangenheit, Gegenwart und Zukunft in ihr nicht wirklich vorhanden. Sie ist zeitlos, denn der Zeitparameter der Wellenfunktion ist dort nur eine Dimension im mathematischen Sinne.

Die Zeitlosigkeit des quantenphysikalischen Weltmodells führt zum seltsamen Phänomen von "delayed choice", der verzögerten Wahl, bei der jeder Kollaps der Wellenfunktion neu entscheidet, was als zuvor gewesen gilt, so dass ein Unterschied zwischen früher und später jeden Sinn verliert.

Das Verbleiben des Quantischen im Bereich der Möglichkeiten hat zur Folge, dass das Mitteilen und Erklären auch quantischer Zusammenhänge nur im Rahmen klassischer Physik möglich ist. Andererseits ist das Quantische Grundlage auch jeder quantischen Weltbeschreibung. Mit anderen Worten:

Görnitz bezeichnet dies als die dynamische Schichtenstruktur unserer Welt und schreibt:

Görnitz (2002):

Die Schichtenstruktur ergibt sich, da sich die Welt weder voll deterministisch noch nur durch Zufall gesteuert entwickelt.

Da die menschliche Psyche ein Teil der Natur ist, wird auch sie sämtlichen Gesetzmäßigkeiten unterworfen sein, die für die Natur generell gelten. Und so wirkt auch in ihrem Bereich die dynamische Schichtenstruktur.

Phsychoanalytische Konzeptionen ebenso wie die Säuglingsforschung bestätigen diese Erwartung.

Freud etwa definiert eine ihm wichtige Unterscheidung in primär und sekundär prozesshaftes Denken. Im Sinne dieser Unterscheidung sind

- die primären Prozesse jene, die unbewusst ablaufen und weder die klassische Logik noch die reale Zeitstruktur berücksichtigen.

- Sekundärprozesshaftes Denken ist das streng rationale Denken, welches im sich selbst reflektierenden Bewusstsein mündet.

Freud war der Meinung, dass letzteres erst später ausgebildet werde, dass also nur das primärprozessartige Denken von Anfang an gegeben sei.

Heute denkt man, dass das eher nicht richtig ist und dass auch das primär prozessartige Denken sich mit der Zeit verändere.

Da ständiger Kollaps der Wellenfunktion die quantenphysikalische Beschreibung unserer Welt laufend durch eine leicht abgeänderte Version ihrer selbst ersetzt, lässt sich das quantenphysikalische Weltbild mit einem Film vergleichen, dessen schnell aufeinander folgende Bilder (Frames, wie der Fachman sagt) die durch jeweils einen Kollaps der Wellenfunktion geschaffenen Fakten zeigen.

Die Weltbeschreibung der klassischen Physik entspricht dem, was der Betrachter dieses Filmes sieht und was er gerade noch registrieren kann.

Mathematisch gedacht könnte man jeden Frame F des Films — der einen faktisch gewordenen Zustand X zeigt — vergleichen mit dem Tangentenraum an eine differenzierbare Mannigfaltigkeit W, welche unsere Welt nicht nur als Ergebnis von Ereignis X, sondern über die gesamte Raumzeit hinweg modelliert.

Beitrag 0-240

Verschiebung (im Sinne der Psychologie) und ...

Verschiebung (im Sinne der Psychologie)

und was sie quantenphysikalisch sein könnte

Man versteht darunter die Tatsache, dass der Akzent — die emotionale Bedeutung oder auch die Intensität — von Vorstellungen sich von ihnen lösen und auf andere übertragen kann, die mit den ersten durch Emotionsketten verbunden sind.

Quanteninformation kann sich unter bestimmten Bedingungen in Teile aufspalten, und diese Teile können sich als eigenständige Objekte mit anderen neu zusammenfinden und so neue Ganzheiten bilden.

Derartige Vorgänge finden auch bei einer Verschiebung statt, die sich im Unterbewusstsein abspielt, bei dem sich ein emotionaler Informationsanteil — z.B. wegen seines bedrohlichen Inhalts — von seiner objektiven Verursachung ablösen und auf andere, als weniger bedrohlich empfundene, übetragen kann.

In der Sprache der Quantentheorie hat man es hier mit einer Transformation von Zuständen zu tun, die

Quelle: Thomas &

Brigitte Görnitz: Der kreative Kosmos, Spektrum-Verlag (2002), S. 330-331

und was sie quantenphysikalisch sein könnte

Man versteht darunter die Tatsache, dass der Akzent — die emotionale Bedeutung oder auch die Intensität — von Vorstellungen sich von ihnen lösen und auf andere übertragen kann, die mit den ersten durch Emotionsketten verbunden sind.

Quanteninformation kann sich unter bestimmten Bedingungen in Teile aufspalten, und diese Teile können sich als eigenständige Objekte mit anderen neu zusammenfinden und so neue Ganzheiten bilden.

Derartige Vorgänge finden auch bei einer Verschiebung statt, die sich im Unterbewusstsein abspielt, bei dem sich ein emotionaler Informationsanteil — z.B. wegen seines bedrohlichen Inhalts — von seiner objektiven Verursachung ablösen und auf andere, als weniger bedrohlich empfundene, übetragen kann.

-

So mag man sich z.B. über den Chef ärgern, schluckt diesen Ärger herunter, und wird dann am Abend daheim plötzlich über eine Reaktion der Kinder ärgerlich,

die man unter anderen Umständen kaum zur Kenntnis genommen hätte.

In der Sprache der Quantentheorie hat man es hier mit einer Transformation von Zuständen zu tun, die

- sowohl als Bewegung ( unitäre Drehungen ) im Hilbert-Raum.

- als auch als Projektionsvorgänge

- Im ersten Fall hat man es mit reiner Quanteninformation zu tun, die Veränderung von Wahrscheinlichkeiten darstellt, ohne dass hierbei etwas faktisch werden würde.

Dieser Vorgang ist reversibel und wäre ohne weiteres rückgängig zu machen.

- Der zweite Fall aber entspricht einer "Messung", bei der etwas "passiert". Sie muss nicht vollständig, sondern kann auch teilweise sein in dem Sinne, dass

nicht auf einen ganz bestimmten Zustand projeziert wird, sondern auf einen Teilraum dann immer noch möglicher Zustände.

In diesem Fall aber kann der Vorgang nicht mehr ungeschehen gemacht werden, da Projektionen ja nicht injektiv sind.

Dies kann als ein Modell für Verschiebung im psychologischen Sinne dienen.

Beitrag 0-256

Warum wohl keine umfassende physikalische Theorie zeitsymmetrisch sein kann

Können zeitinvariante physikalische Theorien vollständig sein?

Da die Physik all ihre Theorien mathematisch formuliert, ist jedes physikalisch beschriebene Geschehen eine Funktion der Zeit.

Eine der ganz wenigen nur teilweise zeitinvarianten physikalischen Theorien ist die Quantenphysik, denn:

Hieraus folgt: Würde man irgendwann eine sog. Weltformel finden — eine absolut vollständige physikalische Theorie für alles im gesamten Kosmos mögliche Geschehen — oder auch nur eine Theorie der Quantengravitation, so könnte sie nicht zeitsymmetrisch sein.

Unsere bisher genaueste Theorie des Makrokosmos ist Einsteins Allgemeine Relativitätstheorie (ART). Jede ihrer Lösungen — betrachtet als Funktion der Zeit — beschreibt mögliches kosmisches Geschehen, z.B. den gesamten Lebenslauf eines Schwarzen Lochs.

Konsequenz daraus:

Die Existenz sog. Weißer Löcher ist ebenso unwahrscheinlich wie die Existenz von Menschen, die aus dem Grab erstehen und ihr Leben rückwärts durchlaufen.

Quelle: Klaus Mainzer: Zeit — von der Urzeit zur Computerzeit, Beck'sche Reihe (1995, 2011), S. 54-55.

Klaus Mainzer, Ordinarius für Wissenschaftstheorie an der Uni Augsburg, hat Mathematik, Physik und Philosophie studiert.

Da die Physik all ihre Theorien mathematisch formuliert, ist jedes physikalisch beschriebene Geschehen eine Funktion der Zeit.

Eine der ganz wenigen nur teilweise zeitinvarianten physikalischen Theorien ist die Quantenphysik, denn:

- Die Schrödinger-Gleichung ist zeitsymmetrisch,

- der Kollaps der Wellenfunktion aber ist es nicht.

Hieraus folgt: Würde man irgendwann eine sog. Weltformel finden — eine absolut vollständige physikalische Theorie für alles im gesamten Kosmos mögliche Geschehen — oder auch nur eine Theorie der Quantengravitation, so könnte sie nicht zeitsymmetrisch sein.

Unsere bisher genaueste Theorie des Makrokosmos ist Einsteins Allgemeine Relativitätstheorie (ART). Jede ihrer Lösungen — betrachtet als Funktion der Zeit — beschreibt mögliches kosmisches Geschehen, z.B. den gesamten Lebenslauf eines Schwarzen Lochs.

- Ersetzt man in dieser Lösung L(t) die Zeitvariable t durch -t, so erhält man eine weitere Lösung der Theorie.

- Beschreibt L(t) ein Schwarzes Loch, so nennt man das durch L(-t) beschriebene Geschehen die Geschichte eines Weißen Lochs.

- Andererseits könnte L(t) aber auch die Geschichte eines Menschen beschreiben. Was aber würde dann L(-t) beschreiben?

Konsequenz daraus:

Die Existenz sog. Weißer Löcher ist ebenso unwahrscheinlich wie die Existenz von Menschen, die aus dem Grab erstehen und ihr Leben rückwärts durchlaufen.

Klaus Mainzer (1995):

Im Rahmen der relativistischen Kosmologie ist Zeit nur eine reelle Koordinate, um Ereignisse zu markieren. Die Frage, was "vor" der Anfangssingularität [ dem sog. Urknall ] war, ist mathematisch nicht definiert und daher sinnlos.

Auch die Rede von einer "Schöpfung" der Zeit ist mathematisch im Rahmen der Relativitätstheorie nicht definiert.

Wir müssen streng unterscheiden zwischen

- den definierten Begriffen einer physikalischen Theorie

- und weltanschaulichen Interpretationen.

Die Singularitäten von Einseins Theorie sagen die Möglichkeit sehr kleiner Gebiete der relativistischen Raumzeit voraus, in denen die Krümmung der Raumzeit — und somit auch die Gravitation — beliebig groß werden kann.

Astrophysikalisch werden dieses Singularitäten gedeutet als "Schwarze Löcher", denen der Tod eines Sterns durch Gravitationskollaps vorausging. Dazu wird eine 3-dimensionale Oberfläche angenommen — genannt "absoluter Ereignishorizont" — die alle von außen einfallenden Signale verschluckt und nichts wieder nach außen lässt.

Im Zentrum des durch den Ereignishorizon begrenten Bereichs wird die raum-zeitliche Singularität angenommen, in der die Krümmung der Raumzeit unendlich wird: Ein absoluter Endpunkt für kausale Zeitsignale.

... Da die Spezielle ebenso wie die Allgemeine Relativitätstheorie zeitsymmetrisch sind, sagt Einsteins Theorie auch das zeitlich gespiegelte Verhalten eines Schwarzen Lochs voraus, d.h. "unendlich" dichte Materipunkte, aus denen Lichtsignale explodieren (sog. Weiße Löcher).

Diese mathematische Konsequenz der zeitsymmetrischen Theorie gilt jedoch als physikalisch unwahrscheinlich und wurde von R. Penrose durch seine Ad-hoc-Hypothese "Kosmischer Zensur" ausgeschlossen.

Damit werden Erklärungsdefizite der relativistischen Kosmologie deutlich.

... In der derzeitigen Quantenmechanik und Quantenfeldtheorie ist das Problem der Zeitsymmetrie noch nicht abschließend geklärt. Einerseits sind die Quantengleichungen zeitsymmetrisch, gestatten also die Zeitumkehr. Andererseits trennen in der Gegenwart stattfindende Messvorgänge Vergangenheit und Zukunft der Systeme in einer irreversiblen Weise. Man erhofft von einer Vereinigung der Quanten- mit der Relativitätstheorie eine Klärung dieses Problems, die Vereinigung beider Theorien zu einer einheitlichen Quantengravitationstheorie ist aber noch nicht gelungen, obwohl es erste Ansätze von Hawking zu einer solchen Theorie gibt.

Quelle: Klaus Mainzer: Zeit — von der Urzeit zur Computerzeit, Beck'sche Reihe (1995, 2011), S. 54-55.

Klaus Mainzer, Ordinarius für Wissenschaftstheorie an der Uni Augsburg, hat Mathematik, Physik und Philosophie studiert.

Beitrag 0-257

Zur — oft missverstandenen — Qualität physikalischer Aussagen

Zur Qualität physikalischer Aussagen

Die Sprache der Physik ist Mathematik.

Dies bedeutet aber nicht, dass physikalische Aussagen ebenso richtig sein müssen wie – logisch fehlerfrei abgeleitete – mathematische Aussagen:

Um das zu verstehen,muss man wissen: Physikalische Aussagen sind D e u t u n g der Aussagen mathematischer Modelle im Lichte unser Realität, d.h. unserer Sinneswahrnehmung interpretiert durch unser Gehirn.

Jede solche Deutung wird irgendwie hinken — ist also stets nur mehr oder weniger grob zutreffend.

Schönes Beispiel hierfür ist Heisenbergs Aussage über unsere Atommodelle:

Die Sprache der Physik ist Mathematik.

Dies bedeutet aber nicht, dass physikalische Aussagen ebenso richtig sein müssen wie – logisch fehlerfrei abgeleitete – mathematische Aussagen:

Wolfgang Kinzel, Lehrstuhl für theoretische Physik III Universität Würzburg, schrieb:

Es gibt keine wahren Aussagen in der theoretischen Physik, sondern nur Aussagen, die eine Vielzahl von Experimenten beschreiben und ihr Ergebnis vorhersagen können.

Die Mathematik dagegen hat eine andere Zielsetzung. Sie geht von Axiomen und präzisen Definitionen aus und leitet daraus Aussagen her, die streng logisch aus den Axiomen gefolgert werden sollen. Die bewiesenen Aussagen der Mathematik sind Wahrheiten, die – falls der Beweis richtig war – nie widerlegt werden können.

Um das zu verstehen,muss man wissen: Physikalische Aussagen sind D e u t u n g der Aussagen mathematischer Modelle im Lichte unser Realität, d.h. unserer Sinneswahrnehmung interpretiert durch unser Gehirn.

Jede solche Deutung wird irgendwie hinken — ist also stets nur mehr oder weniger grob zutreffend.

Schönes Beispiel hierfür ist Heisenbergs Aussage über unsere Atommodelle:

Heisenberg (Zitat aus 1945):

Das Atom der modernen Physik kann allein nur durch eine partielle Differentialgleichung in einem abstrakten, vieldimensionalen Raum dargestellt werden. Alle seine Eigenschaften sind gefolgert; keine materiellen Eigenschaften können ihm in direkter Weise zugeschrieben werden. Das heißt: Jedes Bild des Atoms, das unsere Einbildung zu erfinden vermag, ist aus diesem Grunde mangelhaft. Ein Verständnis der atomaren Welt in jener ursprünglich sinnlichen Weise ist unmöglich.

-

Nebenbei noch:

Wie aus Heisenbergs Unbestimmtheitsrelation — angewandt auf das Paar Energie und Lebendauer virtueller Teilchen — folgt, wird in jedem noch so kleinen Zeitintervall durch ständig und überall gegebene Quantenfluktuation