Wie künstliche Intelligenz uns zur Gefahr werden kann

|

|

D i s k u s s i o n

Beitrag 0-50

Humanoide Roboter — Beispiele aus 2014

Humanoide Roboter (Status 2014)

Wie weit man bisher gekommen ist im Bemühen, Maschinen zu bauen, die

Um ein Kriterium dafür zu haben, wann eine Maschine dem Menschen gleichwertige Intelligenz aufweist, wurde von Alan Turing der nach ihm benannte Turing-Test vorgeschlagen. Dabei sollen Mensch und Maschine über ein Terminal Fragen beantworten und eine Jury soll anhand der Antworten entscheiden, wer der Mensch ist. Solange dies nicht möglich ist — so Turing — seien Maschinen nicht intelligent. Bisher hat keine Maschine diesen Test bestanden.

Erste Roboter, die jedem von uns Verantwortung abnehmen werden,

entstehen dennoch schon jetzt:

Hierzu lese man, was im Herbst 2014 Gartner schreibt:

Over the next six years, self-aware vehicles will emerge first that are increasingly also able to autonomously sense, interpret, decide, act and communicate with other automobiles, infrastructures, businesses, people and organizations. As this self-awareness matures into the next decade, vehicles will become progressively smarter and autonomous, leading to the most fundamental change in transportation, mobility and society.

By 2025, vehicle-to-vehicle and vehicle-to-infrastructure communication will be available in approximately 30 percent of passenger vehicles in use in mature markets. By 2030, autonomous-driving-capable vehicles will represent approximately 25 percent of the passenger vehicle population in use in mature markets.

Von autonomen Fahrzeugen mal abgesehen, existieren bislang nur jede Menge von Industrie-Robotern und sog. Hausroboter, die aber eher noch Spielzeugcharakter haben (man denke z.B. an die automatischen Rasenmäher, die an vergrößerte Marienkäfer aus Metall erinnern). Humanoid sollte man die nun wirklich nicht nennen. Auch was in Berichten wie Roboter lernen laufen oder Roboter lernt Ski zu fahren als humanoid bezeichnet wird, ist es höchstens seinem Aussehen, aber keineswegs seiner Denkfähigkeit nach.

Entscheidungen zu treffen, die nicht vorprogrammiert wären, sowie kreativ zu sein, wird all diesen Robotern noch lange a b s o l u t u n m ö g l i c h sein.

Dennoch könnte es schon in naher Zukunft Maschinen geben, die sich in einer ganzen Reihe von Situationen exakt so verhalten wie Lebewesen (Menschen, Tiere, Pflanzen). Wenn ihre Schöpfer ihnen dann auch noch die F o r m entsprechender Lebewesen geben, wird es schwierig werden, solche Roboter von wirklich Lebendigem zu unterscheiden.

Gutes Beispiel hierfür sind schon 2014 entwickelte künstliche Hunde, die sogar auf massive Fußtritte ebenso reagieren wie lebende Hunde. Wer sich das Video auf jener Seite genau ansieht, wird mir zustimmen: Kriege und Schlachten, in denen nur noch Roboter Menschen, Tiere, Gerät (oder andere Roboter) körperlich angreifen, könnte es noch vor 2050 durchaus geben.

Fazit also:

Reflexartige Reaktionen — auf was auch immer — werden programmierte Maschinen (Roboter)

sicherlich irgendwann ebenso perfekt beherrschen wie der Mensch.

Der Altas-Roboter (Version Feb 2016) ist weiteres gutes Beispiel hierfür. Siehe auch Version Nov 2016, Version Okt 2018.

Auch bedenkenswert [src]:

Lies auch:

Wie weit man bisher gekommen ist im Bemühen, Maschinen zu bauen, die

- aussehen wie Menschen oder wie bestimmte Tiere

- und die sich zudem noch so verhalten können — was Reaktionsvermögen, Art der Reaktion und charakteristisches Körperbeherrschung betrifft —

Um ein Kriterium dafür zu haben, wann eine Maschine dem Menschen gleichwertige Intelligenz aufweist, wurde von Alan Turing der nach ihm benannte Turing-Test vorgeschlagen. Dabei sollen Mensch und Maschine über ein Terminal Fragen beantworten und eine Jury soll anhand der Antworten entscheiden, wer der Mensch ist. Solange dies nicht möglich ist — so Turing — seien Maschinen nicht intelligent. Bisher hat keine Maschine diesen Test bestanden.

entstehen dennoch schon jetzt:

Hierzu lese man, was im Herbst 2014 Gartner schreibt:

Over the next six years, self-aware vehicles will emerge first that are increasingly also able to autonomously sense, interpret, decide, act and communicate with other automobiles, infrastructures, businesses, people and organizations. As this self-awareness matures into the next decade, vehicles will become progressively smarter and autonomous, leading to the most fundamental change in transportation, mobility and society.

By 2025, vehicle-to-vehicle and vehicle-to-infrastructure communication will be available in approximately 30 percent of passenger vehicles in use in mature markets. By 2030, autonomous-driving-capable vehicles will represent approximately 25 percent of the passenger vehicle population in use in mature markets.

Von autonomen Fahrzeugen mal abgesehen, existieren bislang nur jede Menge von Industrie-Robotern und sog. Hausroboter, die aber eher noch Spielzeugcharakter haben (man denke z.B. an die automatischen Rasenmäher, die an vergrößerte Marienkäfer aus Metall erinnern). Humanoid sollte man die nun wirklich nicht nennen. Auch was in Berichten wie Roboter lernen laufen oder Roboter lernt Ski zu fahren als humanoid bezeichnet wird, ist es höchstens seinem Aussehen, aber keineswegs seiner Denkfähigkeit nach.

Entscheidungen zu treffen, die nicht vorprogrammiert wären, sowie kreativ zu sein, wird all diesen Robotern noch lange a b s o l u t u n m ö g l i c h sein.

Dennoch könnte es schon in naher Zukunft Maschinen geben, die sich in einer ganzen Reihe von Situationen exakt so verhalten wie Lebewesen (Menschen, Tiere, Pflanzen). Wenn ihre Schöpfer ihnen dann auch noch die F o r m entsprechender Lebewesen geben, wird es schwierig werden, solche Roboter von wirklich Lebendigem zu unterscheiden.

Gutes Beispiel hierfür sind schon 2014 entwickelte künstliche Hunde, die sogar auf massive Fußtritte ebenso reagieren wie lebende Hunde. Wer sich das Video auf jener Seite genau ansieht, wird mir zustimmen: Kriege und Schlachten, in denen nur noch Roboter Menschen, Tiere, Gerät (oder andere Roboter) körperlich angreifen, könnte es noch vor 2050 durchaus geben.

Fazit also:

sicherlich irgendwann ebenso perfekt beherrschen wie der Mensch.

Der Altas-Roboter (Version Feb 2016) ist weiteres gutes Beispiel hierfür. Siehe auch Version Nov 2016, Version Okt 2018.

Auch bedenkenswert [src]:

We already have nonhuman autonomous entities operating in our society with the legal rights of humans. These entities — corporations — act to fulfill

their missions without love or care for human beings. Corporations are sociopaths, and they’ve done great harm, but they’ve also been a great force for

good in the world, competing in the capitalist arena by providing products and services, and (for the most part) obeying laws.

Lies auch:

- Warum Roboter und KI nicht wissen können, was ethisches Verhalten darstellt.

- China's robot density - measured by the number of robots per 10,000 manufacturing workers - was 36 in 2014, compared with 478 in the Republic of Korea,

314 in Japan and the world average of 66, according to the International Federation of Robotics (IFR).

- UN Report: Robots Will Replace Two-Thirds of All Workers in the Developing World

- Mensch und Roboter – erste Ansätze, sie miteinander zu verschmelzen

- Und doch werden Roboter stets nur Maschine sein: Werkzeuge, mittels derer wir Ziele erreichen, die ansonsten unerreichbar wären.

- KI der kommenden Jahrzente realistisch beurteilt: kurz und ausführlich.

Beitrag 0-51

Künstliche Gehirne — seit 2014 werden sie Realität

Künstliche Gehirne

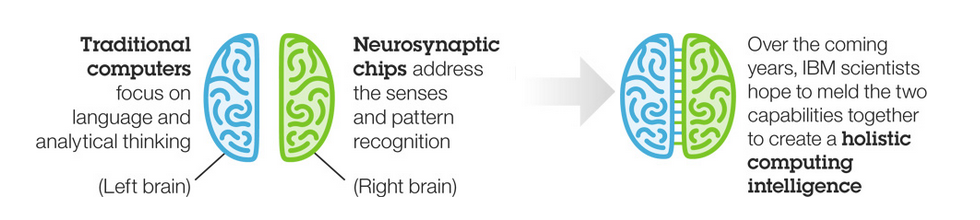

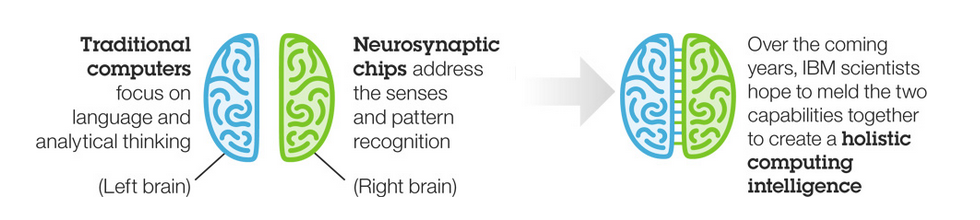

Auf dem Weg hin zu einer Nachbildung des menschlichen Gehirn durch Chips, die dem Prozessor eines Computers entsprechen, scheint IBM in 2014 einen großen Schreitt getan zu haben:

Der Chip TrueNorth, den IBM in der Wissenschaftszeitschrift Science genauer beschreibt, besteht aus 5.4 Milliarden Transistoren, also etwa vier Mal so viele wie ein typischer PC-Prozessor.

Damit hat IBM etwas realisiert, das 1 Mio Neuronen und 256 Mio Synapsen des menschlichen Gehirns entspricht.

Diese künstlichen Neuronen und Synapsen sind organisiert in 4096 Kernen, von denen jeder Daten speichern, verarbeiten und zu jedem anderen übertragen kann. Sie arbeiten ereignisgetrieben, was u.A. bewirkt, dass die einzelnen Kerne nur in Betrieb sind, wenn sie tatsächlich gebraucht werden. Der Stromverbrauch des neuartigen Chips reduziert sich dadurch auf gerade einmal 20 Milliwatt pro Quadratzentimeter (was deutlich weniger ist als die derzeit mittlerweile üblichen 50 bis 100 Watt bei einer herkömmlichen CPU).

Und genau hierin könnte das Zukunftspotenzial radikal neuer Chip-Architekturen wie der von "TrueNorth" liegen, denn Leistungsaufnahme ist die heute entscheidende Beschränkung bei der Weiterentwicklung von Hochleistungsrechnern. Dieser Chip, so glaubt man, sei ein Hinweis darauf, dass wir an der Schwelle einer fundamentalen Veränderung gängiger CPU-Architektur stehen.

Dharmendra Modha — unter dessen Leitung das neue Design entstand — betont, dass TrueNorth kein Ersatz für traditionelle Computer sein soll, sie also n i c h t ersetzen wird. Die besonderen Fähigkeiten des Hirnhalbleiters lägen in Bereichen wie der Mustererkennung und der Klassifizierung von Objekten.

An erfolgreiche Kommerzialisierung glaubt IBM aber sehr wohl. Man spreche bereits mit potenziellen Partnern über Möglichkeiten der Vermarktung und habe auch schon mehrere TrueNorth Chips miteinander verbunden, um Varianten denkbaren System Designs zu testen.

Nebenbei: IBM ist bei weitem nicht das einzige Unternehmen, dass in an "neuromorphen" Chips forscht — Intel und Qualcomm etwa können ebenfalls schon eigenes Design vorweisen. Bevor man solche Chips aber in vermarktbaren Geräten einsetzen kann, wird man Algorithmen, Programmierer und Programmiersprachen benötigen, die den neuen Möglichkeiten des Verarbeitens von Daten angemessen sind. Wenigstens in diesem Bereich könnte die IBM, die für ihren TrueNorth eine spezielle Programmiersprache samt flankierender Tools entwickelt hat, der Konkurrenz voraus sein. Die Technik sei "viel näher daran benutzbar zu sein als eine Reihe dazu konkurrierender neuromorpher System, die andere entwickelt haben" (so sagte Cornell-Professor Rajit Manohar).

Und tatsächlich: The new chip, so schreibt IBM, is a component of a complete end-to-end vertically integrated ecosystem spanning a chip simulator, neuroscience data, supercomputing, neuron specification, programming paradigm, algorithms and applications, and prototype design models. The ecosystem supports all aspects of the programming cycle from design through development, debugging, and deployment. To bring forth this fundamentally different technological capability to society, IBM has designed a novel teaching curriculum for universities, customers, partners, and IBM employees.

Quellen dieser Information: Man lese auch:

Auf dem Weg hin zu einer Nachbildung des menschlichen Gehirn durch Chips, die dem Prozessor eines Computers entsprechen, scheint IBM in 2014 einen großen Schreitt getan zu haben:

Der Chip TrueNorth, den IBM in der Wissenschaftszeitschrift Science genauer beschreibt, besteht aus 5.4 Milliarden Transistoren, also etwa vier Mal so viele wie ein typischer PC-Prozessor.

Damit hat IBM etwas realisiert, das 1 Mio Neuronen und 256 Mio Synapsen des menschlichen Gehirns entspricht.

Diese künstlichen Neuronen und Synapsen sind organisiert in 4096 Kernen, von denen jeder Daten speichern, verarbeiten und zu jedem anderen übertragen kann. Sie arbeiten ereignisgetrieben, was u.A. bewirkt, dass die einzelnen Kerne nur in Betrieb sind, wenn sie tatsächlich gebraucht werden. Der Stromverbrauch des neuartigen Chips reduziert sich dadurch auf gerade einmal 20 Milliwatt pro Quadratzentimeter (was deutlich weniger ist als die derzeit mittlerweile üblichen 50 bis 100 Watt bei einer herkömmlichen CPU).

Und genau hierin könnte das Zukunftspotenzial radikal neuer Chip-Architekturen wie der von "TrueNorth" liegen, denn Leistungsaufnahme ist die heute entscheidende Beschränkung bei der Weiterentwicklung von Hochleistungsrechnern. Dieser Chip, so glaubt man, sei ein Hinweis darauf, dass wir an der Schwelle einer fundamentalen Veränderung gängiger CPU-Architektur stehen.

Dharmendra Modha — unter dessen Leitung das neue Design entstand — betont, dass TrueNorth kein Ersatz für traditionelle Computer sein soll, sie also n i c h t ersetzen wird. Die besonderen Fähigkeiten des Hirnhalbleiters lägen in Bereichen wie der Mustererkennung und der Klassifizierung von Objekten.

An erfolgreiche Kommerzialisierung glaubt IBM aber sehr wohl. Man spreche bereits mit potenziellen Partnern über Möglichkeiten der Vermarktung und habe auch schon mehrere TrueNorth Chips miteinander verbunden, um Varianten denkbaren System Designs zu testen.

Nebenbei: IBM ist bei weitem nicht das einzige Unternehmen, dass in an "neuromorphen" Chips forscht — Intel und Qualcomm etwa können ebenfalls schon eigenes Design vorweisen. Bevor man solche Chips aber in vermarktbaren Geräten einsetzen kann, wird man Algorithmen, Programmierer und Programmiersprachen benötigen, die den neuen Möglichkeiten des Verarbeitens von Daten angemessen sind. Wenigstens in diesem Bereich könnte die IBM, die für ihren TrueNorth eine spezielle Programmiersprache samt flankierender Tools entwickelt hat, der Konkurrenz voraus sein. Die Technik sei "viel näher daran benutzbar zu sein als eine Reihe dazu konkurrierender neuromorpher System, die andere entwickelt haben" (so sagte Cornell-Professor Rajit Manohar).

Und tatsächlich: The new chip, so schreibt IBM, is a component of a complete end-to-end vertically integrated ecosystem spanning a chip simulator, neuroscience data, supercomputing, neuron specification, programming paradigm, algorithms and applications, and prototype design models. The ecosystem supports all aspects of the programming cycle from design through development, debugging, and deployment. To bring forth this fundamentally different technological capability to society, IBM has designed a novel teaching curriculum for universities, customers, partners, and IBM employees.

Quellen dieser Information: Man lese auch:

- KI von heute (2017) ist kaum mehr als Mustererkennung:

Zitat: If you look at where we are in AI, I would say it’s the great triumph of pattern recognition. It is very task-focused, it lacks contextual awareness, and it lacks the kind of flexible learning that humans have.

- 15 Mythen über die Fähigkeiten Künstlicher Intelligenz (2017)

- So manche KI — und so mancher Roboter — sind nicht recht viel mehr als eine Know-how-Datenbank (2017: Erster Roboter besteht Arzt-Examen)

- Brainlike Computers, Learning From Experience, Dez 2013:

Computers have entered the age when they are able to learn from their own mistakes, a development that is about to turn the digital world on its head.

- KI-basierte Waffensysteme in Form deutlich zu selbständig entscheidender Roboter

werden in wenigen Jahren Wirklichkeit sein

und dann das Potential haben, die Gattung Mensch zu zerstören. Siehe hierzu: Open letter from AI & Robotics Researchers (2015).

- Kurzweils Prognose: Menschliche Gehirne werden noch vor 2050 durch

KI ergänzbar sein.

Lies vor allem den letzten Teil des Artikels - er relativiert den ersten und präzisiert, wie er gemeint ist.

Lies dazu auch:- Kernel's Quest to Enhance Human Intelligence (2016)

- Elon Musk investiert schon in diese Richtung (2017),

Musk plant ...

- Ist nicht auch jede bolologische Zelle schon intelligent?

- Kernel's Quest to Enhance Human Intelligence (2016)

- KI, die Fake News erzeugen kann

Beitrag 0-225

KI (bzw. AI) — was man wirklich darunter versteht

Künstliche Intelligenz (KI) — was genau ist das?

Unter künstlicher Intelligenz (KI) — englisch: Artificial Intelligence (AI) — versteht man eine breite Palette von Methoden, Algorithmen und Technologien, mit denen es zunehmend besser gelingt, Software und Hardware so reagieren zu lassen, dass sie auf Außenstehende wie durch menschliche Intelligenz gesteuert wirkt.

Gartner prophezeit (2016), dass schon etwa 2020 rund die Hälfte aller analytischen Interaktionen durch KI gesteuert sein werden. Dabei werde sich die natürlichsprachliche Interaktion mit Maschinen immer mehr durchsetzen. Schon 2016 interagierten viele Menschen — ohne es zu wissen — über KI-Software. Das treffe z.B. für alle zu, die IBMs Watson, IPSofts Amelia, Apples Siri, Microsofts Cortana oder den Google Assistant nutzten.

Bald werden recht billige Rechner so viel Rechenleistung bieten können wie ein menschliches Gehirn. Das ist abzusehen, denn derzeit steigt die Rechenleistung pro Euro alle 10 Jahre um etwa um den Faktor 100. Falls dieser Trend anhält, werden wir schon etwa 2070 billige Rechner haben, deren Rechenleistung jeweils einzeln der aller lebenden Menschen entsprechen wird. Und die Entwicklung wird auch dann nicht stehen bleiben, so dass es von solchen Rechnern recht bald nicht nur ein paar geben wird, sondern Milliarden und Abermilliarden.

So jedenfalls sagt der KI-Experte Prof. Jürgen Schmidhuber, Scientific Director am Swiss AI Lab IDSIA.

Eines der interessantesten Forschungsergebnisse Jürgen Schmidhubers ist ein Papier, welches mit folgender Aussage beginnt:

Hiermit ist klar, dass KI existieren kann, die sich selbst ständig verbessert — einfach dadurch, dass sie möglich Varianten ihrer selbst generiert und erkennen kann, wann eine von ihnen (als KI) mächtiger ist als die derzeit genutzte.

Ganz offensichtlich werden sich auf diesem Wege verbesserte Varianten der KI umso schneller finden lassen, je mächtiger die Hardware ist, die man nutzt. Die Geschwindigkeit, mit der KI sich irgendwann selbst verbessern wird, könnte somit die Geschwindigkeit, mit der der Mensch immer pfiffigere Software ersinnen kann, schon bald übersteigen und weit hinter sich lassen.

Lies auch:

Unter künstlicher Intelligenz (KI) — englisch: Artificial Intelligence (AI) — versteht man eine breite Palette von Methoden, Algorithmen und Technologien, mit denen es zunehmend besser gelingt, Software und Hardware so reagieren zu lassen, dass sie auf Außenstehende wie durch menschliche Intelligenz gesteuert wirkt.

Gartner prophezeit (2016), dass schon etwa 2020 rund die Hälfte aller analytischen Interaktionen durch KI gesteuert sein werden. Dabei werde sich die natürlichsprachliche Interaktion mit Maschinen immer mehr durchsetzen. Schon 2016 interagierten viele Menschen — ohne es zu wissen — über KI-Software. Das treffe z.B. für alle zu, die IBMs Watson, IPSofts Amelia, Apples Siri, Microsofts Cortana oder den Google Assistant nutzten.

Bald werden recht billige Rechner so viel Rechenleistung bieten können wie ein menschliches Gehirn. Das ist abzusehen, denn derzeit steigt die Rechenleistung pro Euro alle 10 Jahre um etwa um den Faktor 100. Falls dieser Trend anhält, werden wir schon etwa 2070 billige Rechner haben, deren Rechenleistung jeweils einzeln der aller lebenden Menschen entsprechen wird. Und die Entwicklung wird auch dann nicht stehen bleiben, so dass es von solchen Rechnern recht bald nicht nur ein paar geben wird, sondern Milliarden und Abermilliarden.

So jedenfalls sagt der KI-Experte Prof. Jürgen Schmidhuber, Scientific Director am Swiss AI Lab IDSIA.

Eines der interessantesten Forschungsergebnisse Jürgen Schmidhubers ist ein Papier, welches mit folgender Aussage beginnt:

-

We present the first class of mathematically rigorous, general, fully self-referential, selfimproving,

optimally efficient problem solvers. Inspired by Kurt Gödel’s celebrated self-referential

formulas (1931), such a problem solver rewrites any part of its own code as soon

as it has found a proof that the rewrite is useful, where the problem-dependent utility function

and the hardware and the entire initial code are described by axioms encoded in an initial

proof searcher which is also part of the initial code.

The searcher systematically and in an asymptotically optimally efficient way tests computable proof techniques (programs whose outputs are proofs) until it finds a provably useful, computable self-rewrite.

Hiermit ist klar, dass KI existieren kann, die sich selbst ständig verbessert — einfach dadurch, dass sie möglich Varianten ihrer selbst generiert und erkennen kann, wann eine von ihnen (als KI) mächtiger ist als die derzeit genutzte.

Ganz offensichtlich werden sich auf diesem Wege verbesserte Varianten der KI umso schneller finden lassen, je mächtiger die Hardware ist, die man nutzt. Die Geschwindigkeit, mit der KI sich irgendwann selbst verbessern wird, könnte somit die Geschwindigkeit, mit der der Mensch immer pfiffigere Software ersinnen kann, schon bald übersteigen und weit hinter sich lassen.

Lies auch:

- Wie sich Mensch und KI unterscheiden (2009)

- Interview mit Jürgen Schmidhuber (2016): » Der Mensch wird keine dominante Rolle mehr spielen «

Interview mit Jürgen Schmidhuber (2017): Seine Vorstellung von zukünftiger KI

- Künstliche Intelligenz — Wie weit sind wir wirklich? (2015), siehe auch

ein erstaunliches Beispiel aus 2017:

Previous versions of AlphaGo initially trained on thousands of human amateur and professional games to learn how to play Go. AlphaGo Zero skips this step and learns to play simply by playing games against itself, starting from completely random play. In doing so, it quickly surpassed human level of play and defeated the previously published champion-defeating version of AlphaGo by 100 games to 0. Lies Bericht und Wertung.

- When will AI Exceed Human Performance? — Evidence from AI Experts (2017)

- Gartners Vorhersage (aus 2017 zu Industrie 4.0)

- Google's KI (2018)

- Chinas KI

- Putins Vorhersage (aus 2017 über das Wettrüsten

hin zu autonomen, KI-gesteuerten Waffensystemen):

» Artificial intelligence is the future, not only for Russia but for all humankind.

Whoever becomes the leader in this sphere will become the ruler of the world. «

Die Herrscher in Russland und China sind sich dessen voll bewusst. Die USA — so scheint es heute — könnten den Anschluss verpassen. Und das scheint wiederum selbst Putin Angst zu machen. Warum sonst würde er sich so klar ausdrücken?

Russlands (und der ganzen Welt) derzeit flexibelste, kaum mehr abfangbare Langstreckenrakete (Jan 2020 in Dienst gestellt)

Sie bewegt sich mit 27-facher Schallgeschwindigkeit.

- Elon Musk on Figther Jets compared to Drones (2020) und die enormen Kosten einer misslungenen Jet-Entwicklung

Beitrag 0-88

Wie Maschinen lernen, auf menschliche Gedanken zu reagieren

Schon bald werden auch Gedanken Maschinen steuern

Hier ein erstes Beispiel:

Wissenschaftler der TU München und der TU Berlin arbeiten an einem Projekt, mit dem man Wege finden möchte, Flugzeuge allein nur über Gedanken zu steuern. Der Projektleiter Tom Fricke berichtet:

Einen ersten Durchbruch hat man schon erzielt:

Wie das erreicht wurde:

Der nächste notwendige Schritt im Projekt:

Quelle: Das Science Magazin Faszination Forschung der TU München, Seite 76-77 in Edition 15 ( Dec 2014 ).

Hier ein erstes Beispiel:

Wissenschaftler der TU München und der TU Berlin arbeiten an einem Projekt, mit dem man Wege finden möchte, Flugzeuge allein nur über Gedanken zu steuern. Der Projektleiter Tom Fricke berichtet:

Einen ersten Durchbruch hat man schon erzielt:

- The scientists succeded in demonstrating that brain-controlled flight is indeed possible — with amazing precision: Seven subjects [persons] took part in the flight simulator tests. They had varying

levels of flight experience, including one person without any practical cockpit experience. The accuracy with which the test subjects stayed on course by merely t h i n k i n g commands would have sufficed, in part,

to fulfill the requirements of a flying license test. "One of the subjects was able to follow 8 out of 10 target headings with a deviation of only 10 degrees", reported Fricke.

Several of the objects also managed the landing approach under poor visibility.

One test pilot even landed within only a few meters of the centerline.

Wie das erreicht wurde:

-

Electrical potentials are converted into control commands. In order for humans and machines to communicate, brain waves of the pilots are measured using electroencephalography (EEG) electrodes

connected to a cap. An algorithm developed by the scientists at TU Berlin allows the program to decipher electrical potentials and convert them into useful control commands.

Only the very clearly defined electrical brain impulses required for control are recognized by the brain computer interface.

Der nächste notwendige Schritt im Projekt:

-

The TUM scientists are now focussing in particular on the question of how the requirements for the control system and flight dynamics need to be altered

to accomodate the new control method. Normally, pilots feel resistance in steering and must exert significant force when the loads induced on the aircraft become too large.

This feedback is missing when using brain control. The reasearchers are thus looking for alternative methods of feedback to signal when the plane's capabilities are pushed too hard, for example.

Quelle: Das Science Magazin Faszination Forschung der TU München, Seite 76-77 in Edition 15 ( Dec 2014 ).

Beitrag 0-102

Künstliche Intelligenz (KI) kann nur bewusstes, emotionsloses Denken automatisieren

KI hat kein Bewusstsein

und hat schon gar kein Unterbewusstsein

Alle bisher ins Leben gerufene KI ist einfach nur ein Mechanismus, der — heute immer noch in streng deterministischer Weise — auf eine genau definierte Menge von Signalen reagiert, indem er sie nach fest vorgegebenen Regeln in Reaktion umsetzt.

Wie weit solche KI von menschlicher Intelligenz entfernt ist, macht klar, was Ulrich Warnke (Universitätsdozent und Gründungsmitglied der Gesellschaft für Technische Biologie und Bionik e.V.) in seinem Buch Quantenphilosophie schreibt:

Halten wir also fest:

Manche Leute denken, dass sich über per Computer simulierte neuronale Netze dennoch irgendwann auch wirkliche Intelligenz entwickeln könnte. Welche Argumente dafür bzw. dagegen sprechen, ist kurz angerissen auf Seite Warum ein Computer (oder Roboter) wohl doch niemals wird Geist entwickeln können.

Lies auch: Klaus Heinerth (1998): Können Computer Bewusstsein entwickeln?

und hat schon gar kein Unterbewusstsein

Alle bisher ins Leben gerufene KI ist einfach nur ein Mechanismus, der — heute immer noch in streng deterministischer Weise — auf eine genau definierte Menge von Signalen reagiert, indem er sie nach fest vorgegebenen Regeln in Reaktion umsetzt.

Wie weit solche KI von menschlicher Intelligenz entfernt ist, macht klar, was Ulrich Warnke (Universitätsdozent und Gründungsmitglied der Gesellschaft für Technische Biologie und Bionik e.V.) in seinem Buch Quantenphilosophie schreibt:

Ulrich Warnke (2011):

Bewusstsein ist die treibende Kraft und die Fähigkeit eines Wesens,

Information als solche zu erkennen und zielgerichtet — intelligent also — zu verarbeiten.

Bewusstsein ist demnach ein P r o z e s s . Aber hätte nach dieser Definition nicht jeder Computer ein Bewusstsein? Nein, keineswegs, denn:

Allein nur das Bewusstein zu betrachten, bedeutet, die Rolle des Unterbewusstseins nicht ausreichend zu würdigen.

Das Unterbewusstsein des Menschen befähigt ihn,

Information auch über Gefühle zu empfangen und intelligent zu verarbeiten:

Deutlich über 95% aller in einem Menschen stattfindender Intformationsverarbeitung wird vom Unterbewusstsein erbracht. Es nimmt etwa 109 Informationseinheiten pro Sekunde auf. Kaum 1% davon gelangt über die Bewusstheitsschwelle.

Wichtiger noch: Unsere über das Bewusstsein gesteuerte Vernunft hat keine Kontrolle über die automatisch ablaufenden Gefühlsaktivitäten des Unterbewusstseins, und das ist gut so, denn die Automatik des Unterbewusstseins reagiert hochintelligent und um Größenordnungen schneller als unser bewusst arbeitender Verstand. Dies dient unserem Schutz, und zudem bekommen wir so die Möglichkeit, uns in unserem bewussten Denken auf das jeweils Wesentliche zu konzentrieren, so dass wir nicht gehemmt werden durch einen Zwang, alle uns ständig überflutende Information komplett verarbeiten zu müssen: Wir können in eigener Entscheidung Prioritäten setzen.

KI oder ein Computer aber haben kein Unterbewusstsein. Und das ist der wichtigste Grund dafür, dass sie keine Gefühle kennen, also auch nur emotionslos arbeiten können.

Und so gilt: Kein geistig gesunder Mensch wird jemals durch KI voll ersetzbar sein.

Halten wir also fest:

- KI kennt keine Emotionen, keine Intuition, kein Gewissen; sie kennt nur Regeln und ist gezwungen, sie anzuwenden.

- Die Sinnhaftigkeit einer Regel in Frage zu stellen, kommt ihr gar nicht erst in den Sinn.

- Sie versagt, wo keine der ihr mitgegebenen Regeln anwendbar ist.

Manche Leute denken, dass sich über per Computer simulierte neuronale Netze dennoch irgendwann auch wirkliche Intelligenz entwickeln könnte. Welche Argumente dafür bzw. dagegen sprechen, ist kurz angerissen auf Seite Warum ein Computer (oder Roboter) wohl doch niemals wird Geist entwickeln können.

Lies auch: Klaus Heinerth (1998): Können Computer Bewusstsein entwickeln?

Beitrag 0-409

Warum KI nicht intelligent sein kann

Warum KI nicht intelligent sein kann

KI ist nichts anderes als eine geschickte Kombination menschlicher Einsicht mit der hohen Speicherkapazität und dem schnellem Reaktionsvermögen moderner elektronischer Rechner.

Konsequenz daraus: KI kann weit schneller "denken" als menschliche Gehirne, wird aber nie intelligent sein. Sie reagiert auf jede Situationen stets nur so, wie ein durch ihre Programmierer geschaffenes Regelsystem es ihr vorschreibt. Sie hat keinerlei eigenen Willen.

KI ist nichts anderes als eine geschickte Kombination menschlicher Einsicht mit der hohen Speicherkapazität und dem schnellem Reaktionsvermögen moderner elektronischer Rechner.

Konsequenz daraus: KI kann weit schneller "denken" als menschliche Gehirne, wird aber nie intelligent sein. Sie reagiert auf jede Situationen stets nur so, wie ein durch ihre Programmierer geschaffenes Regelsystem es ihr vorschreibt. Sie hat keinerlei eigenen Willen.

Beitrag 0-204

Stärken, Schwächen und das wahre Wesen aller KI

Stärken, Schwächen und

das wahre Wesen künstlicher Intelligenz

Die Schwäche künstlicher Intelligenz (KI) — und das mag überraschen — liegt weniger in Bereichen, in denen sich der menschliche Geist am eindrucksvollsten entfaltet, wie etwa dort, wo menschliche Experten uns mit ihrem Fachwissen beeindrucken oder über komplizierte Überlegungen zu eindrucksvollen Resultaten gelangen.

Die Schwäche aller KI liegt vielmehr dort, wo es um "gesunden Menschenverstand" geht und wo wir auf unerwartete Situationen schnell und instinktiv richtig reagieren.

Dass KI überhaupt keine Möglichkeit hat, über sich selbst zu bestimmen und aus eigenem Urteil heraus zu entscheiden, wird klar, wenn man weiß, dass KI — einmal aktiviert — nichts anderes tut, als ein und denselben Code p immer wieder aufzurufen:

( Output, Z, E ) = p( Input, Z, E )

Hierin bezeichnet

Wie zutreffend die durch die KI gesammelte und selbständig erweiterte Erkenntnis E und wie sinnvoll die als Output abgesetzten Signale sein werden, hängt allein davon ab, wie durchdacht und fehlerfrei der das Programm p realisierende Code arbeitet — ihn aber haben bisher immer noch Menschen (Programmierer und KI-Entwickler) ersonnen.

Die einzige Stärke jeder KI liegt deswegen nur darin, dass sie als Software — wenn auf geeignete Rechner gesetzt —

Obgleich KI weder denken noch fühlen kann, kann sie dennoch Denkarbeit ersetzen:

Und so wird KI uns Menschen selbst beim Denken schon bald in vieler Hinsicht — doch niemals in jeder Hinsicht — weit überlegen sein.

Gefühle aber — und z.B. auch Ehrgeiz — werden ihr für immer fremd bleiben. Nicht einmal den Sinn dieser Worte wird sie verstehen.

Lies auch:

Der KI-Experte Schmidhuber scheint mir nicht in jedem Punkt recht zu haben. Er hat aber ganz sicher recht, wenn er sagt, dass es den Menschen schon in wenigen Jahrzehnten schwer fallen könnte, KI-gesteuerte Mechanismen (Roboter oder Prozesse), wenn einmal aktiviert, noch zu kontrollieren.

das wahre Wesen künstlicher Intelligenz

Die Schwäche künstlicher Intelligenz (KI) — und das mag überraschen — liegt weniger in Bereichen, in denen sich der menschliche Geist am eindrucksvollsten entfaltet, wie etwa dort, wo menschliche Experten uns mit ihrem Fachwissen beeindrucken oder über komplizierte Überlegungen zu eindrucksvollen Resultaten gelangen.

Die Schwäche aller KI liegt vielmehr dort, wo es um "gesunden Menschenverstand" geht und wo wir auf unerwartete Situationen schnell und instinktiv richtig reagieren.

Dass KI überhaupt keine Möglichkeit hat, über sich selbst zu bestimmen und aus eigenem Urteil heraus zu entscheiden, wird klar, wenn man weiß, dass KI — einmal aktiviert — nichts anderes tut, als ein und denselben Code p immer wieder aufzurufen:

Hierin bezeichnet

- Z das Bild, das die KI sich macht

- von sich selbst,

- von der Umgebung, in der sie arbeitet,

- und vom Zustand, in dem sie selbst und jene Umgebung sich befinden.

- E ist die Menge aller Erkenntnis, die man der KI per Input übermittelt oder die sie sich selbst schon erarbeitet hat.

- Output schließlich ist die Folge aller Signale, die der Aufruf von p in die Umgebung hinein abgesetzt.

Wie zutreffend die durch die KI gesammelte und selbständig erweiterte Erkenntnis E und wie sinnvoll die als Output abgesetzten Signale sein werden, hängt allein davon ab, wie durchdacht und fehlerfrei der das Programm p realisierende Code arbeitet — ihn aber haben bisher immer noch Menschen (Programmierer und KI-Entwickler) ersonnen.

Die einzige Stärke jeder KI liegt deswegen nur darin, dass sie als Software — wenn auf geeignete Rechner gesetzt —

- um heute schon bis zu 10 Größenordnungen schneller arbeitet als der Mensch

- deutlich weniger Kosten verursacht

- und — was sehr wichtig ist — keinerlei Flüchtigkeitsfehler macht (da sie ja nicht ermüdet).

Obgleich KI weder denken noch fühlen kann, kann sie dennoch Denkarbeit ersetzen:

Und so wird KI uns Menschen selbst beim Denken schon bald in vieler Hinsicht — doch niemals in jeder Hinsicht — weit überlegen sein.

Gefühle aber — und z.B. auch Ehrgeiz — werden ihr für immer fremd bleiben. Nicht einmal den Sinn dieser Worte wird sie verstehen.

Lies auch:

- Experten glauben: 3 von 4 Jobs in Behörden könnten schon 2030 durch KI ersetzbar sein

- Keineswegs nur Handwerker werden durch Roboter ersetzbar

- Wohl notwendige gesellschaftliche Konsequenz

- Welche Folgen werden sich durch immer mehr KI-basierte Lösungen ergeben?

- Düstere Aussichten ... (nur S. 44-45 zu lesen reicht)

- Optimisten denken ...

- Die Wahrheit wird wohl irgendwo dazwischen liegen ...

- Düstere Aussichten ... (nur S. 44-45 zu lesen reicht)

Der KI-Experte Schmidhuber scheint mir nicht in jedem Punkt recht zu haben. Er hat aber ganz sicher recht, wenn er sagt, dass es den Menschen schon in wenigen Jahrzehnten schwer fallen könnte, KI-gesteuerte Mechanismen (Roboter oder Prozesse), wenn einmal aktiviert, noch zu kontrollieren.

Beitrag 0-118

Gibt es Wege, besonders intelligente Nachfahren zu haben?

Lässt sich Superintelligenz durch Züchtung erreichen?

Angeblich besteht unter Wissenschaftlern Konsens darüber, dass Intelligenz

Der beste Weg, intelligente Nachkommen zu erhalten, besteht deswegen wohl darin, einen Partner zu wählen, der intelligenter ist als man selbst.

Was könnte sich ergeben haben, nachdem man diese Methode über z.B. 100 Generationen hinweg gezielt angewandt hätte?

Die offensichtliche Antwort: Im Bevölkerungsdurchschnitt sicher rein gar nichts, denn wenn einer der Partner intelligenter ist als der andere, wird für den anderen das Umgekehrte gelten.

Letztlich also sorgt die Natur selbst dafür, dass der Mensch sich nicht selbst super-intelligent machen kann. Will er also Super-Intelligenz züchten, müsste er lernen, sie als KI zu entwickeln.

Angeblich besteht unter Wissenschaftlern Konsens darüber, dass Intelligenz

- zu etwa 60% durchs Erbgut bedingt

- und nur zu 40% auf Umwelteinflüsse zurückführbar ist.

Der beste Weg, intelligente Nachkommen zu erhalten, besteht deswegen wohl darin, einen Partner zu wählen, der intelligenter ist als man selbst.

Was könnte sich ergeben haben, nachdem man diese Methode über z.B. 100 Generationen hinweg gezielt angewandt hätte?

Die offensichtliche Antwort: Im Bevölkerungsdurchschnitt sicher rein gar nichts, denn wenn einer der Partner intelligenter ist als der andere, wird für den anderen das Umgekehrte gelten.

Letztlich also sorgt die Natur selbst dafür, dass der Mensch sich nicht selbst super-intelligent machen kann. Will er also Super-Intelligenz züchten, müsste er lernen, sie als KI zu entwickeln.

Beitrag 0-143

Schon bald wird KI derzeit noch hochbezahlte Denker ersetzen

Schon bald wird KI auch hochbezahlte Denker ersetzen

Hier ein erstes Beispiel:

Hier ein erstes Beispiel:

- KI ersetzt Wall-Street-Analysten (2015)

Dennoch ist festzuhalten:

- KI wird menschliches Denken stets nur t e i l w e i s e (als

rein f o r m a l e s Denken) ersetzen können.

Die nicht-mechanistische Natur des Geistes, die aus dem 1. Gödelschen Unvollständigkeitssatz folgt, sollte unser Denken auf nicht-mechanistische physikalische Gesetze lenken, wie sie etwa in der Quantenmechanik aufgestellt sind. Damit werden auch jene Aspekte des Geistes berücksichtigt, die nicht berechenbar sind. [Roger Penrose]

Denn: Wir Menschen wissen mehr, als was sich logisch ableiten lässt. Es gibt mehr, als Wissenschaften beschreiben können.

Beitrag 0-232

Wie funktionieren: Computer, KI und künstliche neuronale Netze (knN)?

Wie funktionieren:

Computer, KI und künstliche neuronale Netze (knN)

Jeden eingeschalteten Computer kann man sich vorstellen als

Wie man sieht, kann s(0,N) aufgefasst werden als eine Funktion, welche jedem Schalterzustand s(0,m) mit N ≤ m < M einen nächsten Speicherzustand s(0,M) zuordnet.

Jeder Computer ist so gebaut, dass neben den Konstanten N und M eine weitere Konstante T existiert mit N < T < M derart, dass immer dann, wenn s(0,N) ein Befehl ist, der den dann vorliegenden Speicherzustand s(0,M) in sich selbst überführt — der Computer also nichts mehr tut — der Abschnitt s(N,T) des Speicherzustandes s(0,M) durch Input von außen abgeändert werden kann. Typisches Beispiel wäre ein Signal, das von Tastatur oder Maus kommt.

Rein theoretisch spielt es keine Rolle, wie groß die Differenz T-N ist. Heutige Computer haben meist 64-Bit Bandbreite, so dass dann T-N = 64 ist.

Wie die eben gegebene Erklärung der Arbeitsweise jeden Computers zeigt, kennt er genau 2N Befehle. Jeder kann als Abbildung der Menge aller denkbaren Speicherzustände s(0,M) in sich aufgefasst werden. In welcher Reihenfolge sie ständig neu zur Anwendung kommen, bestimmen von außen nach S(N,T) geschriebene Eingaben.

Solche Eingaben können darstellen:

Sinnvolle Programme zu schreiben ist schwierig und zeitraubend. Hier nun setzt KI (sog. künstliche Intelligenz) an:

Man versteht darunter Programme, die besonders hohen Wirkungsgrad haben — mit relativ wenig Code also relativ viel erreichen.

Eine besonders einfache Form von KI ist bekannt geworden unter dem Stichwort Expertensysteme. Jedes Expertensystem ist einfach nur ein Programm P, welches auf eine gegebene Menge D von Daten immer und immer wieder eine durch ein Regelsystem R definierte Funktion F anwendet, welche die Menge der Daten sinnvoll vergrößert. Aus gegebenen Wissen D entsteht so schrittweise immer umfangreicheres Wissen bis hin zu dem Punkt, an dem es dann schließlich auch die Antwort auf eine vom Anwender vorher gestellte Frage beinhaltet.

Da nicht von vorn herein gesagt werden kann, wie oft die Funktion F den Datenbestand vergrößern muss bis die gesuchte Antwort endlich gefunden wir, ist klar: Expertensysteme sind umso mächtiger, je mächtiger der Computer ist, auf dem sie arbeiten, d.h. je kürzer seine Taktrate ist und je größer sein Speicher.

Über Expertensysteme hinaus gibt es noch einen zweiten, inzwischen schon weit entwickelten Lösungsansatz, den Wirkungsgrad von Programmcode zu erhöhen: Sog. Selbstlernende Software (SS).

Die Grundidee hierfür ist folgende: Man baut das Programm so, dass es sich schrittweise durch immer bessere Versionen seiner selbst ersetzen kann.

Sie zu produzieren, schreibt man sie so, dass die Funktion F sich selbst und das durch sie immer wieder anzuwendende Regelsystem ständig zufallsgesteuert abändert und jede entstandene neue Version des Paares (F,R) daraufhin untersucht, ob sich mit ihm bessere Ergebniss erzielen lassen als mit der alten: Wenn ja, ersetzt die neue Version die alte, ansonsten wird sie einfach verworfen.

Dieses Vorgehen funktioniert natürlich auch dann, wenn das Regelsystem leer ist, das Programm also einfach sich selbst modifiziert.

Natürlich hat dieser Ansatz zwei Nachteile:

Es ist daher kein Wunder, dass dieser Ansatz sich erst nach 2005 so richtig durchgesetzt hat. Wie sich erste Erfolge in 2016 dargestellt haben, skizziert ganz kurz ein Kommentar, der sich auf guteFrage.net findet. Wer inzwischen bessere Erfahrungen macht, möge sie dort ergänzen.

Die Methodik, die man heute (2016) als die wahrscheinlich beste sieht, SS zu schaffen, sind sog. künstliche Neuronale Netze (knN):

Ihre Funktionsweise soll so weit wie nur irgend möglich dem unseres Gehirns entsprechen. Hierzu muss man wissen:

Computerbaustein sind Hardware mit eingebautem, fest verdrahtetem Code. Sie also können sich nicht selbst modifizieren.

Nervenzellen im Gehirn dagegen sind durch Fasern verbunden, die — wie durch eine Wiese führende Trampelpfade — zunehmend ausgeprägter werden bzw. sich zunehmend zurückbilden, je nachdem wie stark man sie nutzt.

Dieses Vorbild lässt sich nutzen, indem man simulierten Computerbauteilen ähnliches Verhalten gibt: Hierzu könnte man die Schalter [ von denen oben in der Beschreibung des Computers die Rede war ] so manipulieren, dass nur ein hinreichend stark ankommender Impuls sie umlegt. Welchen Effekt die Ausführung eines Befehls s(0,N) dann also hat, bestimmt nicht allein dieser Befehl, sondern bestimmen wesentlich mit die derzeit in jedem Schalter gesetzten Widerstände.

Ob solches Verfahren aber schon auf Schalterebene Sinn macht oder erst für parallel abzuarbeitende Aufrufe umfangreicherer Komponenten — die Frage also, welche Teile des Systems man als Neuronen verstehen möchte —, ist eine Frage, die zu entscheiden auch wieder sehr viel Probieren erfordert.

Da keine durch einen digitalen Computer gefällte Entscheidung wirklicher Zufall sein kann — sondern stets nur auf Pseudozufallszahlen beruht — funktionieren natürlich auch künstliche neuronale Netze voll deterministisch (also nicht wirklich wie das Gehirn biologischer Lebewesen).

Außerdem muss klar sein: Wer knN als Vorbild und gültiges Modell für die Arbeit unseres Gehirns sieht, der verkennt, dass künstliche neuronale Netze ein ganz bestimmtes, von ihren E n t w i c k l e r n definiertes, gewünschtes Verhalten entwickeln sollen. Dies bedeutet, dass einzig und allein diese Entwickler Verantwortung dafür tragen, was mit » gewünscht « gemeint ist und wann dieser Anspruch als erfüllt gelten kann.

Wenn also jemand durch knN realisierte KI als "selbstorganisierend" bezeichnet, so ist das auf keinen Fall richtig.

Und natürlich ist entscheidend die — auch nur durch Menschen mögliche — Vorgabe von Kriterien, die erwünschte Ergebnisse von nicht erwünschten zu unterscheiden gestatten.

Derzeit besonders diskutiert werden einige speziellere Typen neuronaler Netze (gut dargestellt z.B. in Manfred Spitzer: Der Geist im Netz, Spektrum (2000).

Kohonen-Netze eignen sich gut zur Simulation der Teile unseres Gehirns, die primär Wahrnehmingsareale sind.

Zur Simulation des Hippocampus, der für den Datenabgleich von Innen und Außen zuständig ist und als Gedächtnis-Zwischenspeicher begrenzter Kapazität dient, eignen sich besonders Hopfield-Netze.

Mit Elman-Netzen ist das Zusammenspiel verschiedener Hirnareale recht gut nachbildbar.

Im Gegensatz zu einem in Hardware realisierten knN gibt es in bilologischen Neuronen-Netzen stets Rückwirkungen der Arbeit des Netzes auf seine Struktur. Sie sind nur in durch Software realisierten knN simulierbar.

Um mit einer begrenzten Zahl von Neuronen größere Mengen von Objekten nachbilden zu können, ist es notwendig, die zeitliche Dimension des Netzes als Chance zu begreifen. Untersuchungen hierzu haben viel Interessantes aufgezeigt. So wurde etwa entdeckt, dass Nervenzellen, die für das gleiche Objekt zuständig sind, mit hoher Genauigkeit synchron arbeiten, wohingegen das Feuern von Zellen, die verschiedene Objekte oder Prozesse bedienen, unsynchronisiert bleiben.

Lies auch:

Computer, KI und künstliche neuronale Netze (knN)

Jeden eingeschalteten Computer kann man sich vorstellen als

- eine Uhr, die als Taktgeber fungiert,

- zwei positive ganze Zahlen N und M mit N ≤ M

- und eine endlich lange Folge S(0,M) von Schaltern S(0), S(1), ..., S(M-1).

Man nennt sie den Hauptspeicher des Computers und s(0,M) seinen Zustand.

Dieser Zustand ist gegebenen durch die Stellungen all dieser Schalter, wobei aber jeder von ihnen nur in Stellung 0 oder 1 sein kann.

- Bei jedem Tick t der Uhr wird — in Abhängigkeit der Schalterstellungen s(0,N) —

eine Zahl m(t)

und zugleich die Stellung s(0,m(t)) sämtlicher Schalter S(0) bis S(m(t)) neu festgesetzt. Stets is N ≤ m(t).

Man nennt S(0,m(t)) den zur Zeit t belegten Speicher, s(0,m(t)) seinen Inhalt und s(0,N) den nächsten auszuführenden Befehl.

Wie man sieht, kann s(0,N) aufgefasst werden als eine Funktion, welche jedem Schalterzustand s(0,m) mit N ≤ m < M einen nächsten Speicherzustand s(0,M) zuordnet.

Jeder Computer ist so gebaut, dass neben den Konstanten N und M eine weitere Konstante T existiert mit N < T < M derart, dass immer dann, wenn s(0,N) ein Befehl ist, der den dann vorliegenden Speicherzustand s(0,M) in sich selbst überführt — der Computer also nichts mehr tut — der Abschnitt s(N,T) des Speicherzustandes s(0,M) durch Input von außen abgeändert werden kann. Typisches Beispiel wäre ein Signal, das von Tastatur oder Maus kommt.

Rein theoretisch spielt es keine Rolle, wie groß die Differenz T-N ist. Heutige Computer haben meist 64-Bit Bandbreite, so dass dann T-N = 64 ist.

Wie die eben gegebene Erklärung der Arbeitsweise jeden Computers zeigt, kennt er genau 2N Befehle. Jeder kann als Abbildung der Menge aller denkbaren Speicherzustände s(0,M) in sich aufgefasst werden. In welcher Reihenfolge sie ständig neu zur Anwendung kommen, bestimmen von außen nach S(N,T) geschriebene Eingaben.

Solche Eingaben können darstellen:

- von Programmierern geschrieben Programme,

- von Anwendern solcher Programme angelieferte Daten oder — und das ist eher ein Ausnahmefall —

- vom Bediener solcher Programme in den Bereich S(N,T) geschriebene Zeichen.

Sinnvolle Programme zu schreiben ist schwierig und zeitraubend. Hier nun setzt KI (sog. künstliche Intelligenz) an:

Man versteht darunter Programme, die besonders hohen Wirkungsgrad haben — mit relativ wenig Code also relativ viel erreichen.

Eine besonders einfache Form von KI ist bekannt geworden unter dem Stichwort Expertensysteme. Jedes Expertensystem ist einfach nur ein Programm P, welches auf eine gegebene Menge D von Daten immer und immer wieder eine durch ein Regelsystem R definierte Funktion F anwendet, welche die Menge der Daten sinnvoll vergrößert. Aus gegebenen Wissen D entsteht so schrittweise immer umfangreicheres Wissen bis hin zu dem Punkt, an dem es dann schließlich auch die Antwort auf eine vom Anwender vorher gestellte Frage beinhaltet.

Da nicht von vorn herein gesagt werden kann, wie oft die Funktion F den Datenbestand vergrößern muss bis die gesuchte Antwort endlich gefunden wir, ist klar: Expertensysteme sind umso mächtiger, je mächtiger der Computer ist, auf dem sie arbeiten, d.h. je kürzer seine Taktrate ist und je größer sein Speicher.

Über Expertensysteme hinaus gibt es noch einen zweiten, inzwischen schon weit entwickelten Lösungsansatz, den Wirkungsgrad von Programmcode zu erhöhen: Sog. Selbstlernende Software (SS).

Die Grundidee hierfür ist folgende: Man baut das Programm so, dass es sich schrittweise durch immer bessere Versionen seiner selbst ersetzen kann.

Sie zu produzieren, schreibt man sie so, dass die Funktion F sich selbst und das durch sie immer wieder anzuwendende Regelsystem ständig zufallsgesteuert abändert und jede entstandene neue Version des Paares (F,R) daraufhin untersucht, ob sich mit ihm bessere Ergebniss erzielen lassen als mit der alten: Wenn ja, ersetzt die neue Version die alte, ansonsten wird sie einfach verworfen.

Dieses Vorgehen funktioniert natürlich auch dann, wenn das Regelsystem leer ist, das Programm also einfach sich selbst modifiziert.

Natürlich hat dieser Ansatz zwei Nachteile:

- Erstens sind extrem mächtige Rechner notwendig, auf derart i n e f f i z i e n t e Weise nach neuen — besseren — Programmen zu suchen.

- Zweitens benötigt man extrem viele Beispiele, anhand deren sich prüfen lässt, ob eine weitgehend zufällig gewählte neue Version des Programms in der Mehrzahl aller Fälle bessere Ergebnisse liefert oder schneller zum Ziel kommt als die vorher genutze.

Es ist daher kein Wunder, dass dieser Ansatz sich erst nach 2005 so richtig durchgesetzt hat. Wie sich erste Erfolge in 2016 dargestellt haben, skizziert ganz kurz ein Kommentar, der sich auf guteFrage.net findet. Wer inzwischen bessere Erfahrungen macht, möge sie dort ergänzen.

Die Methodik, die man heute (2016) als die wahrscheinlich beste sieht, SS zu schaffen, sind sog. künstliche Neuronale Netze (knN):

Ihre Funktionsweise soll so weit wie nur irgend möglich dem unseres Gehirns entsprechen. Hierzu muss man wissen:

Computerbaustein sind Hardware mit eingebautem, fest verdrahtetem Code. Sie also können sich nicht selbst modifizieren.

Nervenzellen im Gehirn dagegen sind durch Fasern verbunden, die — wie durch eine Wiese führende Trampelpfade — zunehmend ausgeprägter werden bzw. sich zunehmend zurückbilden, je nachdem wie stark man sie nutzt.

Dieses Vorbild lässt sich nutzen, indem man simulierten Computerbauteilen ähnliches Verhalten gibt: Hierzu könnte man die Schalter [ von denen oben in der Beschreibung des Computers die Rede war ] so manipulieren, dass nur ein hinreichend stark ankommender Impuls sie umlegt. Welchen Effekt die Ausführung eines Befehls s(0,N) dann also hat, bestimmt nicht allein dieser Befehl, sondern bestimmen wesentlich mit die derzeit in jedem Schalter gesetzten Widerstände.

Ob solches Verfahren aber schon auf Schalterebene Sinn macht oder erst für parallel abzuarbeitende Aufrufe umfangreicherer Komponenten — die Frage also, welche Teile des Systems man als Neuronen verstehen möchte —, ist eine Frage, die zu entscheiden auch wieder sehr viel Probieren erfordert.

Da keine durch einen digitalen Computer gefällte Entscheidung wirklicher Zufall sein kann — sondern stets nur auf Pseudozufallszahlen beruht — funktionieren natürlich auch künstliche neuronale Netze voll deterministisch (also nicht wirklich wie das Gehirn biologischer Lebewesen).

Außerdem muss klar sein: Wer knN als Vorbild und gültiges Modell für die Arbeit unseres Gehirns sieht, der verkennt, dass künstliche neuronale Netze ein ganz bestimmtes, von ihren E n t w i c k l e r n definiertes, gewünschtes Verhalten entwickeln sollen. Dies bedeutet, dass einzig und allein diese Entwickler Verantwortung dafür tragen, was mit » gewünscht « gemeint ist und wann dieser Anspruch als erfüllt gelten kann.

Und natürlich ist entscheidend die — auch nur durch Menschen mögliche — Vorgabe von Kriterien, die erwünschte Ergebnisse von nicht erwünschten zu unterscheiden gestatten.

Derzeit besonders diskutiert werden einige speziellere Typen neuronaler Netze (gut dargestellt z.B. in Manfred Spitzer: Der Geist im Netz, Spektrum (2000).

- 1. Kohonen-Netze: Bei ihnen unterscheidet man

- eine Input-Schicht, die Daten empfängt, und

- eine Output-Schicht, die Daten aus den Netz an andere Systemkomponenten abgibt.

Charakteristisch für Kohonen-Netze ist, dass jedes Iutput-Neuron eine Verbindung hin zu einem Onput-Neuron hat und umgekehrt. Zudem ist jedes Output-Neuron mit jedem anderen Output-Neuron verbunden, und diese Verbindungen sind so geschaltet, dass bei Dateneingang auf einem Output-Neuron auch jeder seiner direkten mit ihm verbundenen Nachbarn auf aktiv geschaltet wird. Entferntere Neuronen aber werden in ihrer Aktivität geschwächt.

- 2. Hopfield-Netze: Bei ihnen ist jedes Neuron mit jedem anderen verbunden.

Dies hat zur Folge, dass ein Reiz an einem Neuron schon im nächsten Taktschritt alle anderen erreicht und im übernächsten dann auch wieder auf das erste Neuron zurückwirkt.

Dies kann dazu führen, dass das Netz in Reaktion auf einen Eingangsreiz so lange in anscheined ungeordnete Aktivität versetzt wird, bis Energieverluste sie abklingen lassen. Wichtiger ist, dass sich auch ein stabiler Zyklus ausbilden kann, der gutes Modell für einen dynamischen Speicher ist, der eine Anregung von außen als Gedächtniszustand bewahrt.

- 3. Elman-Netze: Sie vereinen die Vorteile beider und finden sich auch heute schon in so mancher technischer Anwendung.

Kohonen-Netze eignen sich gut zur Simulation der Teile unseres Gehirns, die primär Wahrnehmingsareale sind.

Zur Simulation des Hippocampus, der für den Datenabgleich von Innen und Außen zuständig ist und als Gedächtnis-Zwischenspeicher begrenzter Kapazität dient, eignen sich besonders Hopfield-Netze.

Mit Elman-Netzen ist das Zusammenspiel verschiedener Hirnareale recht gut nachbildbar.

Im Gegensatz zu einem in Hardware realisierten knN gibt es in bilologischen Neuronen-Netzen stets Rückwirkungen der Arbeit des Netzes auf seine Struktur. Sie sind nur in durch Software realisierten knN simulierbar.

Um mit einer begrenzten Zahl von Neuronen größere Mengen von Objekten nachbilden zu können, ist es notwendig, die zeitliche Dimension des Netzes als Chance zu begreifen. Untersuchungen hierzu haben viel Interessantes aufgezeigt. So wurde etwa entdeckt, dass Nervenzellen, die für das gleiche Objekt zuständig sind, mit hoher Genauigkeit synchron arbeiten, wohingegen das Feuern von Zellen, die verschiedene Objekte oder Prozesse bedienen, unsynchronisiert bleiben.

Lies auch:

- Stefan Strecker: Künstliche Neuronale Netze – Aufbau und Funktionsweise (2004)

- The Tiling Algorithm: Wie neuronale Netze lernen (1989)

- Google's KI AlphaGo erzielt beeindruckende Lernerfolge (2017)

- Google's AutoML Project: Hier entsteht KI, die bessere KI schreiben kann als seine Entwickler (2017)

Beitrag 0-236

Das Wesen des Bewusstseins

Das Wesen des Bewusstseins

( nach Görnitz )

Aus dem hier Gesagten ergibt sich insbesondere, dass

auf klassischen Computern implementierte KI keinerlei Bewusstsein haben kann.

Quelle: Thomas &

Brigitte Görnitz: Der krative Kosmos, Spektrum-Verlag (2002), Kap. 12.4, S. 314-320

( nach Görnitz )

Brigitte und Thomas Görnitz (2002):

Ein Mensch ist bewusst, wenn er sich dessen bewusst werden kann.

Man erkennt hieraus: Wesen mit Bewusstsein müssen in der Lage sein, sich selbst zu reflektieren. Wie im folgenden gezeigt wird, ist das nur möglich, wenn die konkrete Information, welche ihr Wissen über sich selbst darstellt, durch einen quantenphysikalischen Zustand ihres Gedächtnisses gegeben ist:

Das Wesen des Bewusstseins wird erkennbar an seiner höchsten Stufe, dem reflektierenden Bewusstsein: Es muss in der Lage sein, sich bis hin zum Selbstbewusstsein entwickeln zu können.

Selbst der Mensch erwirbt die Fähigkeit zum Ich-Bewusstsein erst n a c h seiner Geburt.

Reflektiertes Bewusstsein ist Information, die sich selbst kennt. Bewusstsein an sich muss also das Potential haben, sich selbst zu kennen.

Sich selbst reflektierendes Bewusstsein muss die Möglichkeit haben, konkrete Information über sich selbst auf eine echte Teilmenge dieser Information quasi "isomorph" abzubilden. Dies kann — schon aus mathematischen Gründen heraus — nur dann gelingen, wenn der Zustandsraum des dem Bewusstsein zur Vergüngung stehenden Gedächtnisses unendlich große Kardinalität hat, d.h. wenn er ein quantentheoretischer Zustandsraum ist.

Denn: Klassische Strukturen sind eindeutig, können also nur endlichen Zustandsraum haben.

Beweis: Sollte ein Zustandsraum isomporph auf eine Teilmenge seiner selbst abbildbar sein, wäre er nicht eindeutig.

Aus dem hier Gesagten ergibt sich insbesondere, dass

Beitrag 0-241

KI kann menschliches Denken unterstützen und beschleunigen — aber nicht ersetzen

KI kann nur scheinbar selbst denken

Mit der Enwicklung immer leistungsfähigerer Geräte zur Datenverarbeitung stellt sich so mancher die Frage, ob KI oder durch sie gesteuerte Roboter den Menschen nicht irgendwann werden ersetzen können.

Kann KI Bewusstein haben, vielleicht sogar ein sich selbst reflektierendes Bewusstsein?

Die Antwort ist ein klares NEIN.

So schreiben etwa Thomas und Brigitte Görnitz absolut zutreffend:

Die Zahl der Verfahren, die denkbar erscheinen, Regelwerke bestmöglich zu nutzen, braucht nicht begrenzt zu sein. Bis heute allerdings sind nur zwei Klassen solcher Verfahren bekannt:

Beide Verfahren erreichen ihre Grenzen dort, wo keine hinreichend mächtigen Rechner zur Verfügung stehen: Was sie zu leisten imstande sind, wird stets in erster Näherung proportional zu den ihnen zur Verfügung gestellten CPU- und Speicher-Ressourcen sein.

Dass KI auf diese Weise gelegentlich auch irgendwo schon existierendes Wissen finden kann, nach dem Menschen zu lange hätten suchen müssen, ist klar.

Erfindungen zu machen oder richtige Antworten zu erahnen — wie Menschen es können — ist jeder KI unmöglich.

Mit der Enwicklung immer leistungsfähigerer Geräte zur Datenverarbeitung stellt sich so mancher die Frage, ob KI oder durch sie gesteuerte Roboter den Menschen nicht irgendwann werden ersetzen können.

Kann KI Bewusstein haben, vielleicht sogar ein sich selbst reflektierendes Bewusstsein?

Die Antwort ist ein klares NEIN.

So schreiben etwa Thomas und Brigitte Görnitz absolut zutreffend:

Görnitz (2002, sinngemäß):

Wenn es sich bei den von manchen erhofften Systemen des » künstlichen « Lebens um biologische Einheiten handelte — was bis heute nicht der Fall ist —,

so wären sie wohl tatsächlich Lebewesen, von denen nicht auszuschließen wäre, dass sich ihre Art ohne Zutuin des Menschen fortentwickelt.

Bei Objekten aber, die auf Basis heutiger Mikroprozessoren gebaut werden, oder nur Software sind, kann stets nur von s i m u l i e r t e r Intelligenz gesprochen werden.

Auch bewusstsein-ähnliches Verhalten können sie nur simulieren — dies allerdings, wie sich heute schon zeigt, in ganz erstaunlicher Perfektion.

Dennoch darf das nicht als Hinweis darauf gesehen werden, dass bei ihnen echtes Bewusstsein auch nur ansatzweise gegeben ist:

In einem mathematisch strengen Sinn haben sie nur streng deterministisches Verhalten, ganz ähnlich einem Fotoapparat, der Bilder zwar getreu wiedergibt, dem aber auch nicht im Entferntesten klar ist, was sie inhaltlich zeigen.

Pseudozufallszahlen zu verwenden oder auf tatsächlich absolut zufällig eintreffen Signale von außen zu reagieren, ändert nichts daran.

Tatsache aber ist:

Die Perfektion, mit der sich Leben, Bewusstsein und Intelligenz simulieren (vortäuschen) lässt, kann stets nur in dem Ausmaß zunehmen, in dem es dem Menschen gelingt, das Verhalten echter Lebewesen zu analysieren und durch Regelwerke zu beschreiben.

Das simulierte Verhalten kann niemals besser sein — wird aber kaum weniger gut sein — als die Regeln, welche Menschen durch solche Analyse gefunden haben.

Die Zahl der Verfahren, die denkbar erscheinen, Regelwerke bestmöglich zu nutzen, braucht nicht begrenzt zu sein. Bis heute allerdings sind nur zwei Klassen solcher Verfahren bekannt:

- Zum einen Expertensysteme: Sie errechnen transitive Hüllen ihnen gegebener Information.

- Zum anderen künstliche neuronale Netze: Sie unterstützen Muster-Erkennung und lassen sich trainieren mit dem Ziel, vorgegebene Erfahrungen immer besser zu nutzen bis fast hin zu dem Punkt, an dem, was sie dann als Antwort auf eine ihnen gestellte Frage geben, schon fast so treffend sein kann, wie Antworten, die zu finden Menschen viel Nachdenken und langes Durchstöbern von Büchern oder Datenbanken kosten könnte.

Beide Verfahren erreichen ihre Grenzen dort, wo keine hinreichend mächtigen Rechner zur Verfügung stehen: Was sie zu leisten imstande sind, wird stets in erster Näherung proportional zu den ihnen zur Verfügung gestellten CPU- und Speicher-Ressourcen sein.

Dass KI auf diese Weise gelegentlich auch irgendwo schon existierendes Wissen finden kann, nach dem Menschen zu lange hätten suchen müssen, ist klar.

Erfindungen zu machen oder richtige Antworten zu erahnen — wie Menschen es können — ist jeder KI unmöglich.

Beitrag 0-267

Warum keine KI biologische Gehirne ersetzen kann

Künstliche Intelligenz (KI) denkt rein algorithmisch. Genau deswegen kann sie menschliches Denken nicht ersetzen, denn:

Menschliches Denken ist mächtiger als algorithmisches Denken

Diese Erkenntnis bescherte uns Gödels Beweis für seinen Unvollständigkeitssatz.

Ausgehend von irgend einem formalen System, welches mächtig genug ist, wenigstens die Arithmetik aller natürlichen Zahlen zu beschreiben, fand Gödel — mit Hilfe von Cantors Diagonalverfahren — eine Aussage Pk(k),

Wir sehen: Keine KI kann biologische Gehirne — wie etwa das von Gödel — ersetzen.

Diese Erkenntnis bescherte uns Gödels Beweis für seinen Unvollständigkeitssatz.

Ausgehend von irgend einem formalen System, welches mächtig genug ist, wenigstens die Arithmetik aller natürlichen Zahlen zu beschreiben, fand Gödel — mit Hilfe von Cantors Diagonalverfahren — eine Aussage Pk(k),

- welche in diesem System formulierbar, aber doch nicht ableitbar ist,

- obgleich Menschen sie als wahr erkennen können.

Penrose (auf S. 105 seines Buches Computerdenken) nennt Konsequenzen davon:

Aber warum sollte uns diese spezielle Aussage Pk(k) beunruhigen?

Wie wir im Laufe obiger Beweisführung festgestellt haben, konnten wir einsehen, dass Pk(k) wahr ist. Formalisten — Leute, die nur formales Denken gelten lassen wollen — sollte das beunruhigen, denn gerade durch unsere Schlußfolgerung haben wir bewiesen, dass der formalistische Begriff von » Wahrheit « notwendigerweise unvollständig ist.

Sollte man also überhaupt nicht von Wahrheit reden, sondern nur von Beweisbarkeit innerhalb eines bestimmten formalen Systems [einer KI]?

Von diesem Standpunkt aus aber könnte man Gödels Argumentation in ihrer oben gegebenen Gestalt nicht entwickeln, denn wesentliche Teile dieser Beweisführung beruhen auf Schlussfolgerungen darüber, was tatsächlich wahr bzw. nicht wahr ist.

Beitrag 0-459

Autopiloten sind die bisher erfolgreichsten Roboter

Autonome Fahrzeuge: Die bisher "intelligentesten" Roboter

Man lese z.B.

Pressemeldung Ende Juni 2024:

Man lese z.B.

- 2019: Autopiloten sind bis zu 9 Mal geschickter als durchschnittlich begabte menschliche Fahrzeuglenker

- 2020: Tesla is Years ahead of Toyota and VW — Elon Musk könnte seine Autos schon 2020 voll autonom fahren lassen.

- 2024: Robotaxis nun bald auch in Deutschland?

Pressemeldung Ende Juni 2024:

-

Robotaxi-Dienst nun frei verfügbar

Die Robotaxi-Firma Waymo hat einen Meilenstein erreicht: In San Francisco gibt es keine Warteliste für den Dienst mehr, sondern alle Interessenten könnten sofort einen Account anlegen. Man habe jahrelang auf diesen Tag zugearbeitet, betonte das Google-Schwesterunternehmen. Robotaxis von Waymo sind in Phoenix im US-Bundesstaat Arizona sowie in San Francisco und Los Angeles in Kalifornien unterwegs.

Sie dürfen inzwischen komplett ohne Menschen am Steuer fahren.

Beitrag 0-3

Deterministisch arbeitende KI wird nicht Schlusspunkt prinzipiell möglicher KI sein

Zur Zukunft künstlicher Intelligenz

So wie in der Vergangenheit

So wie in der Vergangenheit

- die Geometrie erst so richtig ihren Aufschwung nahm, als entdeckt wurde, dass es neben der euklidischen Geometrie auch noch zwei grundsätzlich verschiedene Klassen nicht-euklidischer Geometrien gibt,

- und ebenso wie die Physik erst wirklich bedeutend wurde, nachdem neben ihre klassische Form die Quantenmechanik getreten war,

- so wird auch künstliche Intelligenz erst dann volle Größe zeigen, wenn ihre deterministisch arbeitende Form (die KI von heute) eine sehr viel mächtigere Schwester bekommt, welche die Alleinherrschaft der Logik ersetzt durch ein Zusammenwirken von absolutem Zufall einerseits und doch auch strenger Logik andererseits (die dann auch für Selektion im evolutionstechnischen Sinne verantwortlich sein wird).

Beitrag 0-2

Erkenntnistheoretische Grenzen deterministisch arbeitender KI

Was Intelligenz von künstlicher Intelligenz (KI) unterscheidet

Unter Intelligenz versteht man einen Mechanismus, der eine Entwicklung zielgerichteter macht als wenn sie nur durch Zufall getrieben stattfände.

Man spricht von künstlicher Intelligenz (KI), wenn jener Mechanismus von Menschen geschaffen und durch ein Regelwerk gesteuert wird, dessen Sinn zu hinterfragen er selbst nicht in der Lage ist.

Man baut KI-Systeme, damit sie

David Deutsch drückt es ganz konkret so aus:

Quelle: David Deutsch: The Fabric of Reality, Penguin Books 1997, page 11.

Ob der Erkenntnissfähigkeit menschlicher Intelligenz prinzipielle Grenzen gesetzt sind, wissen wir nicht.

Künstliche Intelligenz aber kann keinesfalls jede durch uns Menschen entscheidbare Frage beantworten. Kurt Gödels Beweisführung für seinen Unvollständigkeitssatz nämlich zeigt: Zu jeder KI, die mindestens die Arithmetik natürlicher Zahlen kennt, gibt es Aussagen über die Fähigkeiten dieser KI, die menschliche Intelligenz als wahr erkennen kann, obgleich jene KI selbst sie ganz grundsätzlich nicht betrachten (oder gar als wahr oder falsch einstufen) kann.

Anders ausgedrückt: Gödel hat bewiesen, dass

Man überlegt sich auch: Selbst wenn wir einen Computer hätten, der niemals aufhört zu rechnen und niemals an Speichergrenzen stößt, wäre kein Algorithmus denkbar, der mit Hilfe dieses Computers alle Aussagen über ganze Zahlen als wahr oder falsch zu erkennen in der Lage wäre (oder im Zuge unendlich langer Rechnung auch nur betrachten könnte). Dies einzusehen, reicht es, nachzuweisen, dass die Menge jener Aussagen überabzählbar groß ist. Wir wüssten dann nämlich, dass es keine Möglichkeit geben kann, sie alle aufzulisten — auch dann nicht, wenn diese Liste unendlich lang werden dürfte.

Hallo Uwe,

dem eben Gesagten entsprechend hat man deine Fragen aus Beitrag 2120-1 zu beantworten wie folgt:

Aber natürlich können KI-Systeme miteinander kommunizieren (was letztlich bedeutet, dass sich mehrere davon zu einem größeren zusammenfügen). Wo sie sich gegenseitig modifizieren oder gar zerstören, können sie das — wenn überhaupt — nur als Versagen ihrer selbst wahrnehmen.

Kurz: KI-Systeme sind durch Regelsysteme gesteuerte Mechanismen zur Fortschreibung des Zustandes physischer Objekte (mindestens ihres Speicherinhaltes). Sinn ergibt sich daraus erst in den Augen kreativer Intelligenz. Sie kann solche Systeme zur Erarbeitung von Wissen einsetzen, aber z.B. auch zum Finden, Zerstören, Bauen oder Abändern anderer Systeme. KI ist für kreative Intelligenzen in etwa das, was ein Auto, ein Schiff, oder ein Flugzeug für einen Reisenden ist: Stets nur für gewisse Abschnitte des beabsichtigten Weges brauchbar, wird solches Werkzeug Distanzen verkürzen, die zu überwinden sonst nicht gelänge (und schon gar nicht in vergleichbar kurzer Zeit). Mit anderen Worten: Künstliche Intelligenz (KI) vergrößert die Reichweite kreativer Intelligenz, kann aber stets nur schon vorgedachte Wege gehen: KI ist einfach nur Software.

Natürlich stellt sich dann die Frage, welche Art von Software man als KI bezeichnet. Die Antwort darauf:

Je genauer die Aufgaben spezifiziert sein müssen, die der Anwender seinem Software-System gibt, desto weniger wird man es als KI bezeichen.

Gruß, grtgrt

PS: Völlig richtig (und ganz selbstverständlich) scheint mir, dass kreative Intelligenz nicht notwendig menschliche Intelligenz sein muss:

Uwe hat völlig recht:

Auch Systemversagen kann zu einer Situation führen, die rein zufällig sinnvoller ist als die, die das System — seinem Regelsystem entsprechend — eigentlich hätte herstellen sollen. Solches Fehlverhalten könnte zu einer Entdeckung führen, die man sonst niemals gemacht hätte. Da die dann entstandene Situation aber eine ist, auf die das Regelsystem überhaupt nicht mehr vorbereitet ist, wird KI — wenn sie keine zufälligen Ergebnisse toleriert — an dieser Stelle zusammenbrechen.

Dieser Überlegung wegen vermute ich, dass kreative Intelligenz eine Kombination aus Regelsystem und automatischer Zurückführung unerwarteter Ausnahmesituationen jeder Art auf durch das Regelsystem abgedeckte Situationen sein muss.

Die Wurzel von Kreativität wäre dann einfach nur absoluter Zufall — letztlich also Quantenfluktuation —

gepaart mit der Fähigkeit, gelegentlich auch Unerwartetes als Gewinn sehen zu können.

Auf jeden Fall ist auch unser sog. B a u c h g e f ü h l etwas, das menschliche Intelligenz von künstlicher unterscheidet:

Hans-m macht uns zu Recht darauf aufmerksam, dass natürliche Intelligenz:

Solange KI nicht auch teilweise durch absoluten Zufall gesteuert arbeitet, kann sie ganz grundsätzlich nur Lösungswege gehen, die man ihr beigebracht hat. Nur kreative Intelligenz findet selbst dort noch Lösungen, wo es k e i n e vorgedachten Lösungswege gibt.

Hans-m nennt folgendes Beispiel:

Siehe auch: Howard Gardener: Kreative Intelligenz: Was wir mit Mozart, Freud, Woolf und Gandhi gemeinsam haben, Piper 2002.

Siehe auch: Der grundlegenden Unterschied zwischen Mensch und Maschine — Gödel hat ihn aufgedeckt.

Fazit all dieser Überlegungen:

Solange KI so arbeitet, wie man das bisher als einzig denkbaren Weg kennt,

wird sie nie alle für den menschlichen Geist charakteristischen Fähigkeiten haben können.

Dies bedeutet aber nicht, dass KI-Forschern nicht irgendwann ein völlig neuer Ansatz einfallen könnte, mit dessen Hilfe es dann doch gelingt,

Roboter zu bauen, die menschliche Fähigkeiten in JEDER Hinsicht haben — den Menschen dann also komplett degradieren könnten.

Wie sich derzeit denkbare KI mehr und mehr in unserem Alltagsleben breit macht, wird recht treffend skizziert in Reportagen und Erfolgsmeldungen wie z.B.

Selbst hiervon noch weit entfernt sind:

Nebenbei:

Unter Intelligenz versteht man einen Mechanismus, der eine Entwicklung zielgerichteter macht als wenn sie nur durch Zufall getrieben stattfände.

Man spricht von künstlicher Intelligenz (KI), wenn jener Mechanismus von Menschen geschaffen und durch ein Regelwerk gesteuert wird, dessen Sinn zu hinterfragen er selbst nicht in der Lage ist.

Man baut KI-Systeme, damit sie

- Information, die in gegebener Information implizit vorhanden ist, schnell und möglichst umfassend explizit machen (Automatisierung logischer Schlußfolgerung durch sog. Expertensysteme)

- oder auf eingehende neue Information ähnlich sinnvoll reagieren wie ein Mensch das tun würde (Ersetzen menschlicher Arbeitskraft durch Industrieroboter).

- der gegebenen bzw. fehlenden Fähigkeit, kreativ zu sein,

- aber auch darin, dass künstliche Systeme kaum ermüden: Sie sind Werkzeug, das der Mensch sich schuf, den Aktionsradius seines Denkens und Handelns zu erweitern; Ihn voll ersetzen können sie nicht.

David Deutsch drückt es ganz konkret so aus:

David Deutsch

Understanding is one of the higher functions of the human mind and brain, and a unique one.

Many other physical systems, such as animals' brains, computers, and other machines, can assimilate facts and act upon them.

But at present we know of nothing that is capable of understanding an explanation — or of wanting one in the first place — other than a human mind. Every discovery of a new explanation, and every act of grasping an existing explanation, depends on the uniquely human faculty of creative thought.

Ob der Erkenntnissfähigkeit menschlicher Intelligenz prinzipielle Grenzen gesetzt sind, wissen wir nicht.

Künstliche Intelligenz aber kann keinesfalls jede durch uns Menschen entscheidbare Frage beantworten. Kurt Gödels Beweisführung für seinen Unvollständigkeitssatz nämlich zeigt: Zu jeder KI, die mindestens die Arithmetik natürlicher Zahlen kennt, gibt es Aussagen über die Fähigkeiten dieser KI, die menschliche Intelligenz als wahr erkennen kann, obgleich jene KI selbst sie ganz grundsätzlich nicht betrachten (oder gar als wahr oder falsch einstufen) kann.

Anders ausgedrückt: Gödel hat bewiesen, dass

- menschliche Intelligenz die jeder KI übertrifft

- und der Mensch selbst noch die F ä h i g k e i t e n künstlicher Intelligenz umfassender erforschen kann als das ihr selbst möglich ist.

Man überlegt sich auch: Selbst wenn wir einen Computer hätten, der niemals aufhört zu rechnen und niemals an Speichergrenzen stößt, wäre kein Algorithmus denkbar, der mit Hilfe dieses Computers alle Aussagen über ganze Zahlen als wahr oder falsch zu erkennen in der Lage wäre (oder im Zuge unendlich langer Rechnung auch nur betrachten könnte). Dies einzusehen, reicht es, nachzuweisen, dass die Menge jener Aussagen überabzählbar groß ist. Wir wüssten dann nämlich, dass es keine Möglichkeit geben kann, sie alle aufzulisten — auch dann nicht, wenn diese Liste unendlich lang werden dürfte.

Hallo Uwe,

dem eben Gesagten entsprechend hat man deine Fragen aus Beitrag 2120-1 zu beantworten wie folgt:

- KI-Systeme können bestenfalls selbstlernend, aber niemals selbstbegreifend sein.

- Sie können weder emotionsartige Zustände annehmen, noch irgend einem Wahn verfallen.

- Der Unterschied zwischen kreativer und nicht kreativer Intelligenz ist ihnen nicht beizubringen.

- Ob sie aus Software oder Hardware bestehen, können sie von sich aus nicht entscheiden.

- KI kann weder Gefühle noch eigenen Willen haben: Sie ist nur Mechanismus.

Aber natürlich können KI-Systeme miteinander kommunizieren (was letztlich bedeutet, dass sich mehrere davon zu einem größeren zusammenfügen). Wo sie sich gegenseitig modifizieren oder gar zerstören, können sie das — wenn überhaupt — nur als Versagen ihrer selbst wahrnehmen.

Kurz: KI-Systeme sind durch Regelsysteme gesteuerte Mechanismen zur Fortschreibung des Zustandes physischer Objekte (mindestens ihres Speicherinhaltes). Sinn ergibt sich daraus erst in den Augen kreativer Intelligenz. Sie kann solche Systeme zur Erarbeitung von Wissen einsetzen, aber z.B. auch zum Finden, Zerstören, Bauen oder Abändern anderer Systeme. KI ist für kreative Intelligenzen in etwa das, was ein Auto, ein Schiff, oder ein Flugzeug für einen Reisenden ist: Stets nur für gewisse Abschnitte des beabsichtigten Weges brauchbar, wird solches Werkzeug Distanzen verkürzen, die zu überwinden sonst nicht gelänge (und schon gar nicht in vergleichbar kurzer Zeit). Mit anderen Worten: Künstliche Intelligenz (KI) vergrößert die Reichweite kreativer Intelligenz, kann aber stets nur schon vorgedachte Wege gehen: KI ist einfach nur Software.

Natürlich stellt sich dann die Frage, welche Art von Software man als KI bezeichnet. Die Antwort darauf:

Je genauer die Aufgaben spezifiziert sein müssen, die der Anwender seinem Software-System gibt, desto weniger wird man es als KI bezeichen.

- Software, die nicht KI ist, wären z.B. ein Texteditor, ein Buchhaltungssystem, ein Flugbuchungssystem oder ein Portal für Online-Shopping. Sie alle erwarten ständig neue Eingaben und erledigen vor allem Anweisungen, deren Ergebnis nicht wesentlich umfangreicher ist als die Eingabe selbst.

- Ganz anders KI-Software: Sie erledigt eher Aufgaben des Typs: Berechne (oder erledige) einfach alles, was unter dieser oder jener einschränkenden Randbedingung überhaupt berechenbar ist (bzw. automatisch erledigt werden kann). Die Intelligenz von KI besteht darin, gegebenes Wissen über berechenbare Schlussfolgerungen in beliebig vielen Schritten erweitern zu können. Einmal aktiviert arbeitet sie typischerweise bis alle ihr zur Verfügung gestellten Ressourcen verbraucht sind. Auf diese Weise wird so ein System, die ihm gestellte Aufgabe zwar nie ganz erledigen, aber doch recht häufig Ergebnisse liefern, die sehr wertvoll sind, obgleich sie nicht selten gar nicht vorhersehbar waren.

Gruß, grtgrt

PS: Völlig richtig (und ganz selbstverständlich) scheint mir, dass kreative Intelligenz nicht notwendig menschliche Intelligenz sein muss:

Uwe aus 2120-77

Wenn ich mir einen Vogel anschaue, dann hat der doch schon relativ intelligente Züge in seiner Lebensweise. Irgend ein Programm muss ihm ja mitteilen, dass er für die Aufzucht seiner Brut ein Nest braucht, also muss er rechtzeitig passendes Baumaterial dafür suchen und es geschickt an einem passenden Ort verbauen. Können wir ausschließen, dass das vollkommen frei von Intelligenz passiert? Oder Krähen, die Nüsse auf die Fahrbahn werfen, damit sie von den darüberfahrenden Autos geknackt werden...